新元胞生长算法:神经网络训练效率与质量提升

需积分: 50 129 浏览量

更新于2024-07-18

收藏 677KB PDF 举报

本文主要探讨了神经网络训练中的优化算法性能,特别是在监督学习领域的重要性。研究者旨在通过比较新提出的metaheuristic蝙蝠算法(BA)与其他标准算法,如反向传播(Back Propagation)、Levenberg-Marquardt、蝙蝠算法(Bat Algorithm)、遗传算法(Genetic Algorithm)和粒子群优化(Particle Swarm Optimization),展示BA在时间效率和解决方案质量上的优势。实验在标准数据集Proben1上进行,该数据集源自医学问题,以便于未来的研究者进行对比。

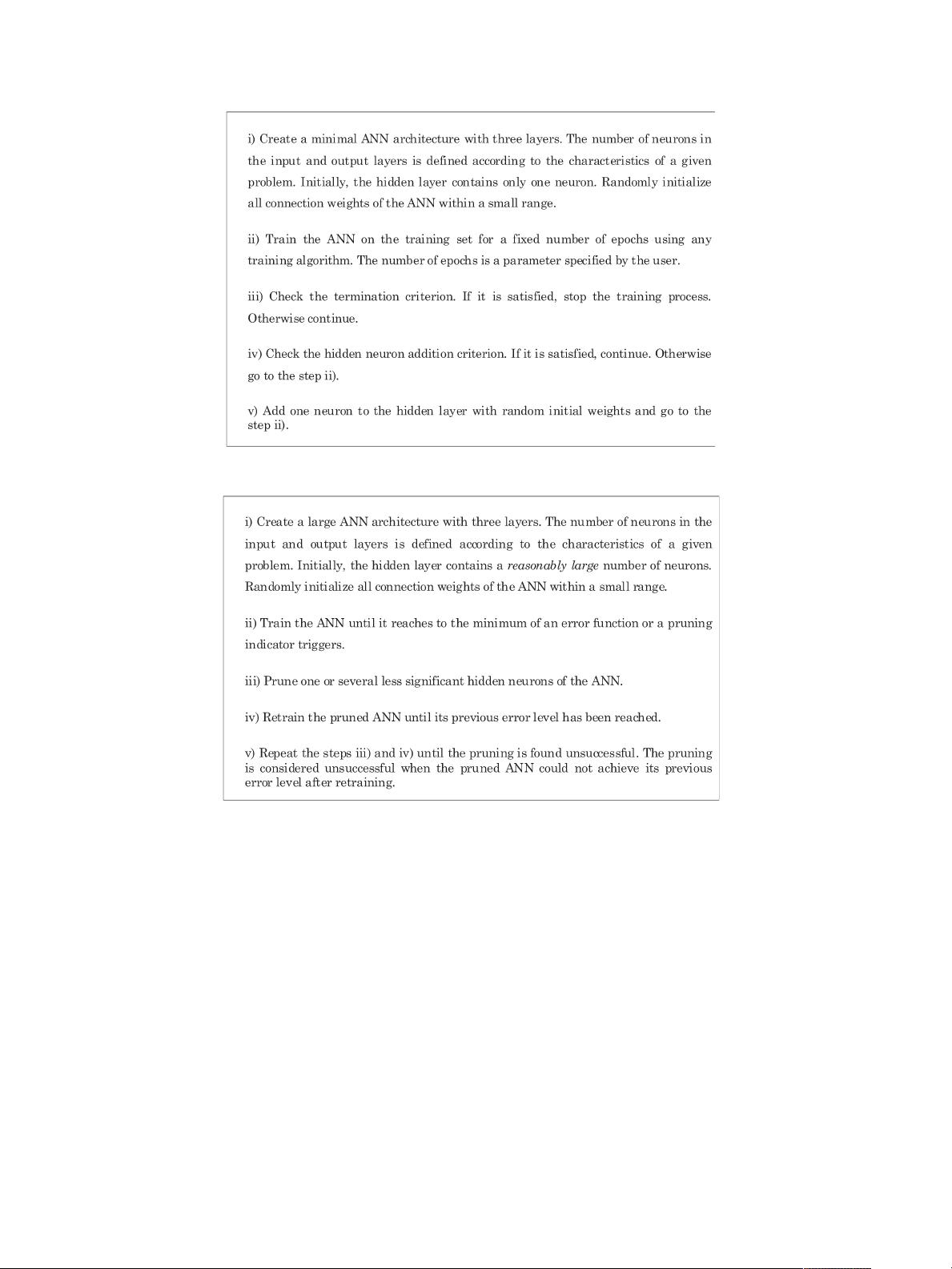

Proben1作为选定的基准测试集,其包含了实际应用中的医学问题,使得结果具有广泛的实际意义。文章特别提到了一种名为"ANew Adaptive Merging and Growing Algorithm for Designing Artificial Neural Networks"(2009年7月在《IEEE Transactions on Systems, Man, and Cybernetics – Part B》发表)的算法,它是一种自适应合并和生长算法,用于人工神经网络的设计。虽然没有直接提到AMGA算法,但可以推测这个算法可能与神经网络结构的自适应调整有关,可能是作者们用来改进神经网络设计的一种方法。

文章作者包括Kazi Md. Rokibul Alam、Md Ashiqul Islam、Faijul Amin等,他们在神经网络领域的项目有系列工作,例如Kazi Md. Rokibul Alam的时序预测项目和Faijul Amin关于神经网络的应用。此外,还有Kazuyuki Murase教授,他在大学的科研产出丰硕,对神经网络优化算法有着深入的研究。

值得注意的是,论文内容已经接受了期刊的最终版发表,但可能在页面布局上还存在后续编辑的可能。总体来说,这篇论文不仅关注神经网络的训练优化,而且展示了新算法在实际问题中的竞争力,为其他研究人员提供了有价值的数据和比较点,对于提高eLearning环境下的神经网络训练效率具有实际指导意义。

265 浏览量

点击了解资源详情

209 浏览量

1614 浏览量

186 浏览量

135 浏览量

orange_258312241

- 粉丝: 1

最新资源

- Openaea:Unity下开源fanmad-aea游戏开发

- Eclipse中实用的Maven3插件指南

- 批量查询软件发布:轻松掌握搜索引擎下拉关键词

- 《C#技术内幕》源代码解析与学习指南

- Carmon广义切比雪夫滤波器综合与耦合矩阵分析

- C++在MFC框架下实时采集Kinect深度及彩色图像

- 代码研究员的Markdown阅读笔记解析

- 基于TCP/UDP的数据采集与端口监听系统

- 探索CDirDialog:高效的文件路径选择对话框

- PIC24单片机开发全攻略:原理与编程指南

- 实现文字焦点切换特效与滤镜滚动效果的JavaScript代码

- Flask API入门教程:快速设置与运行

- Matlab实现的说话人识别和确认系统

- 全面操作OpenFlight格式的API安装指南

- 基于C++的书店管理系统课程设计与源码解析

- Apache Tomcat 7.0.42版本压缩包发布