Spark RDD:内存计算与容错机制解析

需积分: 32 33 浏览量

更新于2024-07-18

2

收藏 1.44MB PDF 举报

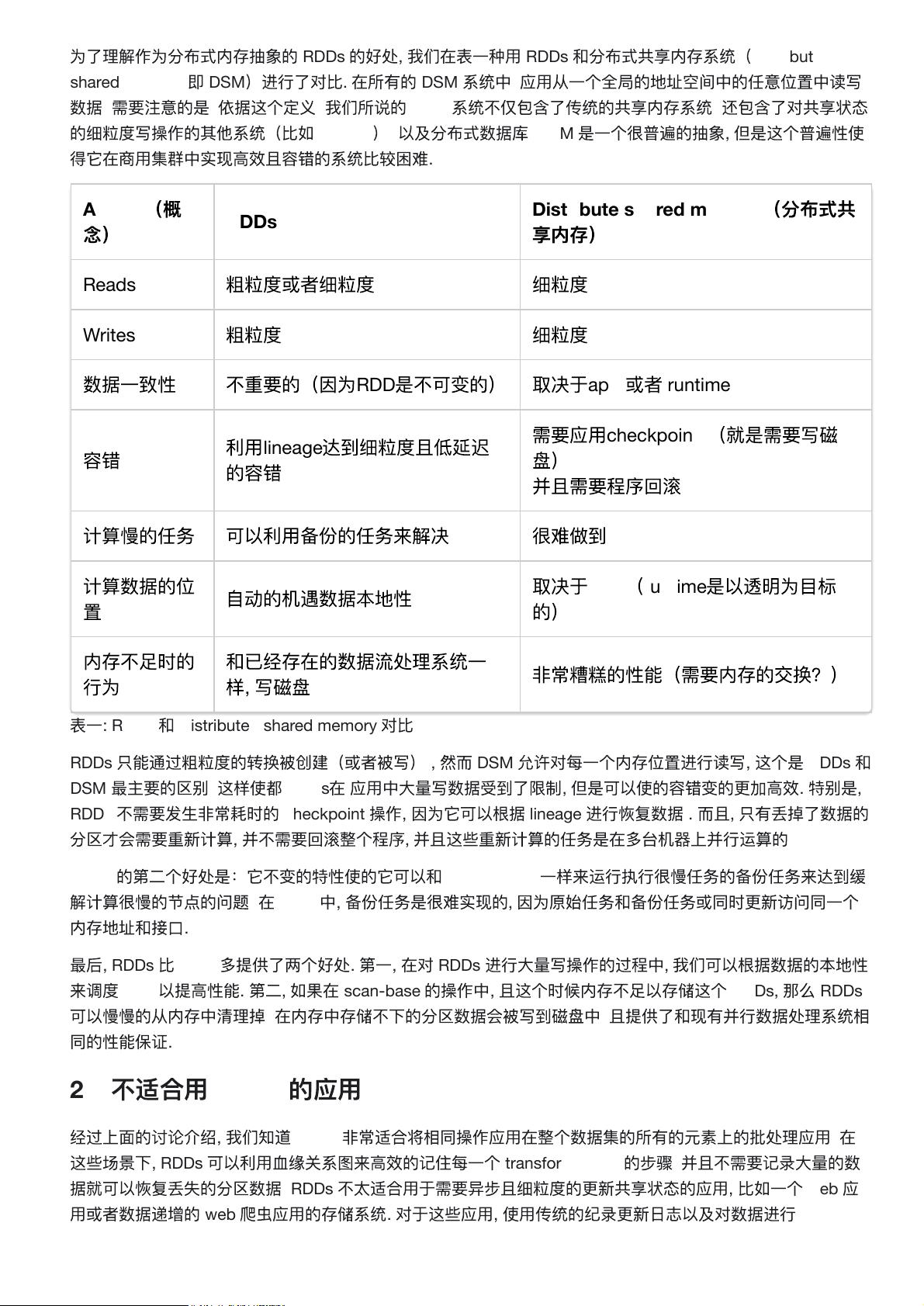

"SparkRDD论文中文版主要探讨了Resilient Distributed Datasets (RDD)的概念,这是一种用于大规模集群计算的容错内存计算模型。RDDs的设计目标是解决现有框架在处理迭代算法和交互式数据挖掘时效率低下的问题,通过保持数据在内存中,显著提升了性能。RDDs提供了一种粗粒度转换的共享内存模型,以实现高效的容错机制。论文还分析了RDDs能够表达多种计算类型,不仅包括类似Pregel的迭代计算模型,还支持其他现有模型无法表达的计算。

1: 介绍部分提到,尽管MapReduce和Dryad等分布式计算框架在大数据分析中广泛应用,但它们缺乏对分布式内存的有效抽象。这导致在处理需要复用中间结果的迭代计算时效率低下,尤其是在机器学习和图计算中。

2: RDD抽象部分详细阐述了RDD的核心特性,即它是不可变的、分区的记录集合,具有血统信息,允许快速恢复丢失的数据。Spark编程接口允许用户创建和操作RDD,通过一系列高级操作实现并行计算。

2.2.1 例子–监控日志数据挖掘展示了如何使用Spark的RDD API来处理和分析监控日志数据,体现了RDDs在实际应用中的灵活性。

2.3 RDD模型的优势在于其高效的容错能力,以及在内存计算中带来的性能提升,特别是对于迭代算法和交互式任务。

3.1 Spark中RDD的操作介绍了RDD支持的各种操作类型,如转换(transformations)和行动(actions),转换不会立即执行,而是在需要时通过血统信息计算。

3.2.1 线性回归和3.2.2 PageRank的实例展示了RDDs如何应用于机器学习和图计算任务。

4: 表达RDDs部分深入讨论了RDDs如何表达各种计算模式,证明了其广泛适用性。

5: 实现部分详细描述了Spark的内部机制,包括作业调度、解释器集成、内存管理和检查点支持,这些都是实现高效、容错的RDD计算的关键。

6: 评估部分通过不同应用场景(如迭代式机器学习、PageRank计算)和容错测试,展示了RDDs在性能和容错方面的优势。

7: 讨论部分比较了RDDs与其他编程模型,并讨论了RDDs在调试中的帮助。

8: 相关工作部分回顾了与RDDs相关的研究,指出RDDs的创新之处。

Spark系统通过实现RDDs,已被广泛应用于各种用户应用程序和交互式数据挖掘,证实了其设计的有效性和实用性。

这篇论文的结论总结了RDDs的重要性和Spark系统在大数据计算领域的贡献,强调了其对现有框架的改进和对未来的启示。"

277 浏览量

点击了解资源详情

220 浏览量

270 浏览量

336 浏览量

277 浏览量

194 浏览量

220 浏览量

213 浏览量

jinc09

- 粉丝: 1

最新资源

- Verilog实现的Xilinx序列检测器设计教程

- 九度智能SEO优化软件新版发布,提升搜索引擎排名

- EssentialPIM Pro v11.0 便携修改版:全面个人信息管理与同步

- C#源代码的恶作剧外表答题器程序教程

- Weblogic集群配置与优化及常见问题解决方案

- Harvard Dataverse数据的Python Flask API教程

- DNS域名批量解析工具v1.31:功能提升与日志更新

- JavaScript前台表单验证技巧与实例解析

- FLAC二次开发实用论文资料汇总

- JavaScript项目开发实践:Front-Projeto-Final-PS-2019.2解析

- 76云保姆:迅雷云点播免费自动升级体验

- Android SQLite数据库增删改查操作详解

- HTML/CSS/JS基础模板:经典篮球学习项目

- 粒子群算法优化GARVER-6直流配网规划

- Windows版jemalloc内存分配器发布

- 实用强大QQ机器人,你值得拥有