深度语境化词表示模型——ELMo解析

需积分: 14 94 浏览量

更新于2024-07-17

收藏 293KB DOCX 举报

"这篇文档是关于深度语境化词表示模型——ELMo的翻译稿,主要探讨了如何通过预训练的深层双向语言模型(biLM)来学习捕捉词汇的复杂特征和多义词的语境使用。"

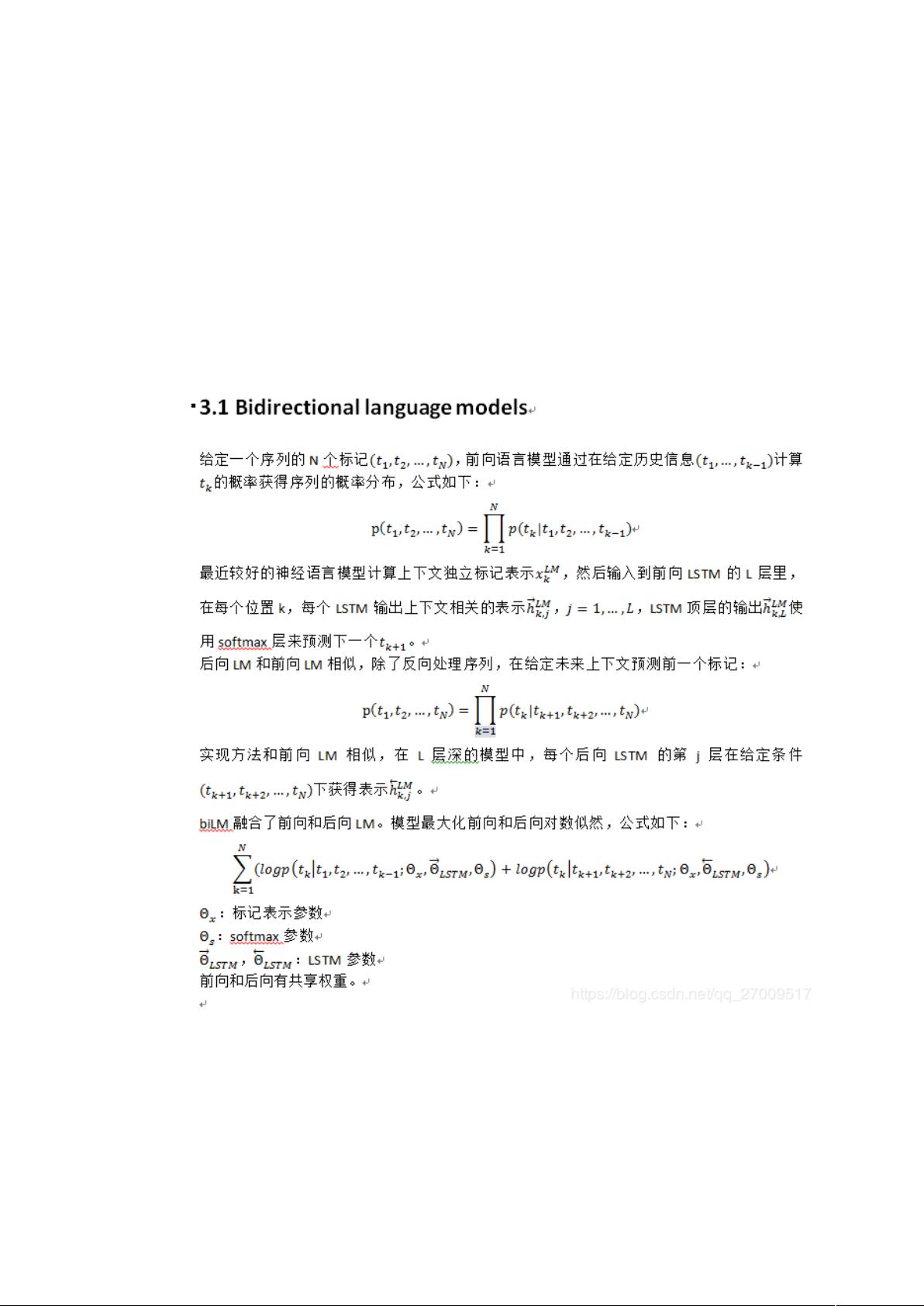

在自然语言处理(NLP)领域,预训练的词表示对于构建神经语言理解模型至关重要。然而,创建高质量的词表示是一个挑战,需要捕获词语的语义和语法特性以及在不同上下文中的多义性。本文介绍的ELMo(Embeddings from Language Models)模型正是为了解决这两个问题。与传统词嵌入方法不同,ELMo不是为每个词汇分配固定向量,而是根据输入句子动态生成向量表示。

ELMo利用双向长短期记忆网络(Bi-LSTM)在大规模文本数据集上训练得到的语言模型。这种模型能够捕捉到词语的前向和后向上下文信息,从而形成更丰富的语境表示。每个词的ELMo表示是由Bi-LSTM所有层的内部状态的线性组合,而不是仅依赖顶层。这样的设计使得ELMo可以灵活地适应不同的任务,通过学习任务相关的权重来优化不同层的贡献。

实证研究表明,ELMo的表示在多个复杂的NLP任务中表现出色,包括问答、语篇蕴涵和情感分析。将其集成到现有的模型中,能显著提升性能,比如相对错误率降低20%。与使用神经机器翻译编码器的CoVe模型相比,ELMo在某些可以直接比较的任务上表现更优,证明了其深层表示的优越性。

通过对不同层次的LSTM状态的研究,作者发现高层LSTM更善于捕捉依赖上下文的语义信息,而低层LSTM状态则倾向于捕获语法特征。结合所有这些信息,ELMo能学到更有利的半监督信号,进一步增强模型性能。

ELMo通过预训练的深层语境化词表示,为NLP模型提供了一种强大的工具,能够有效地处理词汇的复杂性和多义性,从而在各种自然语言处理任务中实现性能提升。这一技术的引入,不仅推动了词表示学习的发展,也为后续的模型改进和任务应用提供了新的思路。

2019-09-18 上传

2022-04-21 上传

2023-03-16 上传

2023-05-25 上传

2024-10-14 上传

2024-10-14 上传

2024-10-14 上传

2024-10-14 上传

Jeremy_kwok

- 粉丝: 0

- 资源: 1

最新资源

- 前端面试必问:真实项目经验大揭秘

- 永磁同步电机二阶自抗扰神经网络控制技术与实践

- 基于HAL库的LoRa通讯与SHT30温湿度测量项目

- avaWeb-mast推荐系统开发实战指南

- 慧鱼SolidWorks零件模型库:设计与创新的强大工具

- MATLAB实现稀疏傅里叶变换(SFFT)代码及测试

- ChatGPT联网模式亮相,体验智能压缩技术.zip

- 掌握进程保护的HOOK API技术

- 基于.Net的日用品网站开发:设计、实现与分析

- MyBatis-Spring 1.3.2版本下载指南

- 开源全能媒体播放器:小戴媒体播放器2 5.1-3

- 华为eNSP参考文档:DHCP与VRP操作指南

- SpringMyBatis实现疫苗接种预约系统

- VHDL实现倒车雷达系统源码免费提供

- 掌握软件测评师考试要点:历年真题解析

- 轻松下载微信视频号内容的新工具介绍