深入剖析Hadoop源代码

"Hadoop源代码分析"

Hadoop作为开源的分布式计算框架,是构建大规模数据处理系统的基石。其设计灵感来源于Google的几篇开创性论文,包括GoogleCluster、Chubby、GFS、BigTable和MapReduce。在Apache社区的努力下,Hadoop发展成为了一个完整的项目,其中HDFS对应GFS,ZooKeeper对应Chubby,HBase对应BigTable,Hadoop MapReduce则实现了MapReduce计算模型。

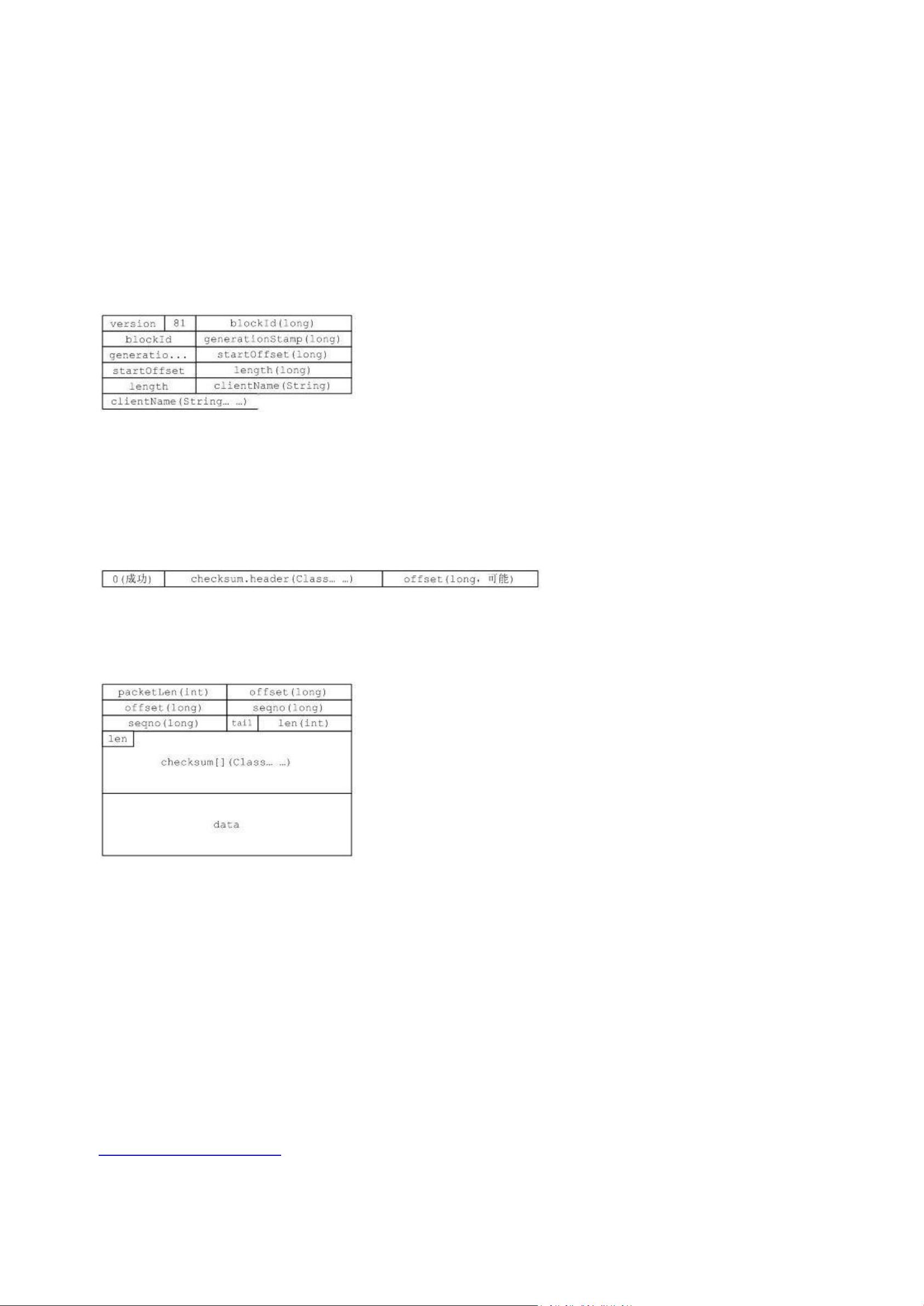

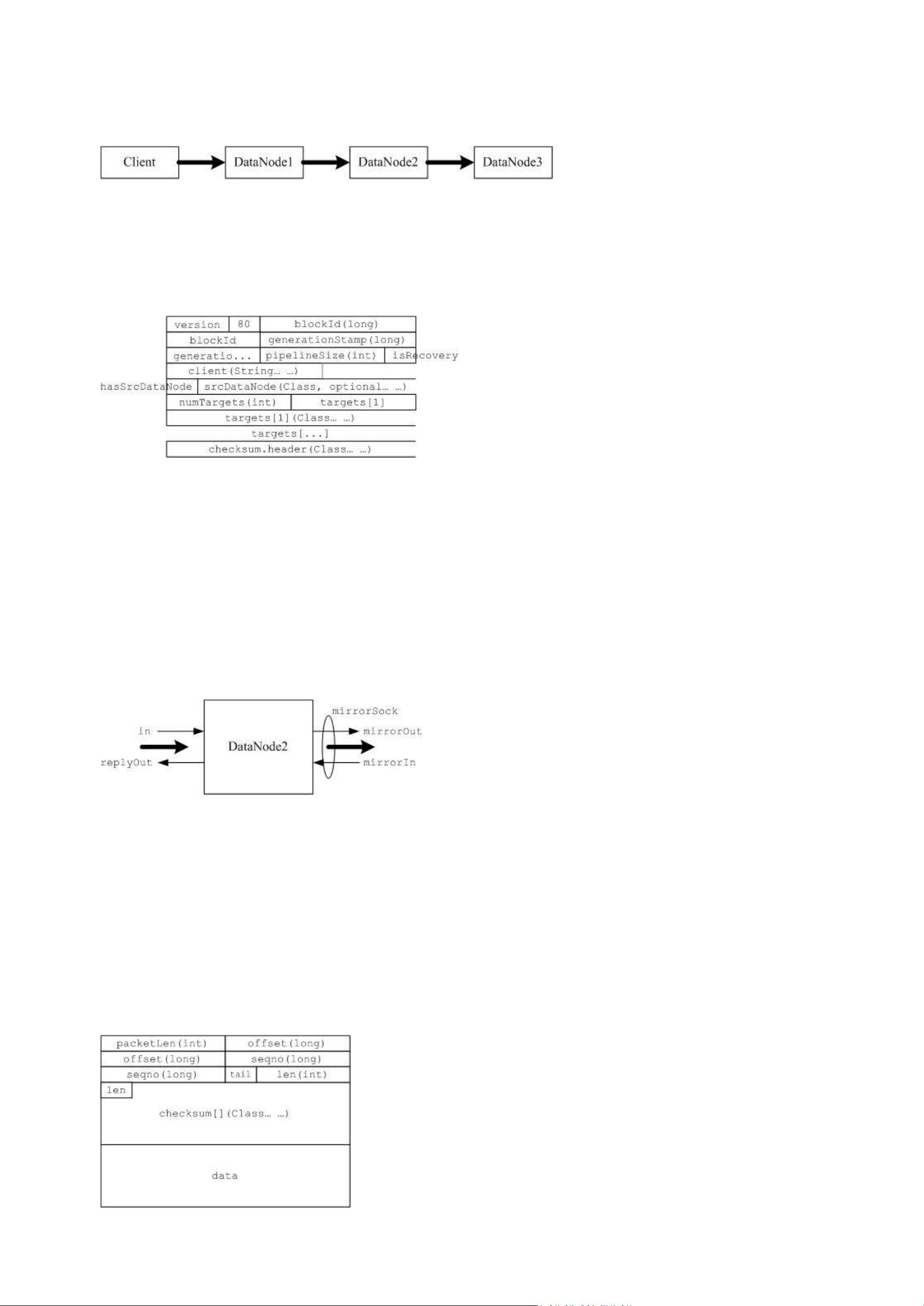

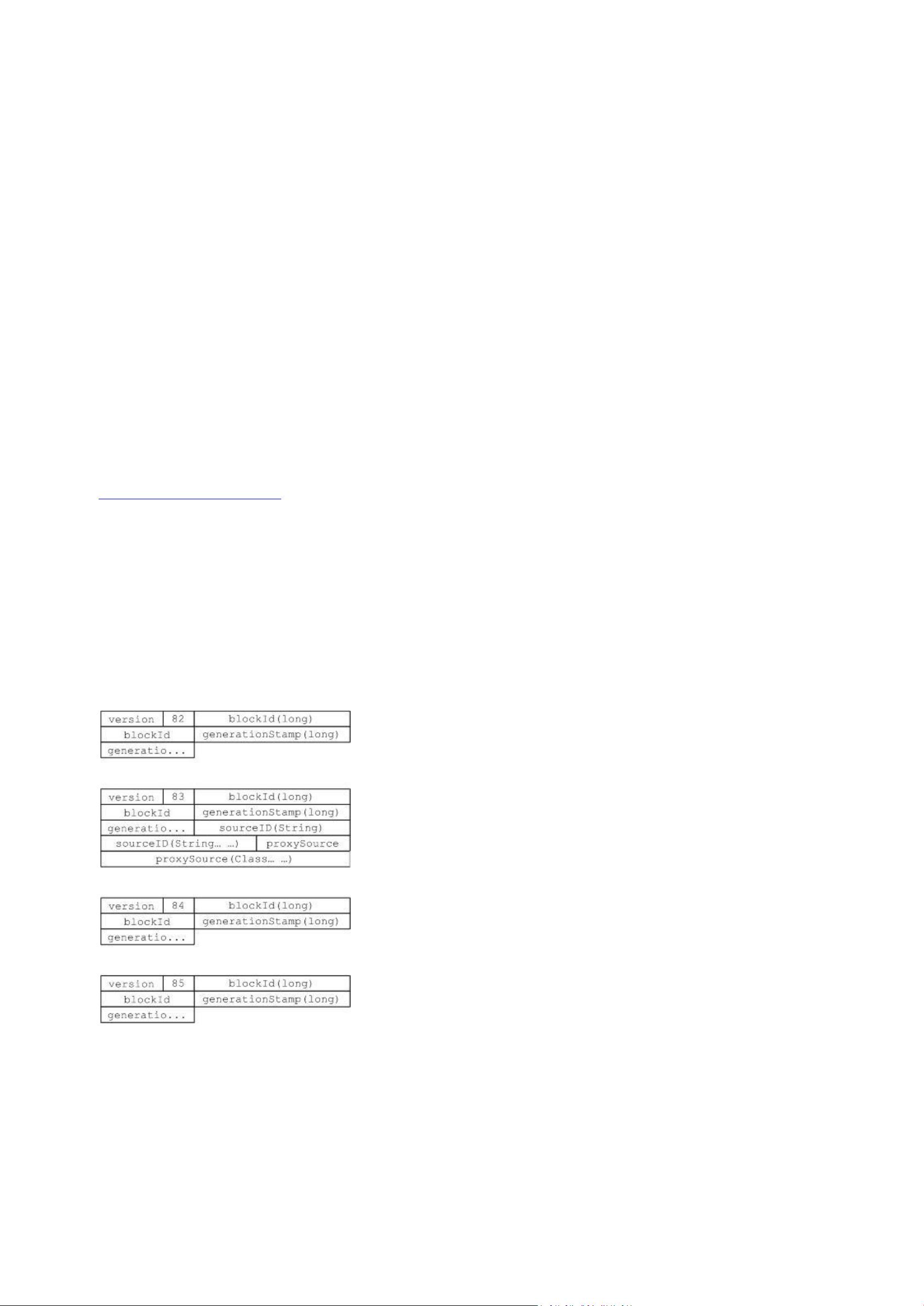

HDFS(Hadoop Distributed File System)是Hadoop的核心组件之一,作为一个分布式文件系统,它能够提供高容错性和高吞吐量的数据访问。分析HDFS的源代码有助于理解其内部工作原理,比如数据块的分布策略、副本机制以及故障恢复过程。HDFS的设计目标是支持大数据的存储,其API设计使得应用程序能够透明地访问分布式存储,无需关心底层的分布式细节。

MapReduce是Hadoop的另一个关键组件,用于处理和生成大规模数据集。它将复杂的计算任务分解为两个阶段:Map阶段和Reduce阶段。Map阶段将输入数据拆分成键值对并进行局部处理,然后Reduce阶段对Map阶段的结果进行聚合和总结。MapReduce框架负责调度任务、处理失败和数据通信,从而简化了大规模并行计算的编程模型。

在Hadoop的源代码结构中,包的依赖关系复杂,例如conf包既依赖于fs包来读取配置文件,同时fs包又抽象了部分文件系统功能。这种蜘蛛网型的依赖关系体现了Hadoop设计的灵活性,允许在不同层次的接口之间复用功能。

Hadoop的源代码分析通常会关注以下几个核心包:

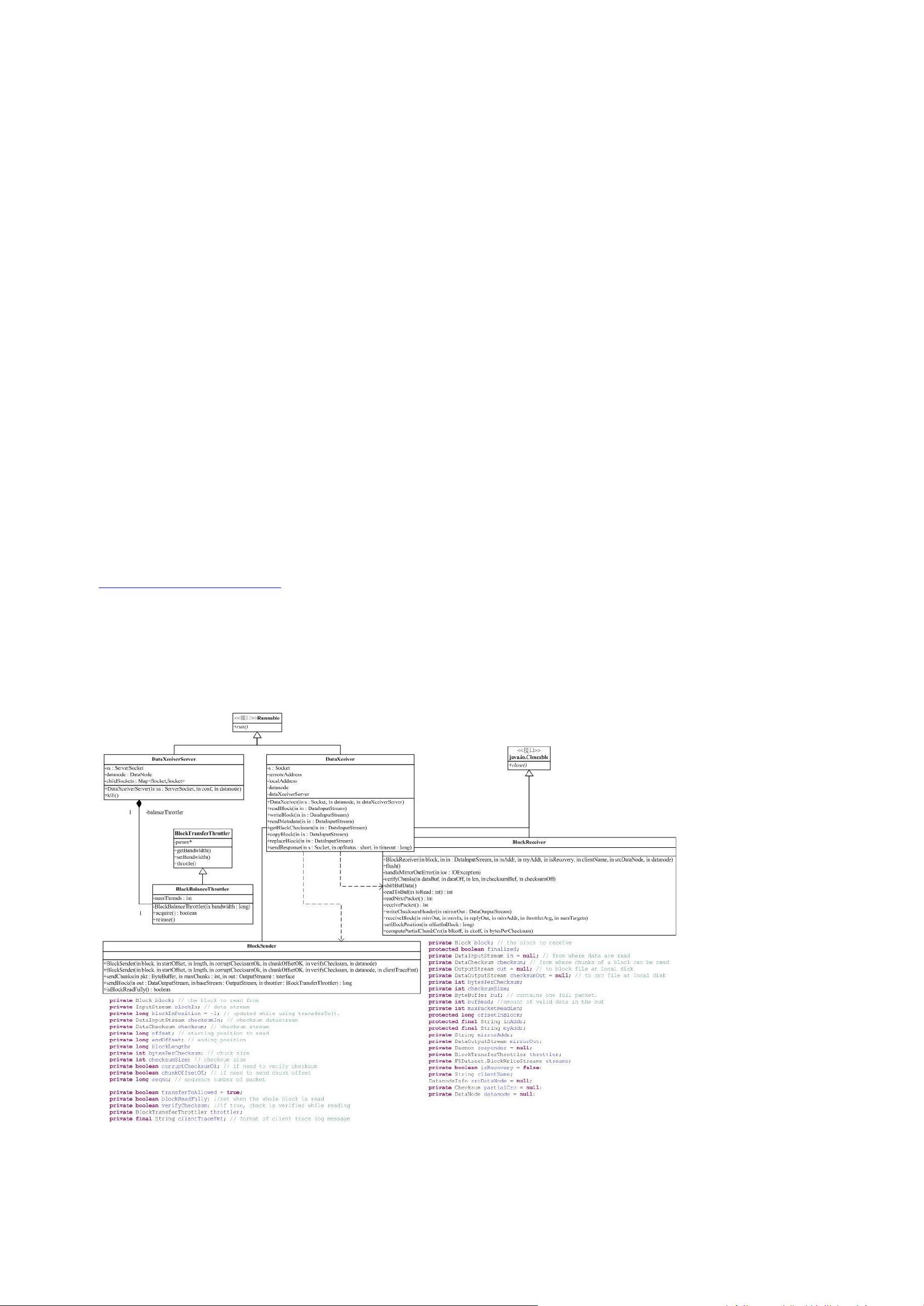

1. **hadoop-common**: 包含通用工具和服务,如配置管理、网络通信和文件系统API。

2. **hadoop-hdfs**: 实现HDFS,包括文件系统客户端、服务器端组件和数据存储管理。

3. **hadoop-mapreduce**: 提供MapReduce计算框架,包括JobTracker、TaskTracker以及任务执行的相关类。

4. **hadoop-yarn**: 针对MapReduce的资源管理和调度,替代了旧版的JobTracker。

5. **hadoop-tools**: 提供各种实用工具,如数据迁移和压缩工具。

深入研究这些包的功能和交互,可以揭示Hadoop如何处理分布式计算中的数据存储、任务调度、容错性和性能优化等关键问题。此外,Hadoop的源代码分析也有助于开发者理解如何扩展和优化Hadoop以适应特定的业务需求,或者为社区贡献新的功能和改进。

2022-03-12 上传

2014-12-01 上传

2018-01-23 上传

2011-05-21 上传

2024-11-10 上传

2024-11-10 上传

2024-11-10 上传

匠心零度

- 粉丝: 9508

- 资源: 301

最新资源

- NIST REFPROP问题反馈与解决方案存储库

- 掌握LeetCode习题的系统开源答案

- ctop:实现汉字按首字母拼音分类排序的PHP工具

- 微信小程序课程学习——投资融资类产品说明

- Matlab犯罪模拟器开发:探索《当蛮力失败》犯罪惩罚模型

- Java网上招聘系统实战项目源码及部署教程

- OneSky APIPHP5库:PHP5.1及以上版本的API集成

- 实时监控MySQL导入进度的bash脚本技巧

- 使用MATLAB开发交流电压脉冲生成控制系统

- ESP32安全OTA更新:原生API与WebSocket加密传输

- Sonic-Sharp: 基于《刺猬索尼克》的开源C#游戏引擎

- Java文章发布系统源码及部署教程

- CQUPT Python课程代码资源完整分享

- 易语言实现获取目录尺寸的Scripting.FileSystemObject对象方法

- Excel宾果卡生成器:自定义和打印多张卡片

- 使用HALCON实现图像二维码自动读取与解码