深度学习公平性:神经网络个体公平性验证与优化

37 浏览量

更新于2024-06-16

收藏 2.07MB PDF 举报

"神经网络个体公平性证明方法"

在当今数据驱动的世界中,神经网络(NN)已经成为许多关键领域的核心技术,如金融、医疗和司法。然而,随着它们的广泛应用,公平性问题日益突出,因为神经网络有可能在决策过程中放大社会偏见。这篇论文专注于神经网络的个体公平性(Individual Fairness, IF),这是公平性研究的一个重要分支,旨在确保模型对每个个体都公平,而不仅仅是对群体。

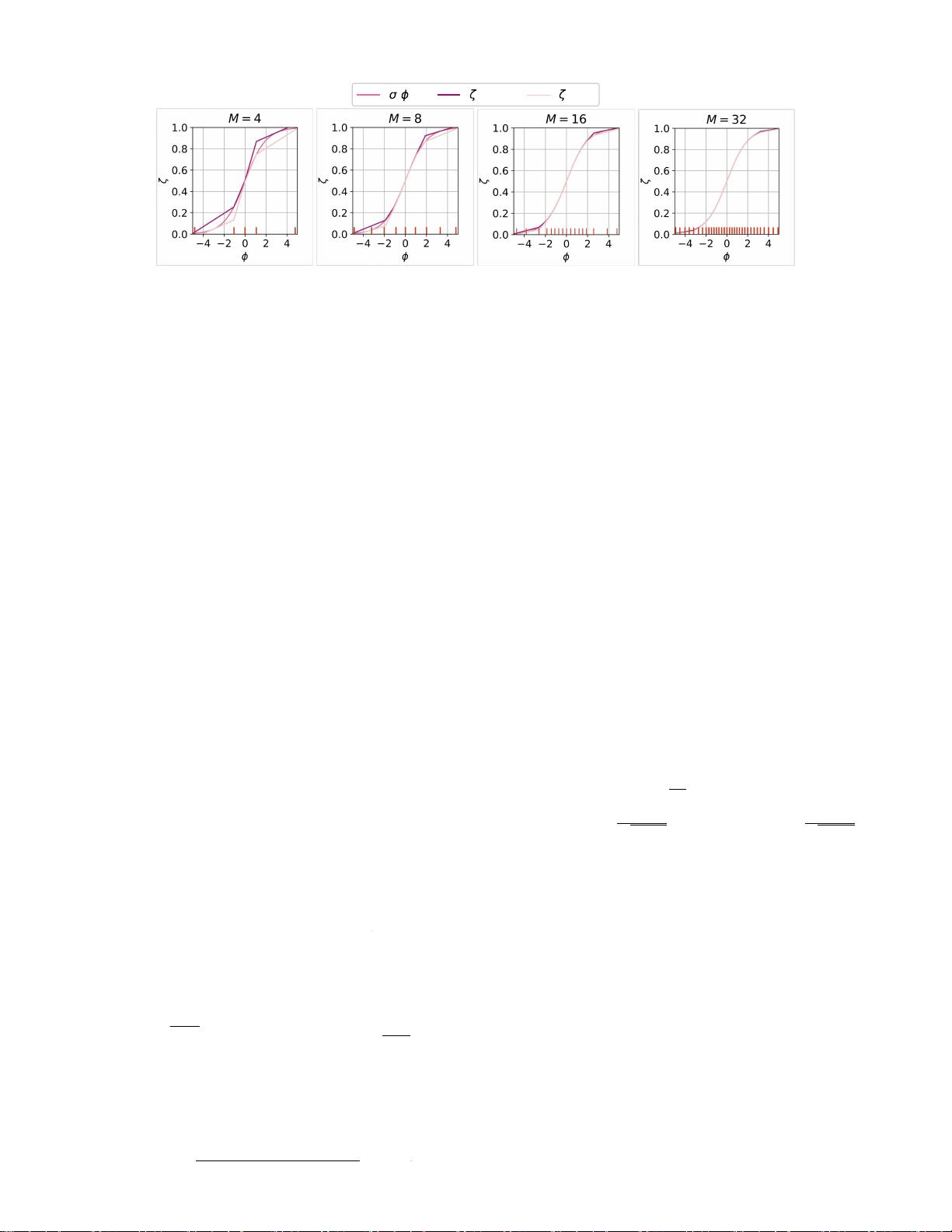

论文提出了一种名为NN-δ-IF的公式,该公式针对前馈神经网络,要求在给定的最大决策容差δ0内,对任何两个被认为是NN-相似的个体,其输出差异应受到限制。这里的相似性度量是通过学习从数据中得到的,比如用Mahalanobis距离来衡量个体间的差异。

为了实现NN-δ-IF的证明,论文提出了一种方法,通过分段线性函数来近似神经网络的非线性全局行为。这一过程被编码为一个混合线性规划问题,可以有效地求解。作者展示了这种方法在四个广泛使用的公平性基准数据集上的应用,用于计算个体公平性保证。

此外,论文还探讨了如何在训练阶段通过调整神经网络的损失函数来促进公平性。实验结果显示,这种方法产生的模型相比现有的最先进的技术,具有更高的个体公平性表现。

个体公平性的研究不仅仅是一个理论概念,它对消除模型中的潜在偏见和提高模型的社会接受度至关重要。尽管群体公平性考虑了模型的整体统计特性,但它不能保证个体层面的公平。相反,个体公平性提供了每个个体的具体保障,确保在所有可能的输入情况下,模型的决策不会因个体的敏感属性(如种族、性别等)而产生不公正的差异。

这篇论文为神经网络的个体公平性证明提供了一个新的框架,为构建更加公平的机器学习模型开辟了道路。通过理论分析与实证研究的结合,作者展示了一种有效的方法来量化和增强NN的个体公平性,这对于未来的研究和实践具有深远的影响。

2021-09-24 上传

141 浏览量

2021-08-14 上传

2023-05-03 上传

2023-05-05 上传

2023-04-30 上传

2024-04-21 上传

2023-04-01 上传

2023-04-05 上传

cpongm

- 粉丝: 5

- 资源: 2万+

最新资源

- 明日知道社区问答系统设计与实现-SSM框架java源码分享

- Unity3D粒子特效包:闪电效果体验报告

- Windows64位Python3.7安装Twisted库指南

- HTMLJS应用程序:多词典阿拉伯语词根检索

- 光纤通信课后习题答案解析及文件资源

- swdogen: 自动扫描源码生成 Swagger 文档的工具

- GD32F10系列芯片Keil IDE下载算法配置指南

- C++实现Emscripten版本的3D俄罗斯方块游戏

- 期末复习必备:全面数据结构课件资料

- WordPress媒体占位符插件:优化开发中的图像占位体验

- 完整扑克牌资源集-55张图片压缩包下载

- 开发轻量级时事通讯活动管理RESTful应用程序

- 长城特固618对讲机写频软件使用指南

- Memry粤语学习工具:开源应用助力记忆提升

- JMC 8.0.0版本发布,支持JDK 1.8及64位系统

- Python看图猜成语游戏源码发布