最大熵模型详解:自然语言处理中的关键方法与应用

版权申诉

114 浏览量

更新于2024-06-26

收藏 1.46MB PDF 举报

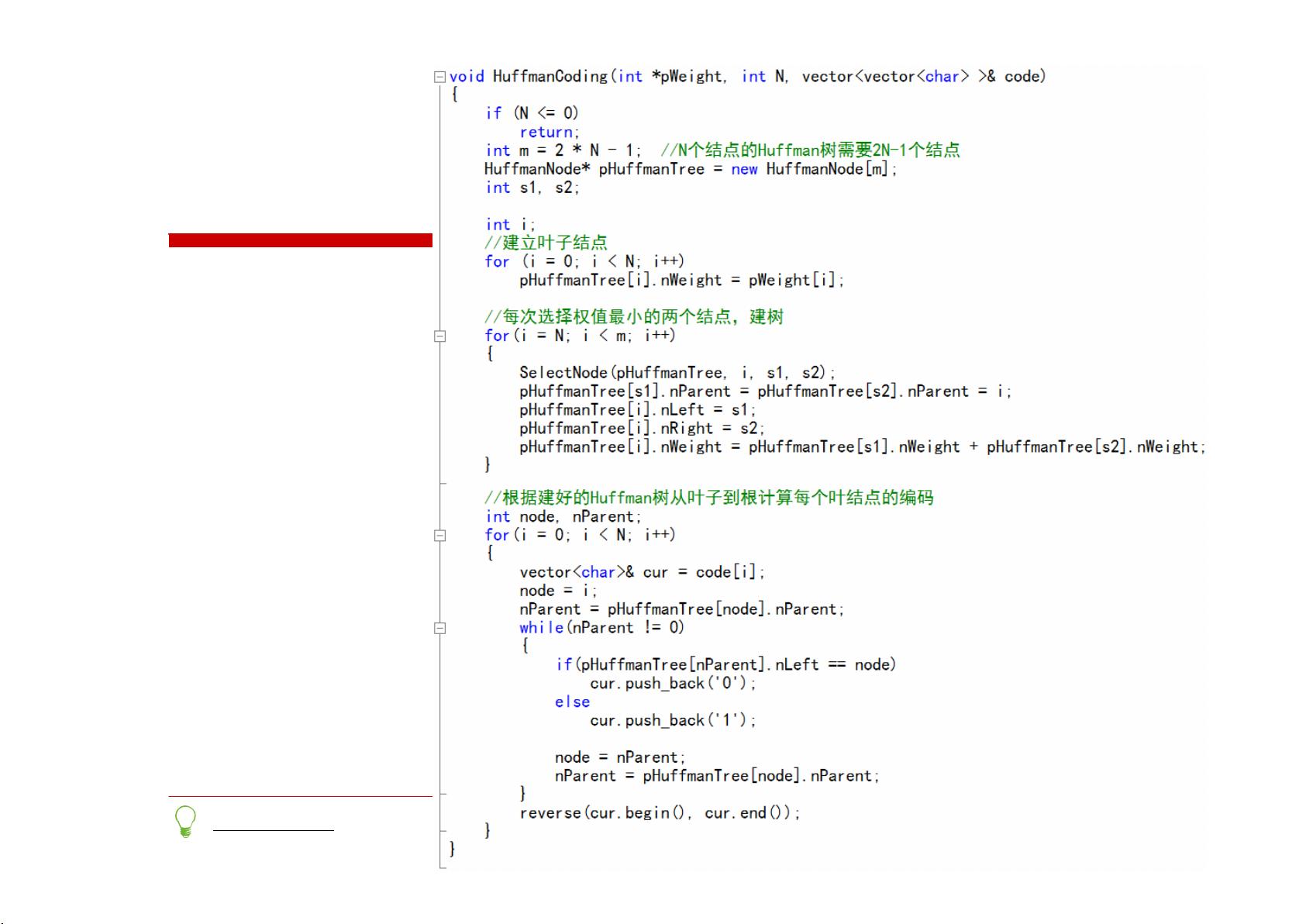

本次资源是关于ML_9月机器学习在线班的课程7.1——最大熵模型。该章节首先介绍了熵的概念,作为衡量不确定性或信息量的基本工具。熵在信息论中被用来描述一个随机变量的不确定性程度,Huffman编码就是基于熵原理,通过构建最优的编码树来达到所有可能编码的平均长度最短。

接着,课程讲解了联合熵H(X,Y)、相对熵D(X||Y)(也称Kullback-Leibler散度)、条件熵H(X|Y)以及互信息I(X,Y)。这些概念描述了多个随机变量之间的关系,如条件熵是给定某个变量Y后,X的不确定性减小了多少,而互信息则是量化两个变量之间共享的信息量。

最大熵模型(Maximum Entropy Models,Maxent)是机器学习中的一种方法,它假设在满足给定的观测数据约束条件下,模型应该具有最大的不确定性,即最不确定的模型。这样做的目的是避免过度拟合,保证模型的泛化能力。

在自然语言处理(Natural Language Processing, NLP)中,最大熵模型广泛应用,例如在词性标注、命名实体识别等任务中,可以捕捉到词汇和上下文之间的复杂关系,同时保持模型简洁和鲁棒。

最大熵模型与极大似然估计(Maximum Likelihood Estimation, MLE)有紧密联系,但最大熵模型在面对未知分布时更稳健,因为它不假设任何特定的概率分布形式。相比之下,MLE假设数据是来自已知分布的,但在实际应用中,数据分布往往难以确定。

课程还提及了预备定理,涉及到对数积分和期望值的计算,这些都是理解和解决带约束优化问题的基础,如在最大化熵的同时满足特定的概率分布约束。

最后,课程通过骰子的例子引入了带约束的优化问题,展示了如何用拉格朗日乘数法求解此类问题,特别是当目标是找到使总熵最小化且满足平均值约束的概率分布。

本节课程涵盖了熵的理论基础,最大熵模型的原理和应用,以及相关的数学工具,为理解和构建稳健的机器学习模型提供了坚实的理论支撑。通过学习,学员不仅能掌握这些概念,还能提升数据分析和解决问题的能力。

658 浏览量

2023-03-27 上传

2023-08-12 上传

113 浏览量

2021-08-15 上传

2024-07-14 上传

百态老人

- 粉丝: 1w+

- 资源: 2万+

最新资源

- Glenn Baddeley - GPS - NMEA sentence information

- Build your own web site the right way using HTML and CSS.pdf

- C++Builder6编程实例精解

- 单片机基础知识一定要学

- linux诞生和发展的5个支柱

- Snort 数据包捕获性能的分析与改进

- 高质量c++编程 林锐著

- Cognos性能调优

- ov7725 CMOS摄像头模组资料

- 跟我一起写Makefile

- 测试计划(GB8567——88)

- 图书馆管理系统 资源下载

- SAP应用及ABAP开发最佳实践—基于ABAP Workbench创建并发布Web Service.pdf

- MySQL5.0触发器

- SAP应用及ABAP开发最佳实践—Internal Table.pdf

- JAVA语言版数据结构与算法(中文)