深度学习正则化详解:L2与Dropout

需积分: 0 198 浏览量

更新于2024-08-05

收藏 247KB PDF 举报

"正则化是深度学习中用于防止过拟合的重要技术,包括L2正则化和dropout等方法。正则化通过在损失函数中添加惩罚项,限制模型参数的自由度,从而降低模型对训练数据的过度依赖。L2正则化通过增加权重的平方和到损失函数来实现,促使权重值趋向于较小的值,避免模型过于复杂。dropout则是在训练过程中随机关闭一部分神经元,使得模型不能过分依赖某一特定特征,增加了模型的泛化能力。"

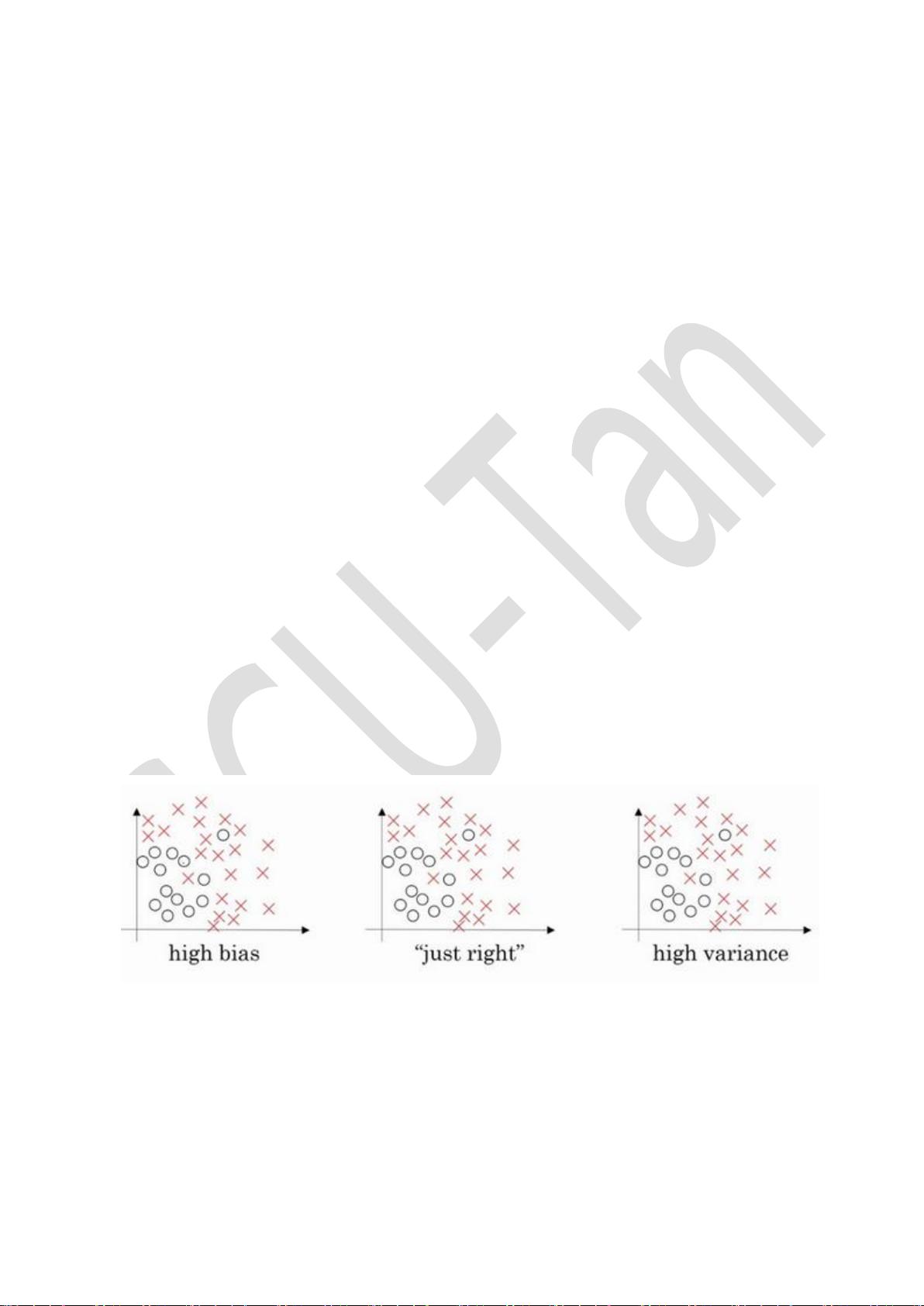

正则化是深度学习和神经网络中的一种关键技术,它的主要目标是减少模型的过拟合现象,即模型在训练数据上表现优秀,但在未见过的数据上表现较差的情况。过拟合通常是由于模型过于复杂,对训练数据中的噪声和特定细节过度学习导致的。正则化通过引入额外的约束来限制模型的复杂性,使模型更加关注于数据的主要趋势,从而提高泛化能力。

15.1 什么是正则化?

正则化是一种在训练模型时引入额外规则的技术,通过在损失函数中添加一个惩罚项来限制模型参数的大小。这有助于防止模型过度拟合训练数据,使其在新的、未知数据上的表现更好。

15.2 正则化原理?

正则化的原理在于,通过增加模型复杂性的成本,使优化过程在寻找最优解时倾向于选择较为简单的模型。这通常表现为限制权重参数的绝对值或平方和,例如L2正则化。

15.3 为什么要正则化?

正则化是防止过拟合的有效手段。在数据有限或存在噪声的情况下,正则化可以帮助模型找到一个较为平滑的决策边界,避免对训练数据的局部特征过度敏感。此外,正则化还能帮助减少模型的泛化误差,提高预测性能。

15.4 为什么正则化有利于预防过拟合?

正则化通过限制模型的复杂性,使得模型在试图拟合训练数据的同时,也要考虑到惩罚项的影响,从而避免了对训练数据中的异常点或噪声的过度响应。

15.5 为什么正则化可以减少方差?

正则化通过降低模型的复杂度,减少了模型对训练数据的过度拟合,从而降低了模型的方差,提高了模型对新数据的泛化能力。

15.6 L2正则化的理解?

L2正则化是在损失函数中添加权重矩阵的L2范数,即所有权重的平方和,乘以一个正则化系数。这导致权重参数倾向于取较小的值,避免权重过大导致过拟合。

15.7 理解dropout正则化

dropout是一种随机失活策略,它在训练过程中随机关闭一部分神经元,迫使模型不能过度依赖特定的神经元,增加模型的鲁棒性。这种正则化方式通过减少神经元之间的相互依赖,有效地实现了特征稀疏化,降低了模型复杂性。

15.8 有哪些dropout正则化方法?

dropout正则化有多种实现方式,包括标准的dropout、反向dropout(inverted dropout)等。反向dropout在实际应用中更为常见,它在训练时将每个神经元的输出乘以一个保持概率,而在验证和测试时不进行dropout操作。

15.9 Python实现dropout正则化

在Python中,通常使用深度学习框架如TensorFlow或PyTorch提供的API来实现dropout,这些API会在训练阶段自动处理dropout操作。

15.10 L2正则化和dropout有什么不同?

L2正则化通过增加权重的平方和来限制模型的复杂性,而dropout则是通过随机删除神经元来实现正则化。两者虽然目的相同,但实现方式不同,且在实际应用中可能会对不同类型的输入和网络结构展现出不同的效果。L2正则化对所有权重施加相同的约束,而dropout则更倾向于让每个神经元独立贡献。

总结来说,正则化是深度学习中必不可少的工具,通过L2正则化和dropout等方法,可以有效防止过拟合,提高模型的泛化性能。理解并掌握这些正则化技术对于构建高效、稳定的深度学习模型至关重要。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2022-08-03 上传

2022-08-03 上传

2022-08-03 上传

2022-08-03 上传

2022-08-04 上传

2022-08-03 上传

H等等H

- 粉丝: 43

- 资源: 337

最新资源

- MATLAB实现小波阈值去噪:Visushrink硬软算法对比

- 易语言实现画板图像缩放功能教程

- 大模型推荐系统: 优化算法与模型压缩技术

- Stancy: 静态文件驱动的简单RESTful API与前端框架集成

- 掌握Java全文搜索:深入Apache Lucene开源系统

- 19计应19田超的Python7-1试题整理

- 易语言实现多线程网络时间同步源码解析

- 人工智能大模型学习与实践指南

- 掌握Markdown:从基础到高级技巧解析

- JS-PizzaStore: JS应用程序模拟披萨递送服务

- CAMV开源XML编辑器:编辑、验证、设计及架构工具集

- 医学免疫学情景化自动生成考题系统

- 易语言实现多语言界面编程教程

- MATLAB实现16种回归算法在数据挖掘中的应用

- ***内容构建指南:深入HTML与LaTeX

- Python实现维基百科“历史上的今天”数据抓取教程