Informer: 长时间序列预测的突破性方法

需积分: 0 191 浏览量

更新于2024-08-03

收藏 1.62MB PDF 举报

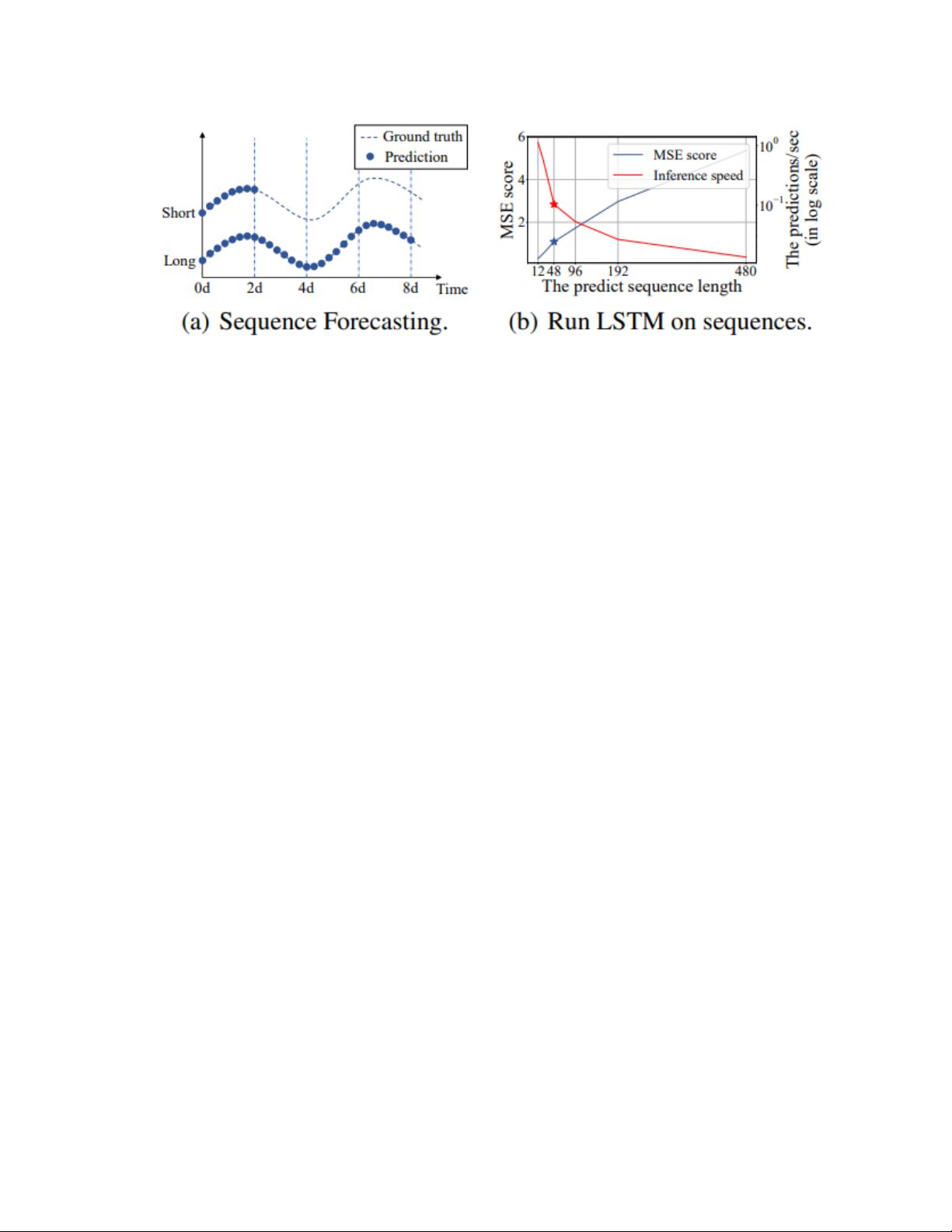

"《长时间序列杀手--Informer》是一篇发表于AAAI 2021年的研究论文,由Zhou H、Zhang S、Peng J等人共同完成,主要探讨了如何改进Transformer模型以解决长时序时间序列预测(Long Sequence Time-Series Forecasting, LSTF)中的挑战。长时序预测面临的主要问题包括:自注意力机制的高计算复杂度,导致时间复杂度与每层内存消耗增加;多层堆叠结构下的内存瓶颈,限制了模型处理长输入的能力;以及在预测长输出时的推理速度缓慢。

论文的核心贡献是提出了Informer模型,它在LSTF任务中显著提升了预测能力和效率。Informer通过创新的设计,解决了上述瓶颈问题:

1. **Informer设计**:Informer引入了一种新的架构,能够有效地捕捉长序列输入和输出之间的相互依赖关系,突破了传统Transformer在长序列处理上的局限。

2. **ProbSparse自相关机制**:论文提出了一种概率稀疏自相关(ProbSparse)机制,降低了自注意力操作的时间复杂度和内存需求,降低了模型的计算负担。

3. **内存效率提升**:通过减少堆叠层的数量或优化内存管理,Informer能够在处理长序列时减少内存占用,使得模型能够处理更长的输入。

4. **推理速度优化**:Informer采用改进的解码策略,提高了模型在预测长输出时的推理速度,提升了整体性能。

5. **实战验证**:论文通过实际的电力转换站小时级温度预测任务展示了Informer的优越性,特别是在预测长度超过48个点时,其MSE和推理速度的表现远优于LSTM。

Informer的成功证明了Transformer模型在长时序预测领域的潜力,并且其代码开源,为机器学习和深度学习社区提供了宝贵的学习资源。这篇论文因其在AAAI 2021年被评为最佳论文,体现了其在学术界的影响力和实用性。"

2024-01-29 上传

2023-06-11 上传

2023-04-29 上传

2019-10-22 上传

2021-04-05 上传

2022-05-05 上传

2021-05-14 上传

161 浏览量

2022-05-06 上传

毕业小助手

- 粉丝: 2762

- 资源: 5583