云原生大数据架构下的实时计算与维表结果表选型探讨

版权申诉

147 浏览量

更新于2024-07-18

收藏 1.31MB PDF 举报

"云原生大数据架构中实时计算维表和结果表的选型实践"

在当前的技术背景下,云原生大数据架构已经成为处理大规模数据和应对复杂需求的主要手段。传统的大数据架构,如基于Hadoop的HDFS、MapReduce和HBase,虽然在早期为数据存储和处理提供了强大的支持,但在面对互联网技术的快速发展、数据规模的急剧增长以及实时性需求的提升时,其局限性日益凸显。

规模化是大数据架构演进的一个关键方向。随着数据量的爆炸性增长,传统的存储和计算方式不再适用。为了满足不同场景的需求,数据被分层处理,例如通过冷热数据分离,使用不同的存储组件,如HDFS用于冷数据存储,而Hudi等新型解决方案则用于热数据的快速访问和更新。

实时化是大数据处理的另一大变革。传统的离线处理方式,如T+1报表,已无法满足实时推荐、监控等业务需求。因此,实时计算框架如Storm、Spark Streaming和Flink应运而生。Flink以其基于Dataflow模型的强实时处理能力,成为了实时计算领域的主流选择。

云原生化则是大数据架构的最新发展趋势。它强调的是存储计算分离和Serverless,旨在提高资源利用率,实现弹性伸缩,并简化运维。数据湖的概念成为云原生大数据架构的核心,提供统一的数据管理和计算能力。存储服务化使得数据存储可以按需扩展,计算服务化允许动态调度计算资源,元数据管理服务化确保数据的高效检索。

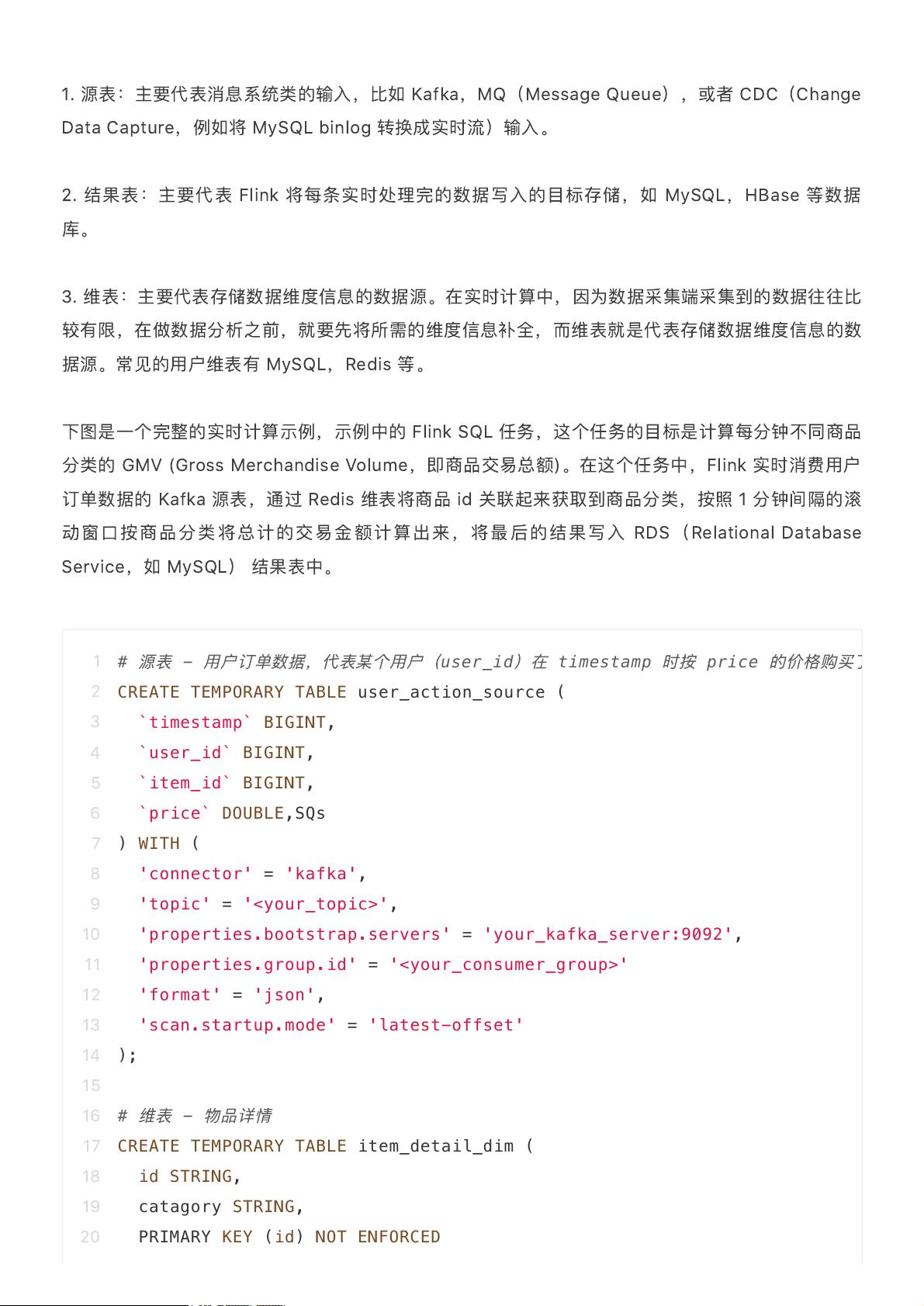

在云原生大数据架构中,实时计算涉及维表和结果表的选型。维表通常用于存储描述性的、不变或变化缓慢的数据,如地理位置信息、客户详情等,它们需要高效的查询性能。选择维表时,要考虑数据更新的频率、延迟要求以及查询模式。结果表则包含计算后的聚合数据,常常用于报表或决策支持。选型时需要平衡存储成本、计算效率和实时性。

在实践中,可能会考虑使用如Apache Druid这样的实时OLAP数据库作为维表,因其支持快速查询和实时更新。对于结果表,可以选择Flink与Hudi结合的方式,利用Flink进行实时计算,Hudi提供增量更新和版本控制。此外,还可以结合Kafka等消息队列实现数据流处理,确保数据的实时流入和处理。

云原生大数据架构下的实时计算维表和结果表选型,需要综合考量数据的特性和业务需求,选择最适合的存储、计算和管理方案,以确保系统的高效率、低延迟和弹性扩展能力。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2022-11-08 上传

2022-06-21 上传

169 浏览量

2021-08-08 上传

2021-09-16 上传

2021-10-13 上传

安全方案

- 粉丝: 2538

- 资源: 3960

最新资源

- Advanced Bash-Scripting Guide

- ArcGISObjectModel

- 基于自适应分割和自适应量化的图像压缩算法

- 中文php配置文件php.ini

- HTTP1.0和HTTP1.1的比较

- 用ODBC实现SQL+Server+2000在VB中的应用

- 利用DAO实现Visual+C对数据库的访问

- 基于VC的数据库访问技术的比较与选择

- VC中通过ADO访问远程SQL+SERVER+2000的高级编程

- MFC+ODBC数据存取技术

- 2进制转10进制源代码

- 自动售货机程序和仿真

- AS400 CL命令基础教程

- μC/OS, The Real-Time Kernel

- oracle数据库触发器实例

- 08下半年软件设计师上午试题