深度学习中的常见损失函数解析

需积分: 5 148 浏览量

更新于2024-08-05

收藏 699KB DOCX 举报

"这篇文档详细介绍了几种常见的损失函数在机器学习和深度学习中的应用,包括交叉熵损失、0-1损失、绝对值损失、平方损失、Hinge损失以及KL散度损失。这些损失函数在不同场景下有其特定的用途,并且在优化模型时起到关键作用。"

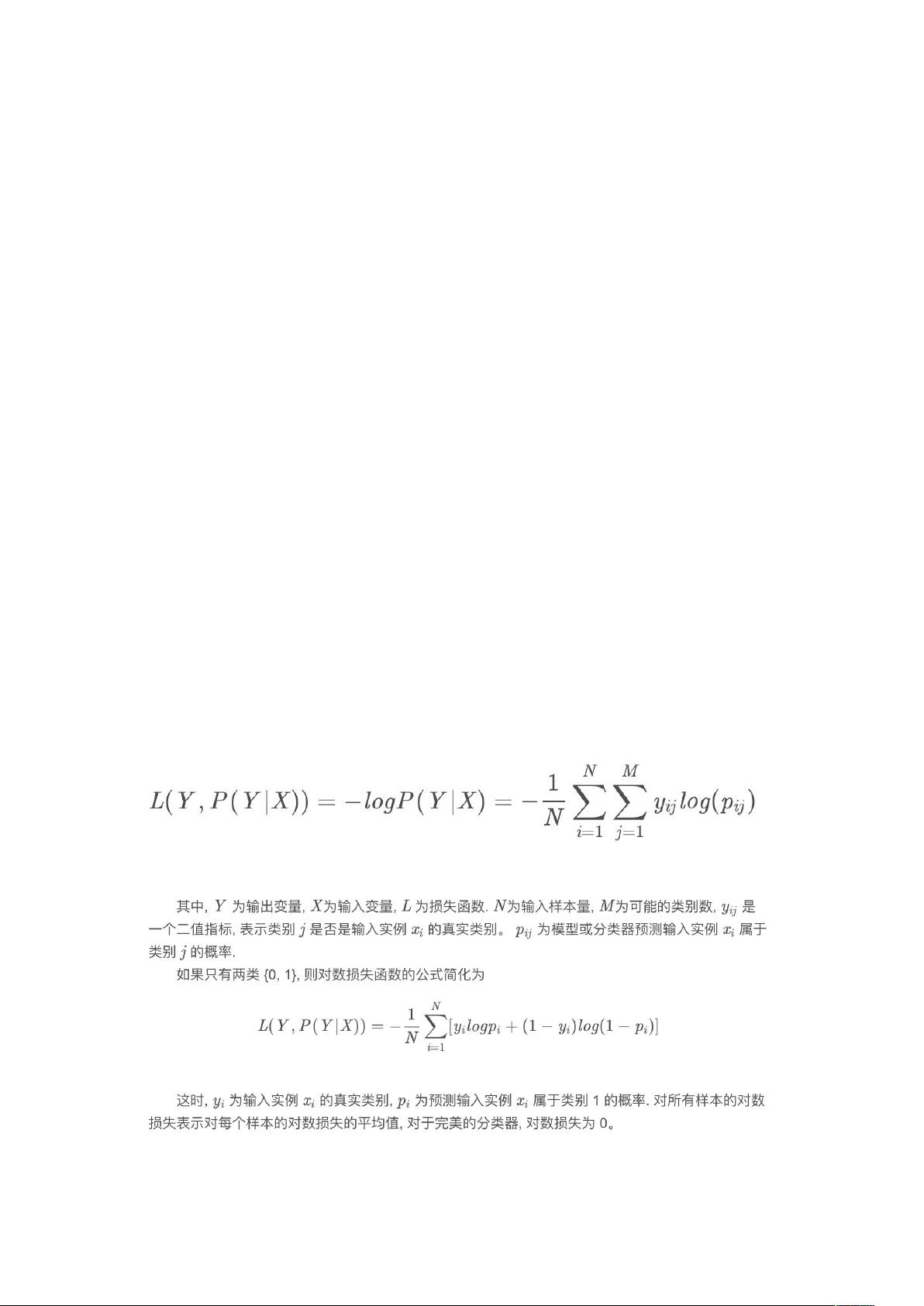

1. 交叉熵损失(Cross-Entropy Loss):

交叉熵损失主要用于多分类问题,它衡量的是预测概率分布与真实标签之间的差异。当分类器预测出每个类别的概率时,使用交叉熵损失可以有效地惩罚错误分类。其数学形式为对数似然损失,即Log-likelihood Loss。最小化交叉熵损失意味着最大化分类器的准确度。在神经网络和逻辑斯谛回归中广泛使用。

2. 0-1损失函数:

0-1损失是最简单的损失函数,只有当预测值与目标值不一致时,损失为1,否则为0。然而,由于其对误差的严格判断,实际优化过程中通常不会直接使用0-1损失,因为它不是连续可微的,不利于梯度下降等优化算法。

3. 绝对值损失函数(Absolute Value Loss):

绝对值损失函数用于衡量预测值与真实值之间的差距,无论正负,其值总是等于两个值的绝对差。这种损失函数对所有误差同等看待,适用于对误差敏感度相同的场景。

4. 平方损失函数(Square Loss):

最小二乘法中的平方损失函数是最常见的回归问题损失函数,它通过最小化所有样本点到回归直线的欧几里得距离平方和来寻找最佳拟合。这种方法将回归问题转化为凸优化问题,确保了全局最优解的存在。

5. Hinge损失函数:

Hinge损失常用于支持向量机(SVM)中,其目标是找到最大边距分类器。Hinge损失函数仅在预测值小于目标值的间隔时产生非零损失,这鼓励模型尽可能将数据点推离决策边界。

6. KL散度(Relative Entropy)损失:

KL散度,也称为相对熵,用于衡量两个概率分布的相似性。在多标签问题中,当标签之间存在相互依赖关系时,KL散度损失更适合,因为它考虑了每个位置的标签的影响。

7. NLL损失函数(Negative Log-Likelihood Loss):

NLL损失函数是负对数似然函数,通常用于多分类问题。在计算NLL损失时,需要先通过softmax函数将模型的隐藏层输出转换为概率分布,然后再取负对数。

总结来说,选择合适的损失函数取决于任务类型和需求。例如,交叉熵适用于多分类,平方损失适合回归,而Hinge损失适用于最大边距分类。理解并正确应用这些损失函数对于构建高效和准确的机器学习模型至关重要。在训练模型时,应根据具体问题选择合适的损失函数,并注意损失函数的一些特殊设置,如忽略某些标签。

179 浏览量

点击了解资源详情

点击了解资源详情

282 浏览量

2023-03-04 上传

2022-12-15 上传

355 浏览量

493 浏览量

*Lisen

- 粉丝: 132

- 资源: 45