Spark实时指标引擎:高效统一分析与容错设计

需积分: 50 89 浏览量

更新于2024-07-16

收藏 3.84MB PPTX 举报

实时指标计算引擎-Spark是Spark项目中的一个重要组成部分,它专注于实现实时数据分析和处理。Spark Streaming是Spark生态系统中的一个模块,专为大规模、实时的数据流处理设计,旨在支持高效的、可扩展的、容错的实时计算。由杨鑫在2019年12月19日的分享中详细探讨了这一主题。

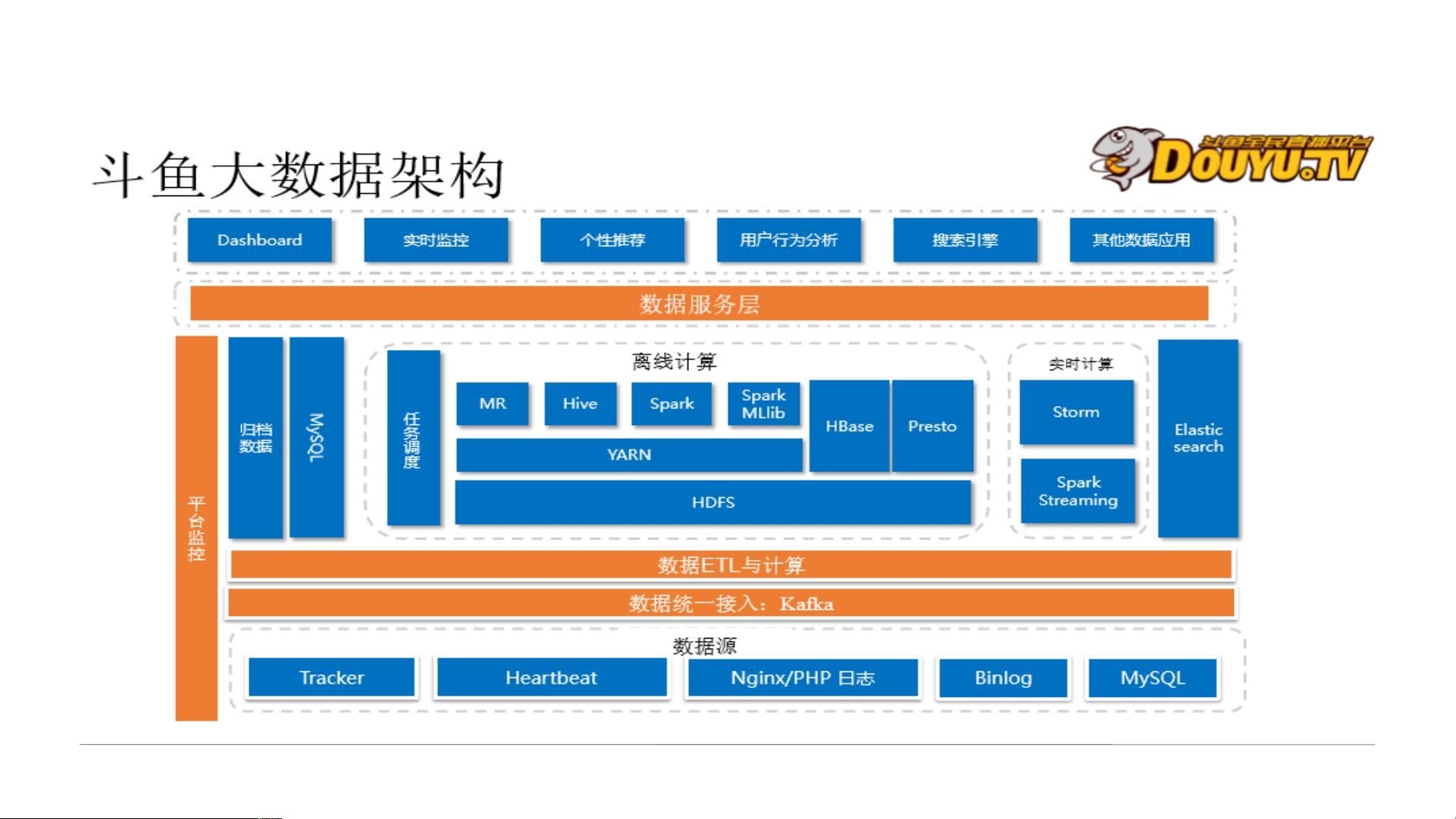

首先,实时指标计算的核心概念是围绕销量、用户行为、舆情监控等应用场景展开的,这些场景需要对实时数据流进行处理,以获取即时的洞察。例如,某东的销量实时指标、某观的用户实时指标、某鱼的实时数据流分析以及某高校的舆情监控都是Spark Streaming能够支持的应用实例。

在技术框架方面,演讲提到了Apache Hadoop的Streaming接口,这是一个早期的实时计算框架,与Spark Streaming形成了对比。此外,还提到了其他流行的实时计算框架,如Flink(Blink版本)、Apache Flink、Kafka(用于消息队列)、Apache Storm以及JStorm,它们各有特点,Spark Streaming凭借其易用性和高效性脱颖而出。

Spark Streaming之所以受到青睐,主要原因包括:

1. **速度与统一性**:Spark Streaming提供了闪电般的计算速度,作为统一的分析引擎,简化了实时应用程序的构建过程。

2. **容错性**:为了确保24/7的连续运行,Spark Streaming引入了CheckPoint机制,通过定期存储关键状态来实现故障恢复,增强了系统的可靠性。

3. **窗口处理**:Spark Streaming支持窗口操作,如定义窗口长度(例如3秒)和滑动区间(如2秒),这对于聚合和分析滚动数据窗口非常关键。例如,在实时文本处理中,可以每10秒基于过去的30秒数据统计单词频率。

在具体示例中,通过`reduceByKeyAndWindow`操作,可以在数据流的末尾30秒内实时计算单词计数,展示了如何利用窗口功能进行实时分析。这种灵活性使得Spark Streaming成为处理实时流数据的强大工具。

实时指标计算引擎-Spark Streaming以其高效、容错和灵活的特性,成为了大数据时代处理实时数据的重要解决方案,被广泛应用于电商、社交媒体监测、企业监控等各种业务场景中。

2017-09-17 上传

2019-10-17 上传

2019-10-17 上传

2018-09-30 上传

2019-10-17 上传

2024-04-06 上传

杨鑫newlfe

- 粉丝: 6241

- 资源: 189

最新资源

- tomcat解压版,包含6,7,8 三个版本.zip

- systemverilog-python:Systemverilog DPI-C调用Python函数

- 公牛队

- 网上配眼镜商城网站模板

- 微信小程序设计(含源代码+解释文档)之小工具类.zip

- portscan,c语言源码阅读技巧,c语言

- video-vue:学习b站上,全站之颠大神的教程,照着敲的。框架版本变化,遇到很多坑,存储一下

- sandiego:一个对抗 django 的网络框架

- canvas绘制可爱的鬼魂幽灵动画特效.zip

- tw-scanner:扫描高知名度帐户的Twitter活动以查找与加密安全性有关的推文

- 使用Mono构建应用程序

- 三次贝塞尔贴片和曲面的构造:三次贝塞尔贴片和曲面的构造-matlab开发

- week-2-assignment

- RBETestProject:这是一个测试项目,用于在GitHub上试用VS Code并弄清楚它的工作方式

- matlab利用PCA函数进行降维.rar

- GCC218-Algoritmos-em-Grafos