Hadoop源码解析:分布式存储与计算框架关键组件

Hadoop源码分析深入探讨了Apache基金会开发的分布式计算框架的核心组件——Hadoop。作为Google核心竞争技术之一的分布式云计算的开源版本,Hadoop提供了一种在廉价硬件上构建高性能、高容错性和高吞吐量数据处理环境的方式。它主要包括两个关键组件:Hadoop Distributed File System (HDFS) 和 MapReduce。

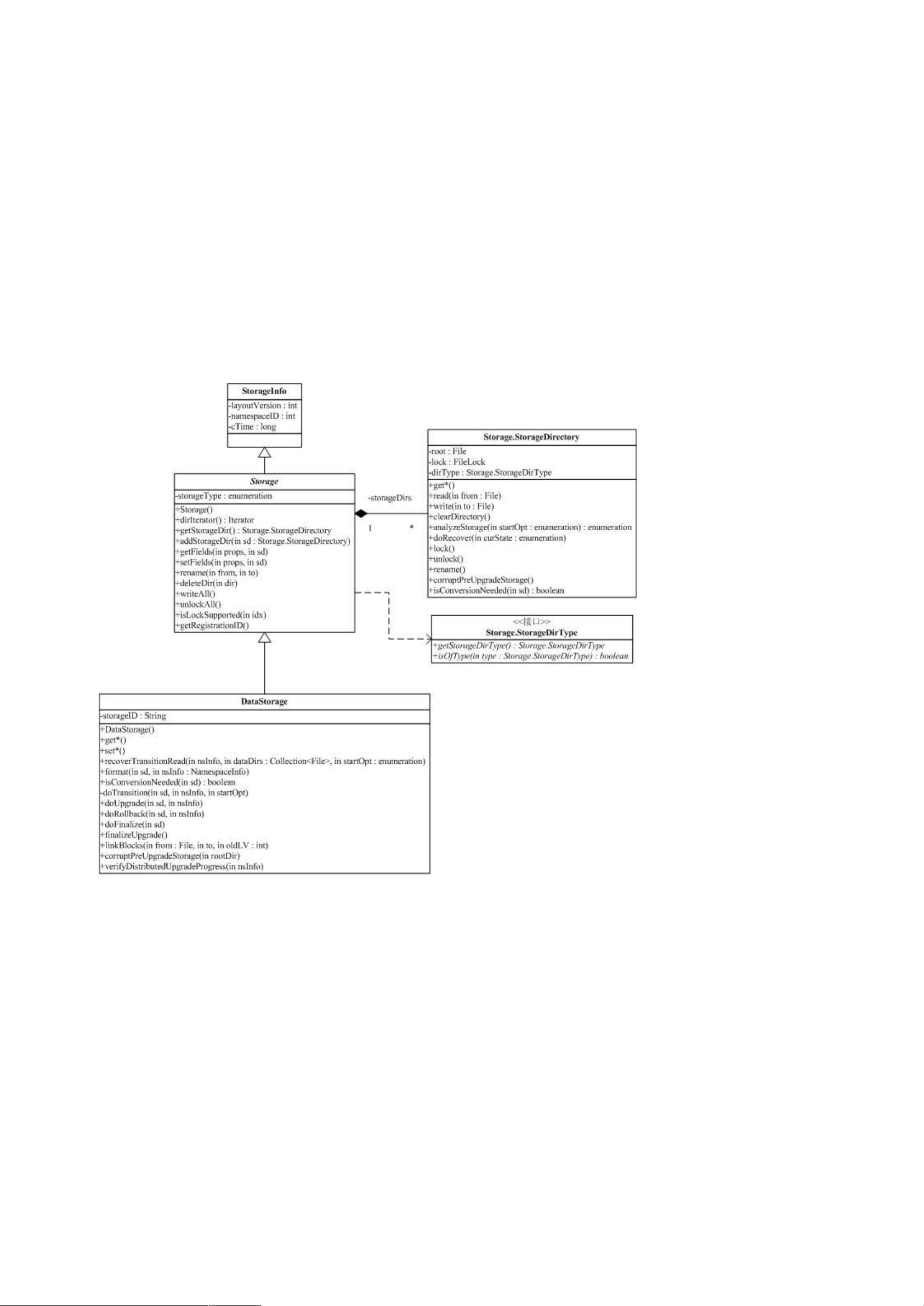

HDFS是一个分布式文件系统,其设计目标是支持大规模数据集的存储和访问。它具有高容错性,能够在节点故障时自动恢复数据,确保数据的一致性和可靠性。HDFS通过抽象层隐藏底层细节,使得用户无需关注文件系统的底层实现,无论是本地文件系统还是云存储服务如Amazon S3,都能无缝集成。这种设计导致了Hadoop包间的依赖关系复杂,尤其是conf包与fs包之间的交互,体现了HDFS的分布式特性。

另一个重要组成部分是MapReduce,这是一个并行编程模型,用于处理大规模数据集。它将复杂的计算任务分解为一系列简单的map和reduce操作,允许在集群中分布式执行。Hadoop的MapReduce框架在HDFS之上运行,这两个组件紧密相连,共同构成了Hadoop的核心生态系统。

Hadoop源代码分析系列文章深入剖析了Hadoop的顶层包结构及其依赖关系,着重关注图中的蓝色部分,即HDFS和MapReduce的核心模块。这些分析有助于理解分布式系统的设计原则,以及如何利用Hadoop进行数据处理和存储。通信机制在Hadoop中也扮演着重要角色,因为MapReduce和HDFS都需要高效的通信来协调任务分发和结果交换。

通过对Hadoop源码的深入研究,开发者能够学习到分布式系统的设计理念,提高自己的编程技能,并为处理大规模数据集提供强大的工具。同时,这也有助于开发者理解和优化其他基于类似思想的开源项目,如Facebook的Hive。Hadoop源码分析不仅是技术开发者必备的技能,也是理解现代大数据处理基础设施的重要途径。

2011-05-21 上传

2010-05-20 上传

2012-06-19 上传

2011-09-01 上传

2021-03-04 上传

2012-04-10 上传

adam_tang

- 粉丝: 1

- 资源: 8

最新资源

- La_Carte

- abouhanna:凯文的个人网站

- graphml:GraphML是图形的基于XML的文件格式

- pandas_gbq_magic-1.1.1.tar.gz

- h264_streaming.2.2.7.rar

- TM Light-开源

- Loup-crx插件

- shinyfullscreen:使用“ Screenfull.js”在“发光”应用程序中全屏显示HTML元素

- pandas_gbq_magic-1.1.0.tar.gz

- Detection_FootballvsCricketBall 检测_足球vs板球-数据集

- frdomain-extras:功能性和React性域建模的附加伴奏

- chrome-alex-crx插件

- Tiny Box-开源

- Aircnc:Rockeseat的教程在Omnistack9周内开发了应用程序

- Universe:一个软件平台,用于在世界范围内的游戏,网站和其他应用程序中测量和培训AI的一般情报。-Python开发

- Blog-Theme-Hexo-ICARUS-CUSTOMED:ppofficehexo-theme-icarus를수정하여사용중인