Flink工作原理:JobClient、JobManager与TaskManager

103 浏览量

更新于2024-08-27

收藏 358KB PDF 举报

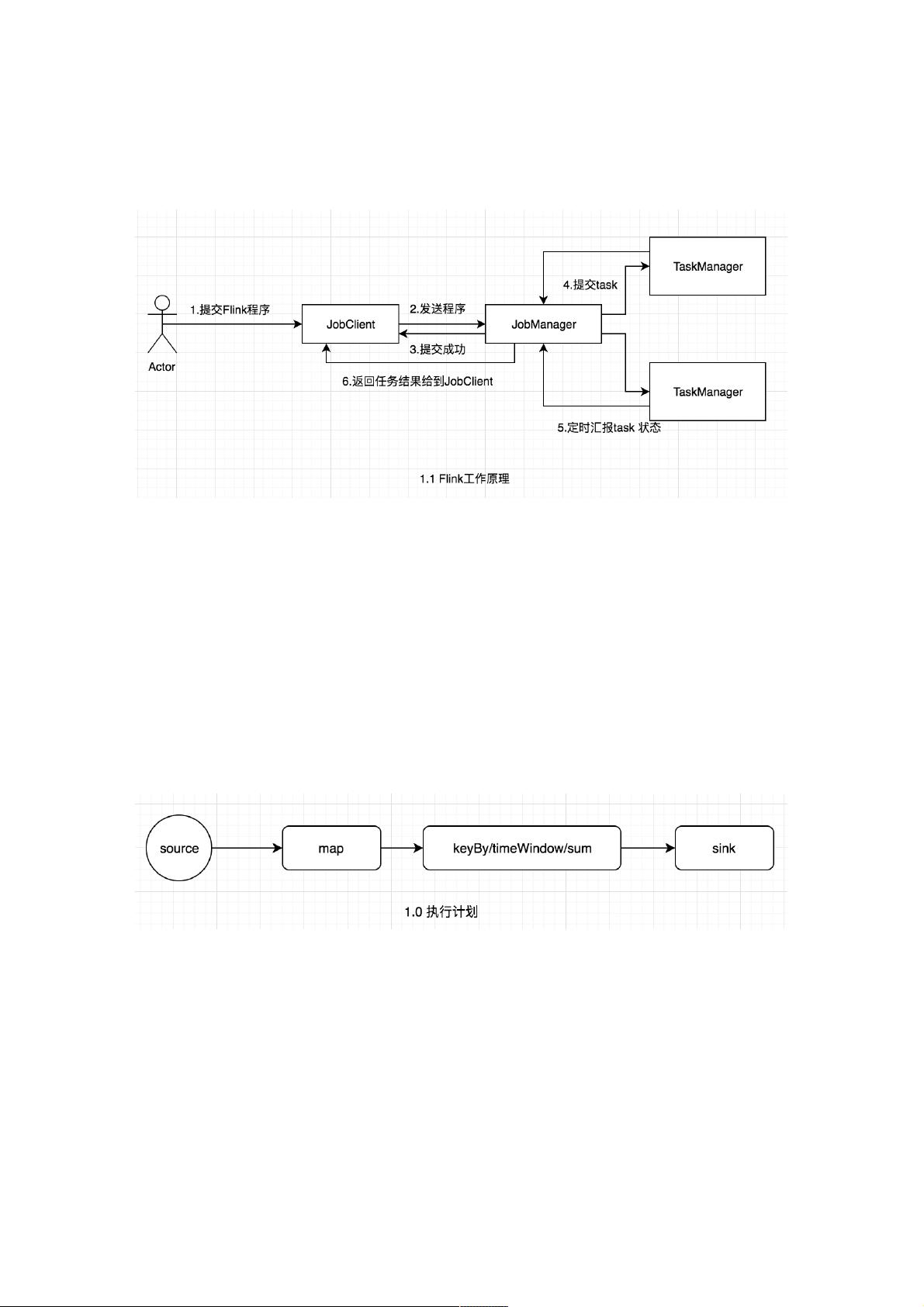

"Flink是基于Java实现的流计算引擎,能够处理流数据和批数据,功能涵盖Spark和Spark Streaming。其核心理念是将批处理视为特殊形式的流处理。在运行时,Flink系统主要涉及三个关键组件:JobClient、JobManager和TaskManager。流程是用户通过JobClient提交程序,经过解析、优化后交给JobManager,再由TaskManager执行任务。"

Flink的基本工作原理主要围绕着这三个组件展开:

1. **JobClient**:JobClient是用户与Flink系统的接口,它接收并解析用户提交的Flink程序。JobClient对程序进行执行计划的构建,将程序中的各种操作(如SourceOperator、TransformationOperator和SinkOperator)转化为Operator Graph。这个图表示了数据流的处理路径。接着,JobClient会进一步优化执行计划,通过融合相邻的Operator来减少不必要的数据传输,形成OperatorChain。

2. **JobManager**:JobManager是Flink的协调器,它接收来自JobClient的优化后的执行计划,并负责任务调度和状态管理。JobManager将Operator Graph分割成一系列的任务(Task),并将这些任务分配给可用的TaskManager来执行。此外,它还处理故障恢复和资源管理。

3. **TaskManager**:TaskManager是Flink的执行节点,它们实际执行Task并处理数据流。每个Task被分解为多个SubTask,SubTask之间通过网络进行数据交换。Flink支持两种数据传输模式:one-to-one模式和重新分布模式。在one-to-one模式下,数据无需重新分布,可以直接在TaskManager之间本地传递,减少了网络延迟。

Flink的流处理模型强调事件时间(event time)而非处理时间(processing time),这使得Flink能够处理乱序到达的数据,提供准确的一次性语义(exactly-once semantics)。此外,Flink的检查点(checkpoint)机制确保了在系统故障时能够恢复到一致的状态。

Flink的并行性和容错能力是通过将数据流划分为多个并行的数据通道(channels)来实现的。每个Operator的SubTask都会处理一部分数据,而TaskManager之间的通信通过网络shuffle进行,确保数据能够在不同节点间高效地传输。

Flink的设计使其在实时数据处理领域具有高性能和高可用性,能够应对大规模数据流的挑战。它的流批一体化处理能力和强大的容错机制使其在大数据处理场景中表现出色。

点击了解资源详情

点击了解资源详情

点击了解资源详情

103 浏览量

2023-04-28 上传

2019-07-17 上传

2019-02-26 上传

2023-03-21 上传

点击了解资源详情

weixin_38590567

- 粉丝: 2

- 资源: 932

最新资源

- 正整数数组验证库:确保值符合正整数规则

- 系统移植工具集:镜像、工具链及其他必备软件包

- 掌握JavaScript加密技术:客户端加密核心要点

- AWS环境下Java应用的构建与优化指南

- Grav插件动态调整上传图像大小提高性能

- InversifyJS示例应用:演示OOP与依赖注入

- Laravel与Workerman构建PHP WebSocket即时通讯解决方案

- 前端开发利器:SPRjs快速粘合JavaScript文件脚本

- Windows平台RNNoise演示及编译方法说明

- GitHub Action实现站点自动化部署到网格环境

- Delphi实现磁盘容量检测与柱状图展示

- 亲测可用的简易微信抽奖小程序源码分享

- 如何利用JD抢单助手提升秒杀成功率

- 快速部署WordPress:使用Docker和generator-docker-wordpress

- 探索多功能计算器:日志记录与数据转换能力

- WearableSensing: 使用Java连接Zephyr Bioharness数据到服务器