AI决策解释:探索十大Python库

需积分: 0 154 浏览量

更新于2024-08-03

收藏 2.22MB PDF 举报

"这篇文档聚焦于AI决策的解释性,特别是通过Python库实现。文档提到了XAI(可解释人工智能)的重要性和应用领域,强调了在AI系统中增强透明度和责任的重要性。文档还概述了实现XAI的步骤,包括数据准备、模型训练、模型评估、解释生成和解释验证,并介绍了两个流行的Python库——SHAP和LIME,用于生成模型的解释。"

在AI决策的过程中,可解释性是关键。XAI旨在使复杂的AI模型的决策过程变得更加透明,这不仅增强了用户对模型的信任,也提供了必要的问责机制。在医疗、金融和司法等高风险领域,AI的决策过程必须能够经得起审查,以避免潜在的误判和负面影响。

数据准备是建立可解释AI的第一步,需要高质量、平衡且具有代表性的数据。模型训练阶段,可以选择传统机器学习模型(如决策树、线性回归)或深度学习模型。模型的复杂性和可解释性之间存在权衡,简单模型易于解释但可能性能不足,而复杂模型可能提供更好的性能但解释难度增加。

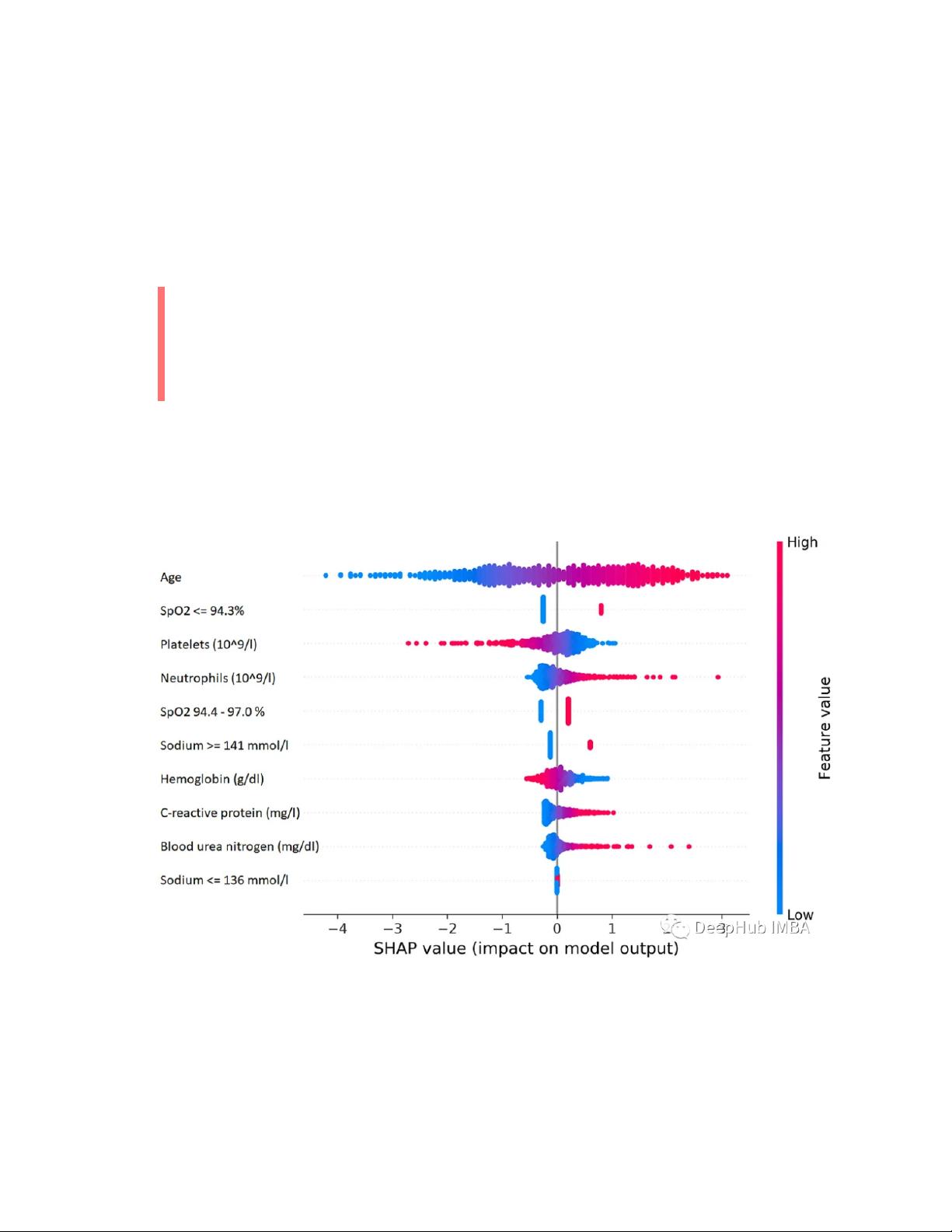

模型评估阶段,不仅要关注模型的预测准确性,还要评估其解释能力。解释生成阶段,可以利用像SHAP这样的库,它基于博弈论的Shapley值提供局部解释,或者LIME,这是一种模型无关的解释方法,通过近似模型在局部区域的行为来解释预测。

解释验证确保了模型提供的解释可靠且完整。最后,部署和监控环节不可忽视,持续监控模型在实际环境中的表现和可解释性,以便及时调整优化。

SHAP库利用Shapley值理论,为每个特征的贡献提供公平的分配,帮助理解模型预测背后的驱动力。而LIME则适用于黑盒模型,它通过创建局部线性模型来近似原模型,从而给出单个预测的解释。

这份资料详细阐述了AI决策的可解释性及其实践,特别强调了Python在实现这一目标中的作用,为AI开发者和研究人员提供了有价值的工具和方法。

2024-07-18 上传

2024-07-18 上传

2023-06-13 上传

2023-04-30 上传

2024-01-22 上传

2023-04-04 上传

2023-07-25 上传

2023-06-02 上传

2023-07-15 上传

白话机器学习

- 粉丝: 1w+

- 资源: 7686

最新资源

- 批量文件重命名神器:HaoZipRename使用技巧

- 简洁注册登录界面设计与代码实现

- 掌握Python字符串处理与正则表达式技巧

- YOLOv5模块改进 - C3与RFAConv融合增强空间特征

- 基于EasyX的C语言打字小游戏开发教程

- 前端项目作业资源包:完整可复现的开发经验分享

- 三菱PLC与组态王实现加热炉温度智能控制

- 使用Go语言通过Consul实现Prometheus监控服务自动注册

- 深入解析Python进程与线程的并发机制

- 小波神经网络均衡算法:MATLAB仿真及信道模型对比

- PHP 8.3 中文版官方手册(CHM格式)

- SSM框架+Layuimini的酒店管理系统开发教程

- 基于SpringBoot和Vue的招聘平台完整设计与实现教程

- 移动商品推荐系统:APP设计与实现

- JAVA代码生成器:一站式后台系统快速搭建解决方案

- JSP驾校预约管理系统设计与SSM框架结合案例解析