NVIDIA GPU与TensorRT加速深度学习应用部署

需积分: 5 15 浏览量

更新于2024-07-17

收藏 28.64MB PPTX 举报

"快速部署GPU DL应用程序177.pptx"

在当今的深度学习领域,速度至关重要,正如武术世界中的胜利者一样。NVIDIA的David在2018年4月3日的演讲中强调了这一点,他讨论了如何快速部署GPU驱动的深度学习应用,并介绍了TensorRT在提升性能方面的作用。

为何需要TensorRT?

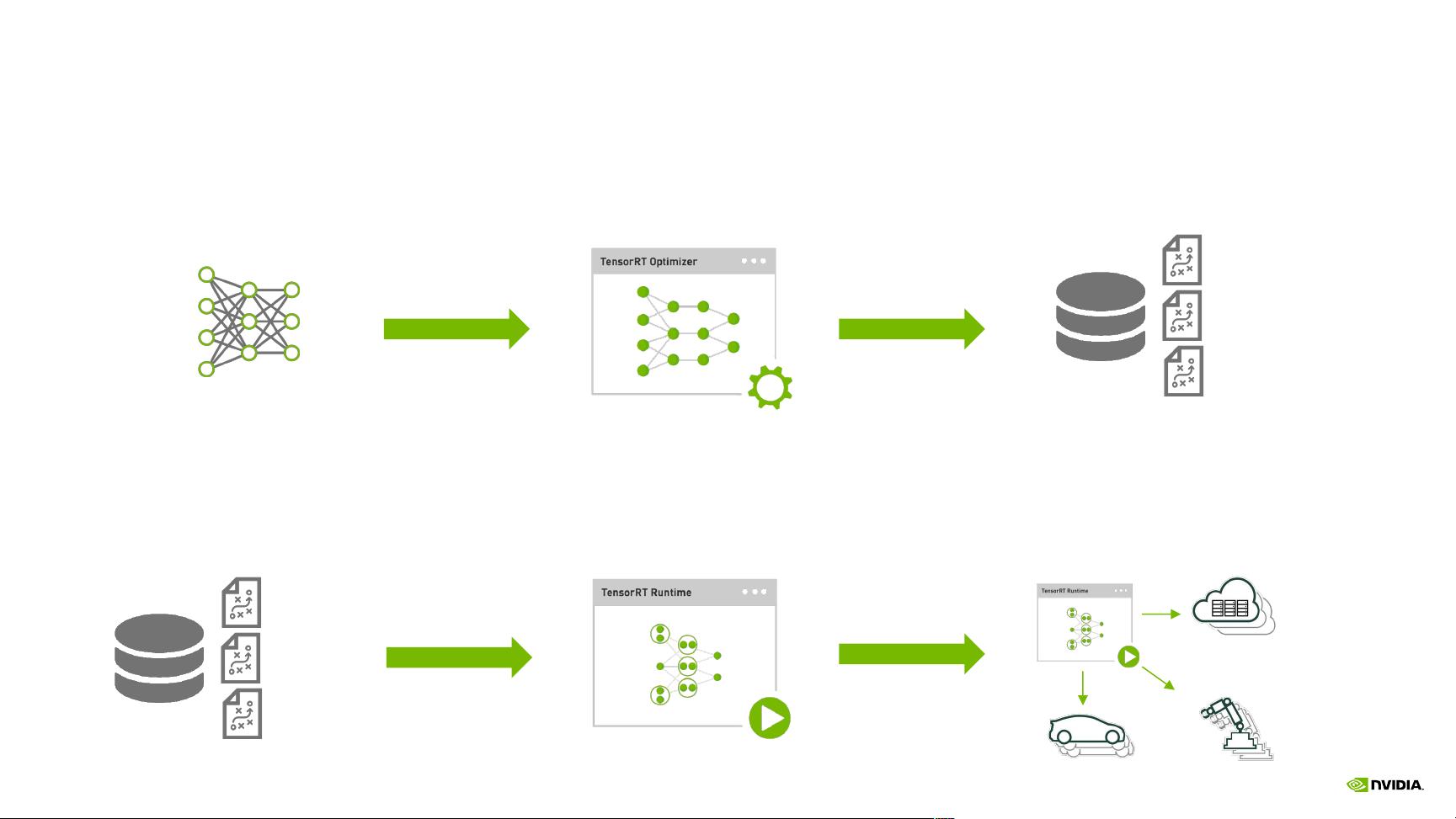

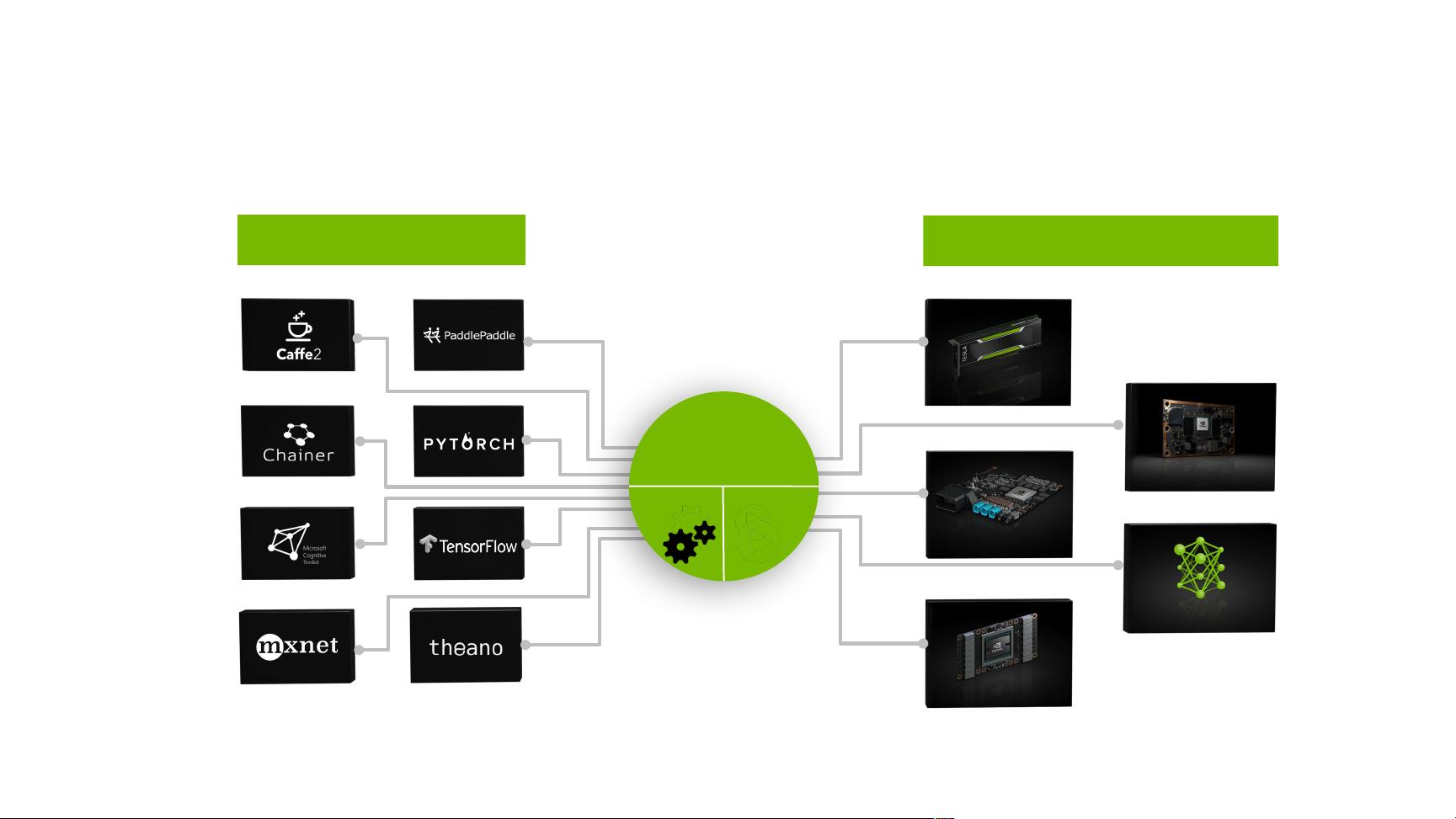

TensorRT是一个高性能的深度学习推理(Inference)优化器和运行时,它能够对训练好的神经网络模型进行解析、优化和编译,以实现最佳运行效率。在处理实时或高并发的深度学习任务时,TensorRT可以显著提高速度和效率,尤其是在GPU上运行推理工作负载时。

TensorRT+P4性能表现:

TensorRT与NVIDIA Tesla P4 GPU的结合,展示了在推理工作负载上的强大性能。NVIDIA Tesla P4 GPU专为高效能数据中心应用设计,尤其适合深度学习推理。与未优化的部署相比,它可以提供高达60倍的能效提升,这对于扩展服务器的效率至关重要。

TensorRT实践:

在实践中,TensorRT可以显著加速基于TensorFlow、PyTorch等框架构建的应用。它通过自动内存管理和低级别库的优化,如cuDNN(用于深度神经网络的GPU加速库)和cuBLAS(用于GPU的BLAS库),来减少延迟并提高吞吐量。

即将到来的力量:NGC+TRT+阿里云快速部署

NGC(NVIDIA GPU Cloud)是NVIDIA提供的一个容器注册表,包含了预构建的深度学习、机器学习和数据科学的软件堆栈。它简化了在GPU基础设施上部署和运行这些应用的过程。NGC与TensorRT的结合,加上阿里云的支持,使得在云端快速部署优化的深度学习应用成为可能。

什么是NGC?为何需要NGC?

NGC是一个包含经过验证的、容器化的深度学习和数据科学框架的仓库。它提供了开箱即用的解决方案,消除了设置和维护复杂软件环境的困扰,使用户能够专注于他们的核心任务——研发和运行深度学习模型。

了解容器:

容器是一种轻量级的虚拟化技术,允许开发者打包应用程序及其依赖项到一个可移植的容器中,确保在任何支持的平台上都能一致地运行。在深度学习环境中,容器化有助于保持环境一致性,简化版本控制,并促进团队间的协作。

NGC Web UI导航:

通过NGC的Web界面,用户可以浏览和选择合适的深度学习容器镜像,轻松下载并部署到包括阿里云在内的云平台。

NGC+阿里云实践:

将NGC与阿里云相结合,用户可以方便地在阿里云的GPU实例上快速启动和运行TensorRT优化的深度学习模型,无需手动配置和优化环境,极大地缩短了部署时间。

当前部署工作流程及挑战:

传统的部署工作流程涉及使用CUDA和NVIDIA Deep Learning SDK(如cuDNN、cuBLAS和NCCL),但这种未经优化的部署方法存在挑战,如模型推理速度慢、资源利用率低和运维复杂度高等问题。

TensorRT与NVIDIA GPU的集成,以及通过NGC和阿里云提供的云服务,为深度学习应用的快速部署和高效执行开辟了新的路径,使得各种行业,如互联网服务、医疗、媒体娱乐、安全防御和自动驾驶等,都能从深度学习的广泛应用中受益。无论是图像分类、语音识别、自然语言处理还是实时翻译,TensorRT都在推动着这些领域的技术边界。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2024-08-19 上传

weixin_38744153

- 粉丝: 0

最新资源

- CCS3.3 CSL库在多版本兼容性应用解析

- 微机室监控机:教学管理设计装置解析

- Pagina-Web-AutoLote:自动化汽车销售平台项目

- Cocos2d-x中Lua脚本的初步使用与变量访问指南

- DZ8前端模板:Bootstrap结构,适配多设备

- inet2源码工具使用教程及训练.ppt

- Python数据分析课程:Timofey Khirianov在MIPT讲授

- Java实现JTA事务控制的示例解析

- LaBSE:实现109种语言的通用句子嵌入技术

- 实现Javascript键值对集合的Map类解析

- LabView实现WebService接口的详细操作指南

- 专业太阳高度角芯片助力太阳能开发

- TensorFlow 2实现自适应梯度剪切技术AGC教程与应用

- 桶型基础独柱结构设计:带压载罐支撑平台解决方案

- LabVIEW数据库访问实例教程完整可用

- Flutter在线商店暗黑风格UI启动套件