正则化技术:L1、L2 regularization与防止过拟合策略

需积分: 0 52 浏览量

更新于2024-08-05

收藏 1.03MB PDF 举报

"正则化方法,包括L1和L2 Regularization,数据集扩增以及Dropout,是机器学习和深度学习中防止过拟合、提升模型泛化能力的关键技术。本文摘自《Neural Networks and Deep Learning》的概览,主要探讨了这些正则化策略,并强调了训练数据划分的重要性,即训练数据、验证数据和测试数据的区分。"

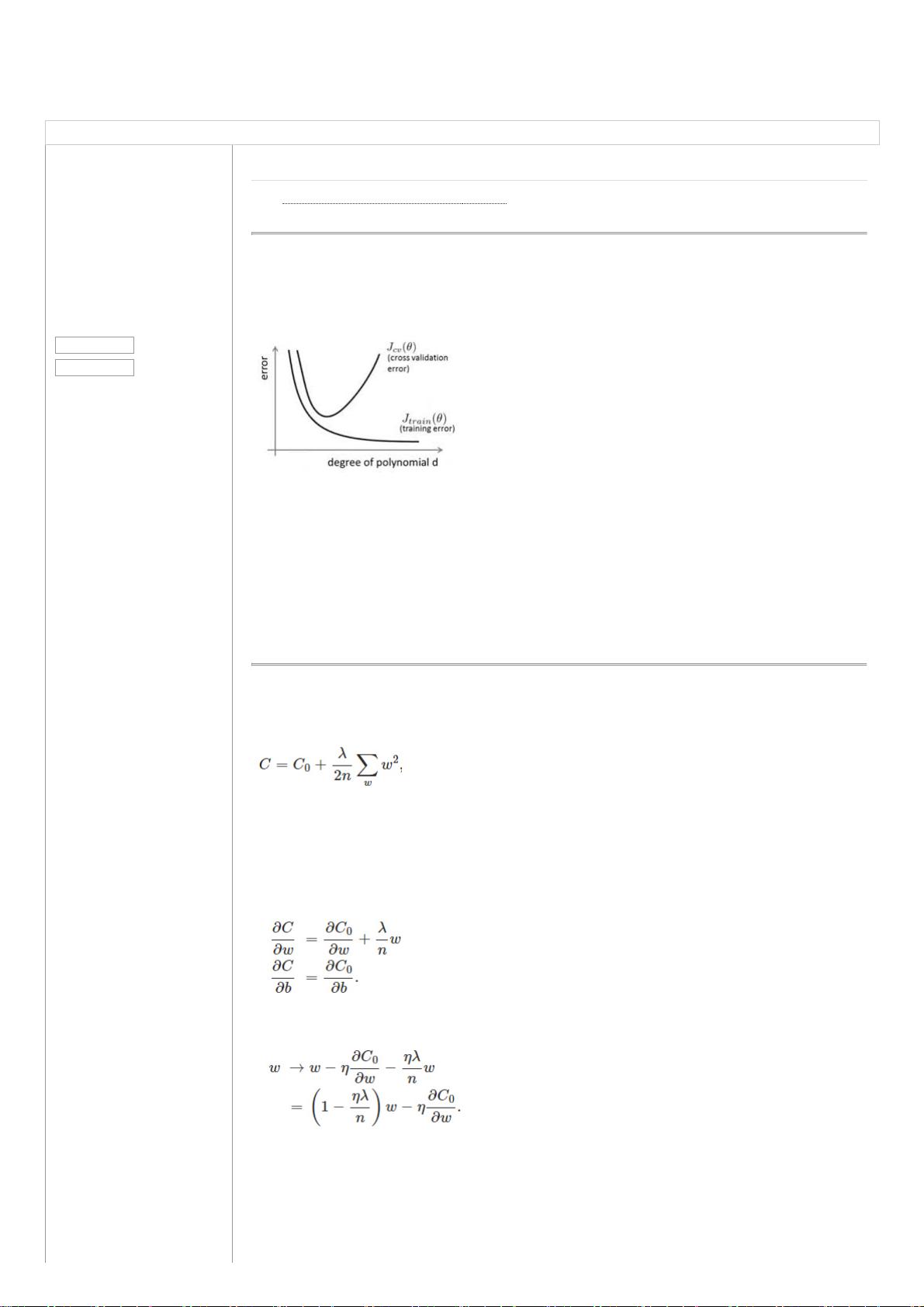

在机器学习和深度学习领域,过拟合是模型性能下降的一个常见问题,特别是在训练数据有限或模型过于复杂的情况下。过拟合发生时,模型过度学习训练数据中的噪声和特异性,导致对未见过的数据预测效果不佳。为了解决这一问题,一系列正则化技术被提出,它们的目标是限制模型的复杂性,防止过拟合,从而提高模型的泛化能力。

1. **L1 Regularization**:也称为Lasso正则化,它通过在损失函数中添加权重向量的绝对值之和作为惩罚项。L1正则化倾向于产生稀疏的权重矩阵,即许多权重参数会被压缩至零,这有助于特征选择,可以理解为一种自动的特征剔除过程。

2. **L2 Regularization**:也称为Ridge正则化,它在损失函数中添加权重向量的平方和作为惩罚项。L2正则化不会导致权重参数变为零,而是减小所有权重的大小,使得模型更加平滑,防止模型过于复杂。

3. **数据集扩增(Data Augmentation)**:这种方法通过在原始训练数据上应用各种变换,如旋转、缩放、翻转等,人为地增加数据集的大小,使模型在更广泛的数据变化上进行学习,从而提高其泛化能力。

4. **Dropout**:这是一种在训练神经网络时随机“关闭”一部分神经元的策略。每个训练迭代中,某些神经元会有一定的概率被暂时移除,迫使其他神经元学习更多的信息,减少对特定神经元的依赖,从而降低过拟合的风险。

在训练过程中,通常将数据集分为训练集、验证集和测试集。训练集用于更新模型参数,验证集用于调整超参数(如学习率、早停的epoch数等),以防止过拟合。而测试集则在模型最终确定后用于评估模型的泛化性能,不应在训练过程中使用,以保持其独立性和真实性。

通过这些正则化方法,我们可以有效地控制模型的复杂性,平衡模型的训练误差与验证误差,以达到提高模型在未知数据上的表现。在实际应用中,选择哪种正则化方式取决于具体任务和数据集的特性,可能需要通过实验比较来确定最佳策略。

2022-07-14 上传

2021-09-29 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

2021-02-15 上传

2021-05-24 上传

2021-06-01 上传

点击了解资源详情

天眼妹

- 粉丝: 29

- 资源: 332

最新资源

- 全国江河水系图层shp文件包下载

- 点云二值化测试数据集的详细解读

- JDiskCat:跨平台开源磁盘目录工具

- 加密FS模块:实现动态文件加密的Node.js包

- 宠物小精灵记忆配对游戏:强化你的命名记忆

- React入门教程:创建React应用与脚本使用指南

- Linux和Unix文件标记解决方案:贝岭的matlab代码

- Unity射击游戏UI套件:支持C#与多种屏幕布局

- MapboxGL Draw自定义模式:高效切割多边形方法

- C语言课程设计:计算机程序编辑语言的应用与优势

- 吴恩达课程手写实现Python优化器和网络模型

- PFT_2019项目:ft_printf测试器的新版测试规范

- MySQL数据库备份Shell脚本使用指南

- Ohbug扩展实现屏幕录像功能

- Ember CLI 插件:ember-cli-i18n-lazy-lookup 实现高效国际化

- Wireshark网络调试工具:中文支持的网口发包与分析