LLaMA开源模型:推动行业AI发展,降低数据安全门槛

需积分: 0 170 浏览量

更新于2024-06-26

2

收藏 2.05MB PDF 举报

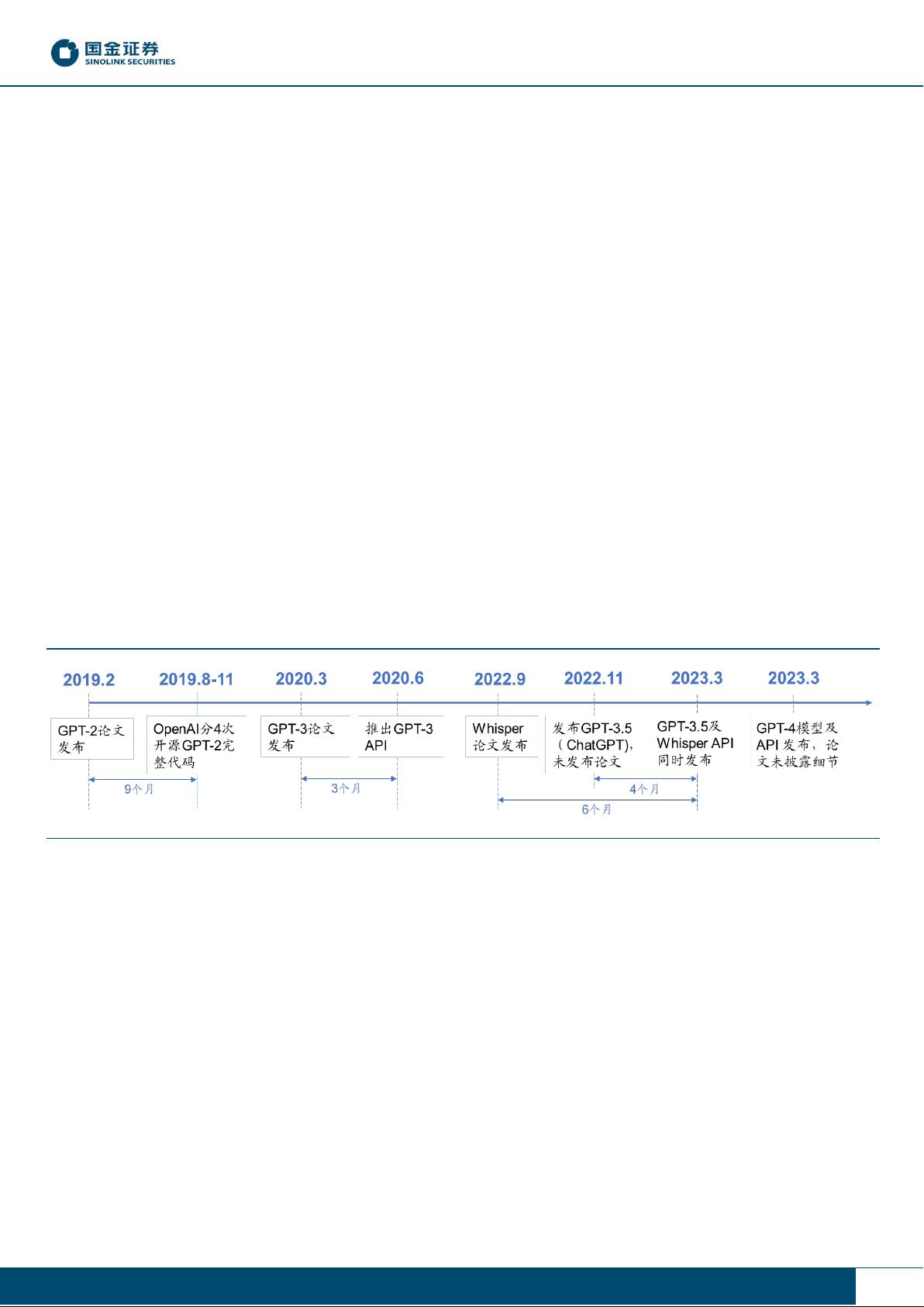

随着计算机行业的发展,大语言模型自Transformer在2017年的出现后经历了一个由开源逐渐向封闭式研发转变的过程。这个转变导致了头部人工智能(AI)公司的先进模型成为技术竞争的关键壁垒。OpenAI和Google等公司在保持部分模型开源的同时,也倾向于保留核心技术,通过这种方式建立竞争优势。

然而,直接将大型AI模型应用到特定行业面临诸多挑战,如通用能力过剩、缺乏行业专业知识和高计算资源消耗。因此,针对垂直行业的定制化模型开发变得尤为重要。通过基于开源模型(如LLaMA)进行开发,可以平衡成本效益,尤其是在对数据隐私和安全性要求高的领域,如政府、金融、电力和制造业。

Meta公司推出的LLaMA大模型是一个具有突破性的开源选择。它利用通用领域的大量开源数据集进行训练,涵盖了40种语言,拥有约1.4万亿个token,虽然参数量相对较少,但其性能却与PaLM和GPT-3等顶级模型相当。LLaMA的轻量级设计使得它在部署和二次开发上更为便捷,且其高度的灵活性、可配置性和泛化能力使其成为垂直AI模型的理想基础架构。

LLaMA的开源特性允许AI开发者根据行业特性和应用的数据进行个性化定制,从而创建符合特定行业需求的“行业发行版AI模型”。例如,斯坦福大学发布的Alpaca模型就是基于LLaMA-7B进行微调,仅需少量资源就能实现高效的对话类语言模型,这表明在迁移学习阶段,尽管初始训练可能消耗一定的算力,但在后续微调阶段成本较低。

在推理阶段,LLaMA的优势更加明显,特别是在大型服务器上,即使是8块A100 GPU也能支持大规模用户的实时推理需求。这使得LLaMA成为推动AI技术在各个垂直行业中广泛应用的重要工具,促进了技术的创新和普及。

LLaMA的开源策略不仅降低了行业进入门槛,还促进了技术生态的繁荣,使得AI技术更好地服务于不同行业的实际需求,推动了整个计算机行业的进步和技术创新。

2023-07-28 上传

2023-09-25 上传

2024-12-02 上传

2024-03-24 上传

2023-07-06 上传

2024-03-24 上传

2023-09-25 上传

职场程序猿

- 粉丝: 6393

- 资源: 3706

最新资源

- SpringTest:测试一些弹簧功能

- matlab心线代码-EEG-ECG-Analysis:用于简单EEG/ECG数据分析的MATLAB程序

- Stack-C-language-code.rar_Windows编程_Visual_C++_

- 企业名称:Proyecto Reto 2,企业最终要求的软件,企业最终合同的最终目的是在埃塞俄比亚,而在埃塞俄比亚,企业管理者必须是西班牙企业,要求客户报名参加埃洛斯和埃塞俄比亚普埃登的征状,要求参加比赛的男子应征入伍

- bh前端

- scratch-blocks-mod

- hugo-bs-refreshing

- CRC16ForPHP:这是一个符合modbus协议的CRC16校验算法PHP代码的实现

- SnatchBox(CVE-2020-27935)是一个沙盒逃逸漏洞和漏洞,影响到版本10.15.x以下的macOS。-Swift开发

- dep-selector:使用Gecode的Ruby快速依赖解决方案

- clickrup:与R中的ClickUp v2 API交互

- FelCore

- react-markdown-previewer

- ch.rar_通讯编程_Others_

- 图片:允许您向应用提供高度优化的图片

- matlab心线代码-3DfaceHR:基于3D面部界标的基于视频的HR估计项目