SVM支持向量机学习笔记:理解与应用

"SVM学习笔记,主要介绍了支持向量机(SVM)的概念,包括二维和多维情况下的理解,以及SVM的目标函数、拉格朗日乘子法和优化过程。此外,还讨论了松驰变量在处理不可分数据时的作用,并提到了SVM的泛化能力与分类边界宽度的关系。"

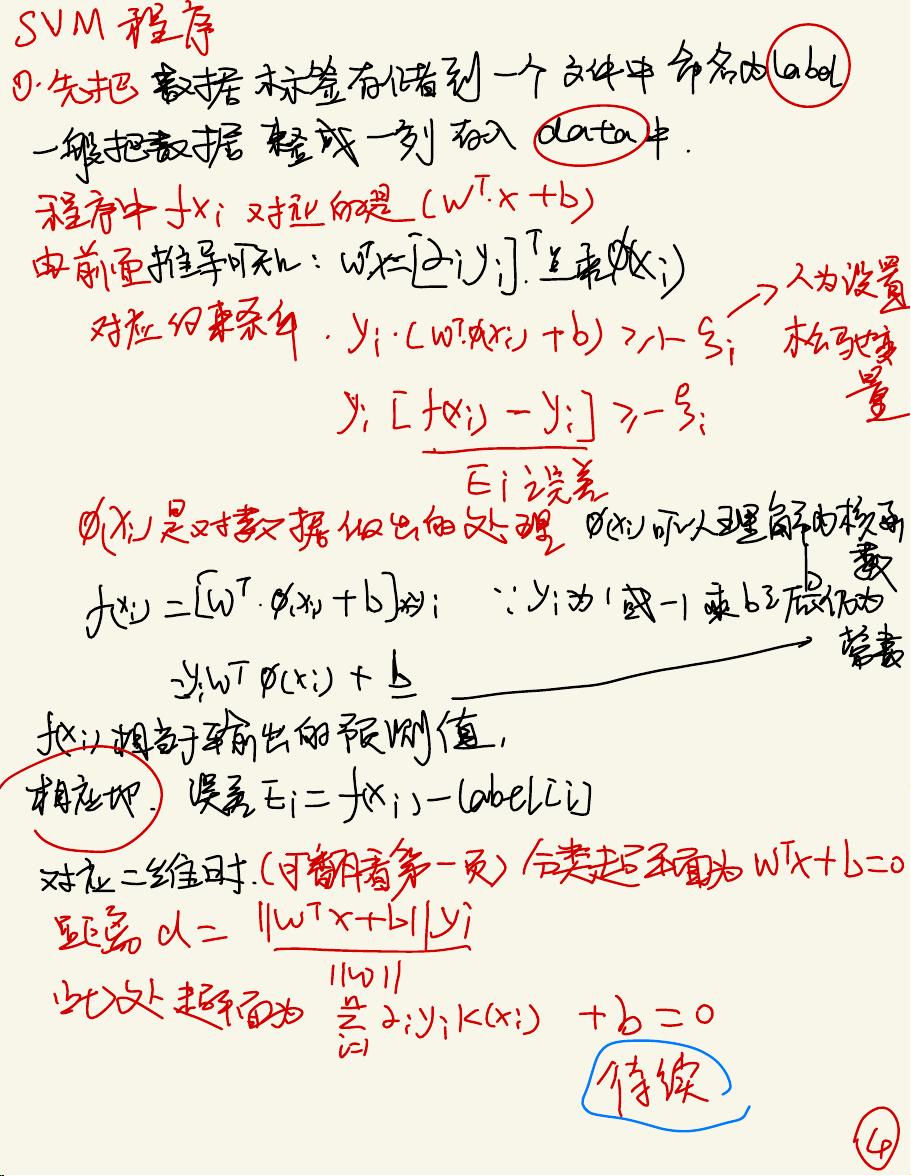

SVM(支持向量机)是一种强大的监督学习模型,尤其适用于小样本和高维数据集的分类和回归任务。在SVM中,目标是找到一个能够最大化样本与决策边界的间隔的超平面。对于二维空间中的例子,可以直观地理解为找到一个直线,该直线将不同类别的点分开,同时尽可能地远离这些点。

在二维空间中,超平面可以表示为wTx + b = 0的形式,其中w是决策边界的法向量,b是偏置项。多维情况下的超平面则是更高维度的超平面,依然由w和b确定。yi是样本的标签,可以是+1或-1,表示正类或负类。SVM的目标是找到使得所有样本点到超平面距离最大的超平面。

SVM的目标函数通常涉及找到最小化间隔的超平面,即最大化样本点到超平面的距离。这个距离被定义为样本点与超平面的内积的负值,再除以w的范数。当样本点位于错误的一侧时,这个距离会变为负值,因此在目标函数中会引入惩罚项。

为了处理线性不可分的数据,SVM引入了松弛变量ξi,它允许样本点在决策边界的一侧有一定的“误差”。这样,目标函数就会变成最小化所有样本点的ξi加上一个惩罚项C,C是控制分类错误容忍度的参数。通过拉格朗日乘子法,我们可以将约束优化问题转化为无约束优化问题,进而求解w和b。

拉格朗日函数L包含了原目标函数和所有的约束条件,通过求解L关于w和b的偏导数等于零,可以得到SVM的优化解。在解决优化问题后,我们得到的支持向量是那些离决策边界最近的样本点,它们对决策边界的位置和形状起决定作用。

SVM的泛化能力与其决策边界的宽度密切相关。较窄的决策边界可能导致过拟合,即在训练数据上表现很好,但在未见过的数据上表现差。而较宽的决策边界,即较大的间隔,通常意味着模型有更好的泛化能力,因为它对数据的噪声和异常值不那么敏感。因此,调整C的大小可以在分类精度和泛化能力之间找到平衡。

在实际应用中,SVM的训练数据通常需要先进行预处理,例如特征缩放,以便于算法的优化。此外,数据存储和读取也是实现SVM模型的重要步骤,通常会将数据和对应的标签保存在文件中,然后在程序中加载并进行处理。

SVM支持向量机是一种强大的机器学习工具,通过寻找最大间隔的超平面来实现分类,它能够有效地处理线性和非线性问题,并通过调整参数C来平衡模型的复杂度和泛化能力。理解和掌握SVM的基本原理和优化方法,对于进行机器学习项目有着重要的价值。

2021-09-30 上传

2024-10-12 上传

2023-11-11 上传

waysolong90

- 粉丝: 456

- 资源: 44

最新资源

- Sensors:该存储库包含不同传感器的简单程序

- Excel表格+Word文档各类各行业模板-迷你小台历.zip

- ser316-spring2021-B-lclindbe:作业2-单元测试

- iec61131-gaskessel:燃气锅炉的模拟调试

- 这是我学习mysql 以及 Oracle 数据库操作过程中的代码.zip

- 内存提升

- 御剑后台扫描珍藏版.zip

- node-express-mongoose-practice

- 这是一步步学习MySQL的源代码,最后的项目是一个超市管理系统的集合.zip

- kicad-custom-library:我在设计时遇到的一些组件的库

- actions-hooks-mattermost:一个简单的Webhook,用于在Mattermost通道中记录来自GitHub的部署事件

- Disco-2.12.2.zip

- composition-debugger:在合成中设置断点

- 形式验证

- 这是一个前后端分离的小实验项目,代码总量在120行左右,前端文件是在别处下载下来的,适合学完go语言基础后进一步学习.zip

- leetcode:leetcode 在线裁判