微信运维:万亿级监控数据上报与高效存储实践

版权申诉

150 浏览量

更新于2024-06-18

收藏 179KB PPTX 举报

在"微信运维实时监控数据上报及存储设计实践"的分享中,主要讨论了微信后台系统的运维监控挑战以及解决策略。首先,面对庞大的监控数据量,微信监控日志上报量高达每分钟万亿级别,这使得传统的存储方式如HDFS和本地统计面临存储容量不足、统计延迟严重的问题。由于数据的海量性,1分钟内就需要处理亿万级的时间序列数据,如何提升TSDB的读性能以及保证长时间跨度的数据访问能力成为关键。

微信团队针对这一问题提出了轻量监控数据上报框架,该框架采用了统一的数据格式,如ID KeyValue,其中ID为128k长度的整型,Value部分是32位无符号整型,通过sync_fetch_and_add和sync_bool_compare_and_swap等高效原子操作,实现了累加、设置新值、设置最大值等功能。这种设计显著降低了CPU消耗,支持实时数据采集,有助于简化存储和汇总过程。

针对业务数据和监控数据的区分,微信采取了数据分类策略,将复杂且可能涉及高延迟的业务数据与简单、低延迟的监控数据分开处理。为了提高监控数据的上报效率,团队放弃了日志上报的传统方式,转向了轻量上报框架,减少了网络压力和存储空间的消耗。

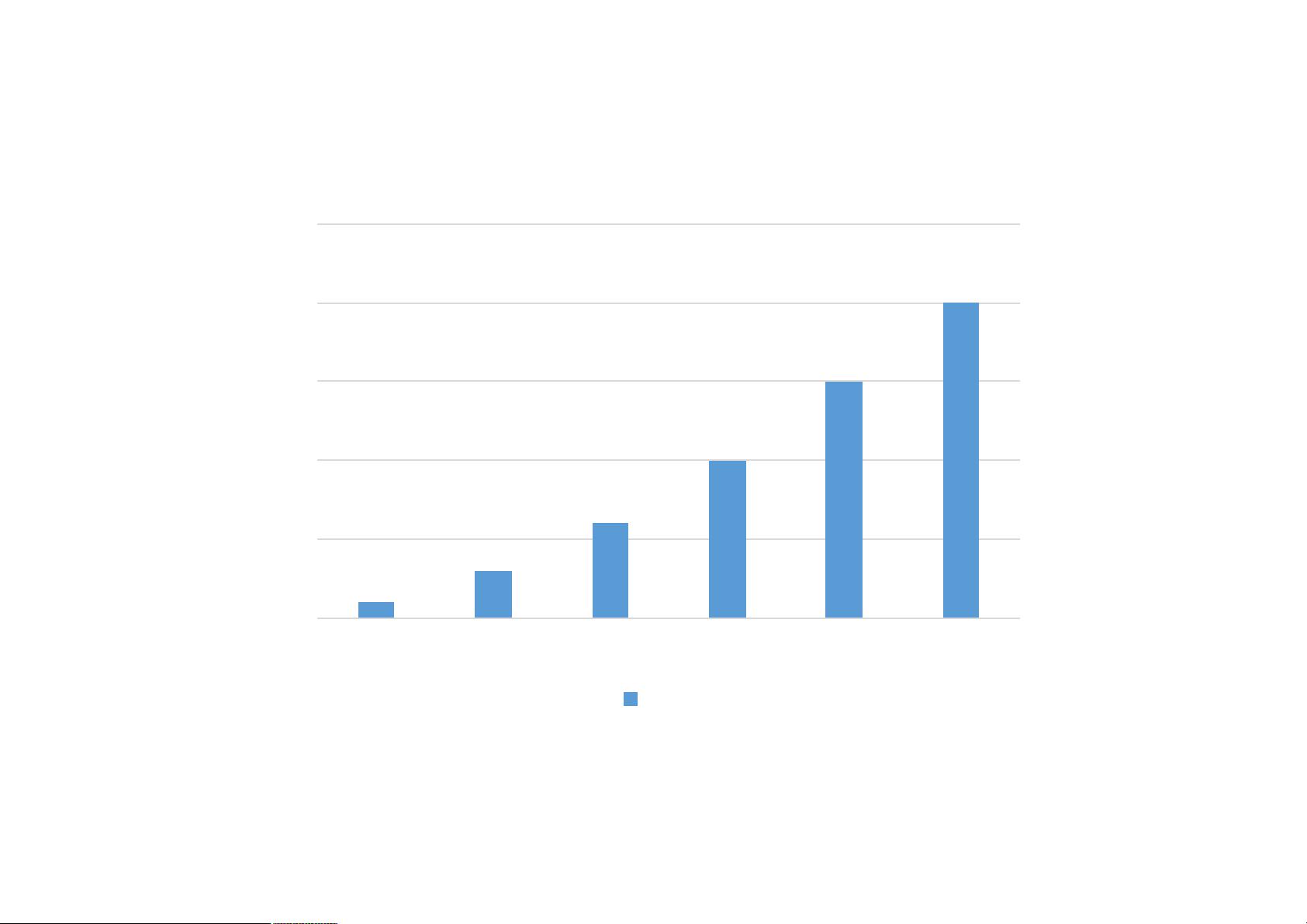

针对时间序列数据的特点,微信高性能监控数据存储采用了Key+Time+Value的数据结构,尽管数据量巨大,一天内可达2880亿条,但通过设计分钟级到天级的内存缓存和KV存储,以及历史数据的缓存机制,如使用Key映射关系数据库,来优化历史数据的查询性能。然而,原始数据的查询性能和缓存命中率仍然存在问题,尤其是在处理复杂关系数据时,查询效率较低。

为了定位故障和分析问题,多维度Key(如机器、接口、调用数等)在查询中的作用显得尤为重要。例如,当发现失败总数上升时,可以通过多维度Key快速定位到故障机器和接口,从而进行精确的故障排查和性能优化。

这个分享深入探讨了微信运维监控系统在海量数据上报和存储方面的技术实践,包括数据格式标准化、高效处理算法、缓存策略以及多维度查询优化,旨在提供一个在大规模实时监控场景下的实用解决方案。

2021-10-13 上传

2021-10-13 上传

2021-10-10 上传

2021-10-11 上传

2021-09-18 上传

小小哭包

- 粉丝: 2050

- 资源: 4203

最新资源

- 黑板风格计算机毕业答辩PPT模板下载

- CodeSandbox实现ListView快速创建指南

- Node.js脚本实现WXR文件到Postgres数据库帖子导入

- 清新简约创意三角毕业论文答辩PPT模板

- DISCORD-JS-CRUD:提升 Discord 机器人开发体验

- Node.js v4.3.2版本Linux ARM64平台运行时环境发布

- SQLight:C++11编写的轻量级MySQL客户端

- 计算机专业毕业论文答辩PPT模板

- Wireshark网络抓包工具的使用与数据包解析

- Wild Match Map: JavaScript中实现通配符映射与事件绑定

- 毕业答辩利器:蝶恋花毕业设计PPT模板

- Node.js深度解析:高性能Web服务器与实时应用构建

- 掌握深度图技术:游戏开发中的绚丽应用案例

- Dart语言的HTTP扩展包功能详解

- MoonMaker: 投资组合加固神器,助力$GME投资者登月

- 计算机毕业设计答辩PPT模板下载