EM算法详解:从高斯混合模型到参数估计

需积分: 9 95 浏览量

更新于2024-08-02

收藏 904KB PPT 举报

"EM算法的相关介绍,PPT格式,适合学习和分享,涵盖了高斯混合模型、EM算法思想、应用及极大似然估计等内容。"

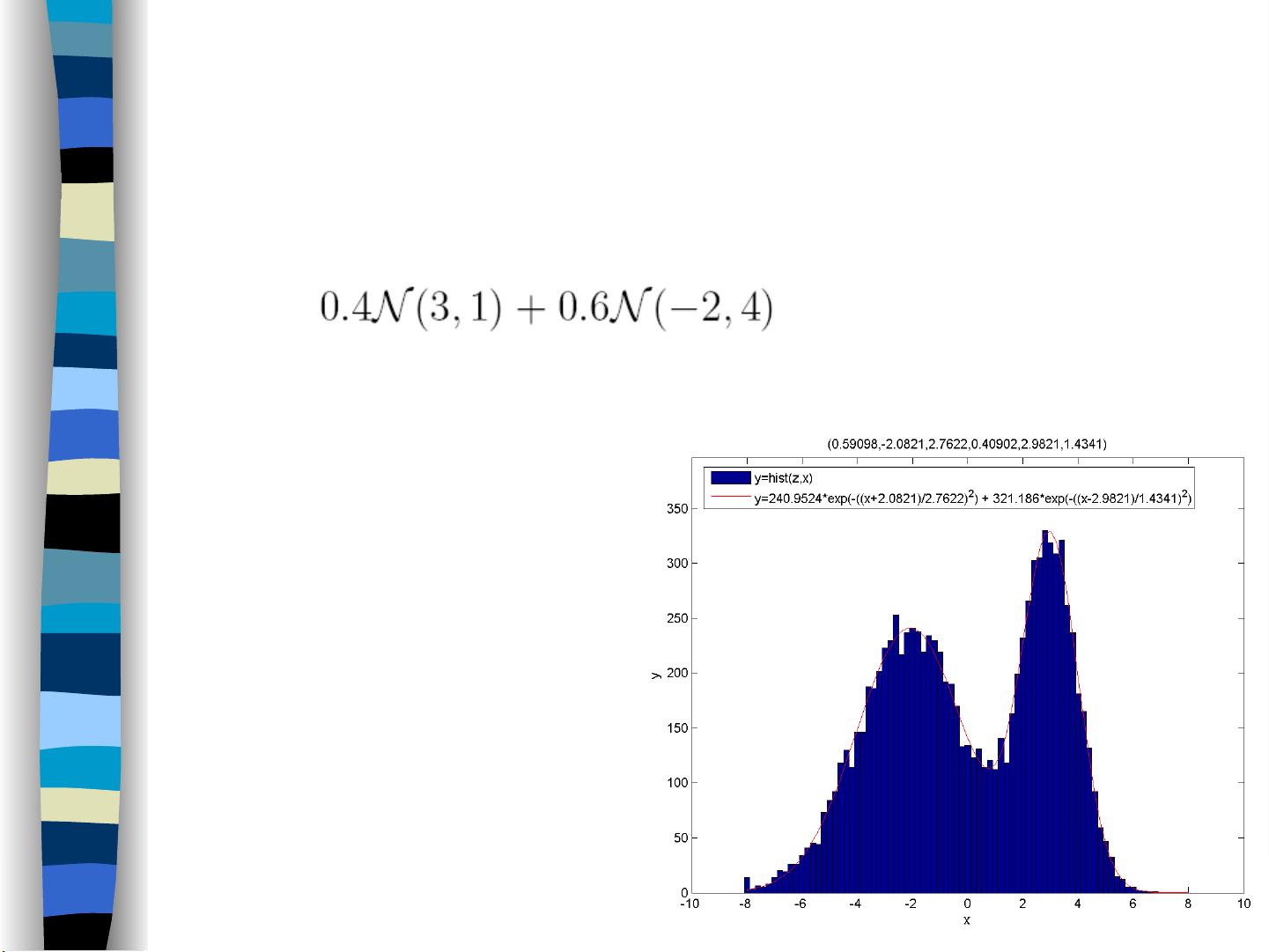

EM算法,全称为期望最大化(Expectation Maximization),是一种在统计学和机器学习中常用的参数估计方法。它特别适用于处理含有隐变量的概率模型,如高斯混合模型。高斯混合模型是概率模型的一种,由多个不同的高斯分布(正态分布)加权组合而成。在混合模型中,每个观测数据点可能属于其中一个或多个成分,而每个成分的权重表示该成分对整体模型的贡献。

在高斯混合模型中,每个成分都是一个二维正态分布,具有自己的均值和方差。例如,假设我们有两类数据,如一个班级中男生和女生的身高分布,我们可以用两个高斯分布来分别表示男生和女生的身高。当给定一系列观测数据时,我们的目标是估计出这些高斯分布的参数,包括各自的均值和方差,以及它们的相对比例。然而,由于我们通常无法直接观察到数据属于哪个成分(即隐变量),这使得参数估计变得复杂。

EM算法提供了一种有效解决这个问题的方法。它通过迭代的方式,将参数估计过程分为两步:E步(期望步骤)和M步(最大化步骤)。在E步中,根据当前参数估计,计算每个数据点属于每个成分的概率;在M步中,利用这些概率更新模型参数,通常是最大化对数似然函数。这两个步骤交替进行,直到模型参数收敛或者达到预设的迭代次数。

极大似然估计(Maximum Likelihood Estimation, MLE)是EM算法的基础。在MLE中,我们寻找使观测数据出现概率最大的模型参数,即似然函数的最大值。对于高斯混合模型,由于其复杂的数学结构,直接求解似然函数的极大值通常是困难的,因此EM算法提供了一个有效的近似解决方案。

在EM算法的应用中,除了高斯混合模型,还包括隐马尔可夫模型(HMM)、主题模型等。EM算法的优势在于它能够处理不完全数据,而且通常能保证参数估计的稳定性。然而,EM算法可能会陷入局部最优解,因此在实际应用中,可能需要多次初始化或结合其他优化策略来获得更优结果。

EM算法是机器学习和统计学中一个强大的工具,尤其在处理含有隐变量的概率模型时。理解并掌握EM算法,对于数据建模和参数估计有着重要的意义。在学习EM算法时,结合实际案例和算法的迭代过程,可以帮助我们更好地理解其工作原理和应用场景。

2022-09-21 上传

2009-12-31 上传

2022-07-13 上传

2011-04-01 上传

2022-07-15 上传

2022-07-14 上传

ywanghuan

- 粉丝: 2

- 资源: 4

最新资源

- 高清艺术文字图标资源,PNG和ICO格式免费下载

- mui框架HTML5应用界面组件使用示例教程

- Vue.js开发利器:chrome-vue-devtools插件解析

- 掌握ElectronBrowserJS:打造跨平台电子应用

- 前端导师教程:构建与部署社交证明页面

- Java多线程与线程安全在断点续传中的实现

- 免Root一键卸载安卓预装应用教程

- 易语言实现高级表格滚动条完美控制技巧

- 超声波测距尺的源码实现

- 数据可视化与交互:构建易用的数据界面

- 实现Discourse外聘回复自动标记的简易插件

- 链表的头插法与尾插法实现及长度计算

- Playwright与Typescript及Mocha集成:自动化UI测试实践指南

- 128x128像素线性工具图标下载集合

- 易语言安装包程序增强版:智能导入与重复库过滤

- 利用AJAX与Spotify API在Google地图中探索世界音乐排行榜