MapReduce:大规模集群简化数据处理的核心模型

需积分: 0 150 浏览量

更新于2024-08-03

收藏 174KB PDF 举报

MapReduce: Simplified Data Processing on Large Clusters 是一篇由 Jeffrey Dean 和 Sanjay Ghemawat 发表的重要论文,首次提出了一个编程模型及其在Google内部广泛应用的数据处理解决方案。这篇论文的核心是阐述了 MapReduce 的概念,它是一种专为大规模集群设计的分布式计算框架,旨在简化复杂数据处理任务的编程。

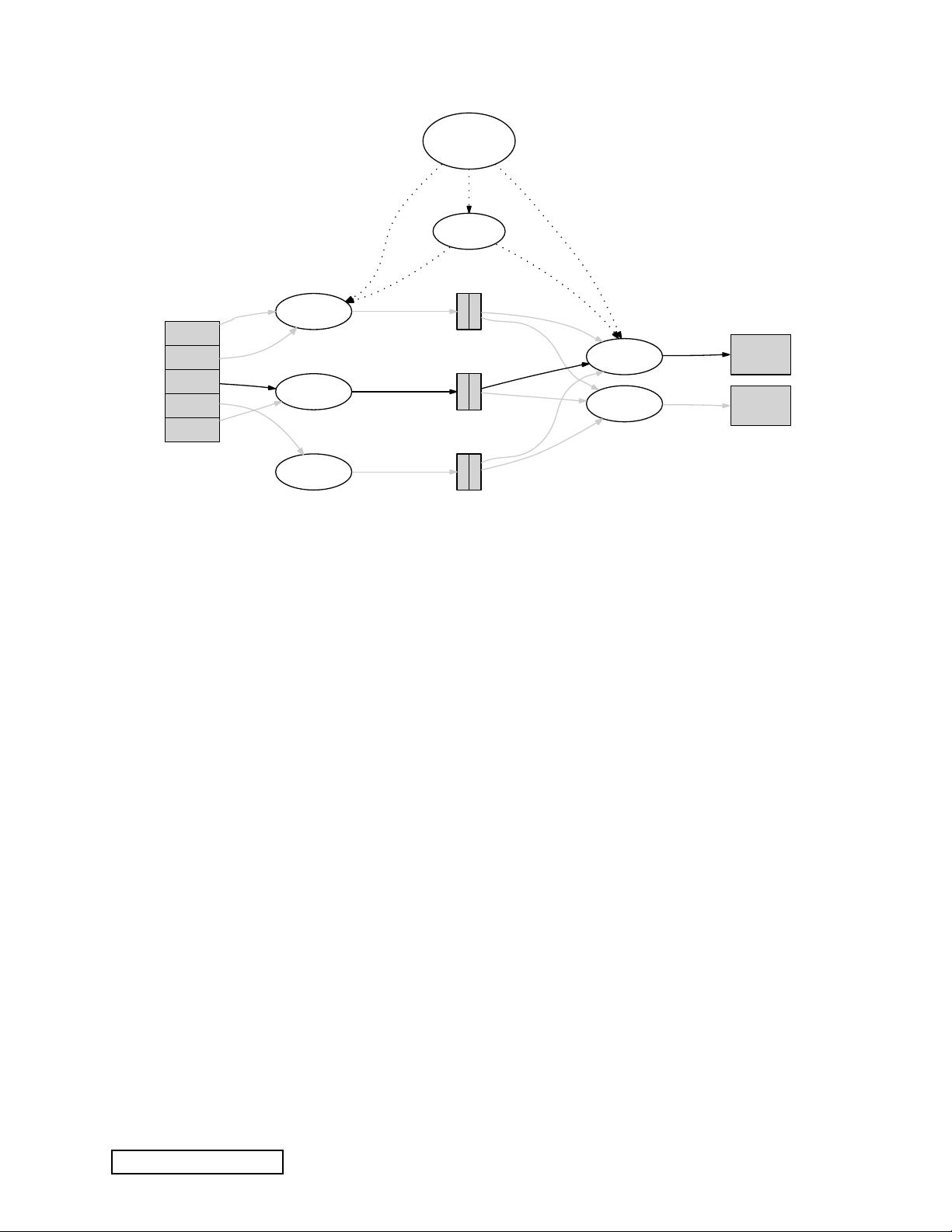

MapReduce 的核心思想在于将复杂的数据处理任务分解为两个主要阶段:Map 和 Reduce。Map 阶段,用户定义一个 map 函数,这个函数接收键值对作为输入,通过执行特定逻辑生成一系列中间键值对。这个过程实现了数据的预处理和初步分组,使得后续的 Reduce 阶段能更高效地进行聚合操作。

Reduce 阶段则是对所有与相同中间键关联的值进行合并,通常用于生成最终结果。这种设计模式非常适合那些可以通过键进行划分和汇总的任务,如搜索引擎的网页索引、数据分析等。通过这种方式,MapReduce 能够充分利用集群中的大量廉价机器,自动并行化程序执行,大大提高了处理大规模数据的能力。

论文强调,MapReduce 框架将并行化和分布式系统管理的复杂性隐藏起来,程序员无需具备并行或分布式系统背景,也能轻松编写出高效运行的程序。这使得非专家也能利用大型分布式系统的强大能力,降低了数据处理的门槛。

作者的 MapReduce 实现是基于大量普通计算机(commodity machines)的,它优化了输入数据的分割、任务调度、机器故障处理以及跨机器通信管理,确保了系统的高可用性和性能。这种架构灵活性和易用性使得 MapReduce 成为了现代大数据处理领域不可或缺的技术基础,并且对诸如 Hadoop 等开源项目产生了深远影响。

MapReduce论文不仅介绍了该模型的设计原理,还展示了其在实际场景中的强大效能,对于理解和应用分布式计算、云计算以及大数据分析具有里程碑式的意义。通过阅读这篇论文,读者可以深入理解如何编写和执行高效的分布式数据处理程序,这对于任何从事IT行业,尤其是处理海量数据的人士来说都是宝贵的资源。

2019-02-20 上传

2018-04-20 上传

2011-02-16 上传

2012-07-24 上传

2009-12-07 上传

113 浏览量

2012-11-05 上传

313 浏览量

CS-Polaris

- 粉丝: 956

- 资源: 8

最新资源

- 掌握压缩文件管理:2工作.zip文件使用指南

- 易语言动态版置入代码技术解析

- C语言编程实现电脑系统测试工具开发

- Wireshark 64位:全面网络协议分析器,支持Unix和Windows

- QtSingleApplication: 确保单一实例运行的高效库

- 深入了解Go语言的解析器组合器PARC

- Apycula包安装与使用指南

- AkerAutoSetup安装包使用指南

- Arduino Due实现VR耳机的设计与编程

- DependencySwizzler: Xamarin iOS 库实现故事板 UIViewControllers 依赖注入

- Apycula包发布说明与下载指南

- 创建可拖动交互式图表界面的ampersand-touch-charts

- CMake项目入门:创建简单的C++项目

- AksharaJaana-*.*.*.*安装包说明与下载

- Arduino天气时钟项目:源代码及DHT22库文件解析

- MediaPlayer_server:控制媒体播放器的高级服务器