Python爬虫实战:抓取山东大学成绩网站数据

170 浏览量

更新于2024-08-28

收藏 1.57MB PDF 举报

"零基础写python爬虫之爬虫编写全记录"

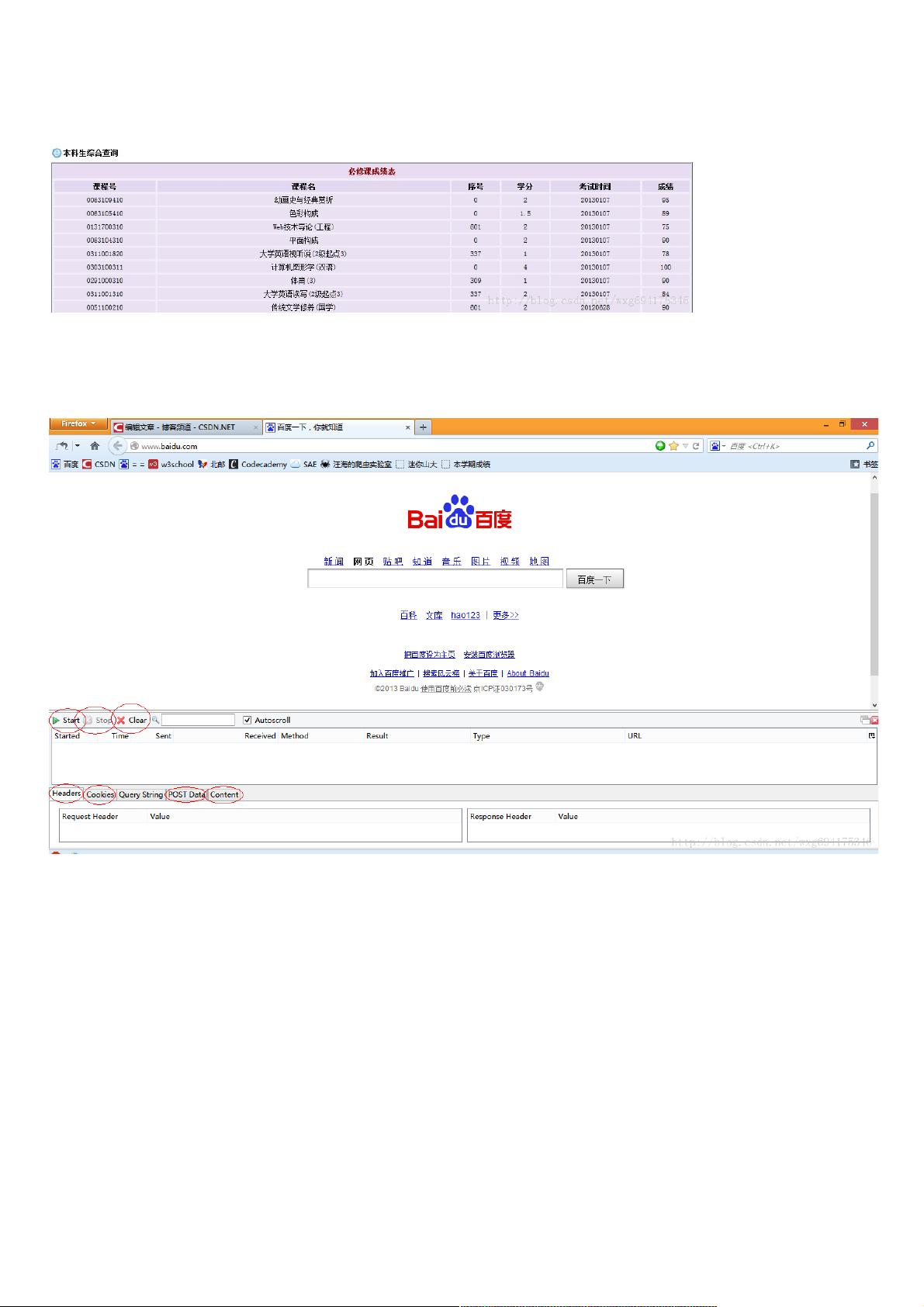

本文主要介绍了如何使用Python编写爬虫,针对一个需要登录的网站(如山东大学成绩查询网站)抓取数据,特别是如何处理POST请求和COOKIES。以下是相关知识点的详细说明:

1. **HTTP协议分析工具**:HttpFox是一款用于分析HTTP请求和响应的工具,它可以帮助开发者理解网络请求的过程,包括时间、内容、COOKIE等关键信息。在进行爬虫开发前,首先需要安装并学会使用这类工具,以便了解网页登录时发送的数据。

2. **登录过程分析**:在登录网站时,通常会涉及到POST请求,用于提交用户填写的登录信息,如用户名(stuid)和密码(pwd)。通过HttpFox可以观察到这些数据,了解登录请求的具体内容。

3. **POST请求与GET请求**:POST请求用于提交数据,如登录信息;GET请求通常用于获取数据,如页面的HTML源码。在登录场景下,POST请求后的响应可能包含一个重定向(Redirect),即服务器返回新的URL以继续请求流程。

4. **COOKIES管理**:登录成功后,服务器会返回COOKIES,这里特别提到了一个名为ACCOUNT的COOKIE,它通常用于标识用户已登录的状态。COOKIES有时设置有生命周期,过期后将自动失效。

5. **查看HTTP响应内容**:通过HttpFox,可以查看GET请求返回的HTML源码,这是爬虫抓取数据的主要对象。爬虫需要解析这些源码,提取所需信息,如成绩数据。

6. **Python爬虫实现**:在Python中,可以使用requests库来模拟HTTP请求,包括POST和GET。例如,使用`requests.post(url, data=data)`发送POST请求,其中data是包含登录信息的字典。同时,requests库可以处理COOKIES,通过Session对象来保持会话状态。

7. **网页数据解析**:获取HTML源码后,需要使用如BeautifulSoup或lxml等库来解析HTML,提取出具体的成绩数据。例如,找到对应的表格元素,遍历行和列获取每个科目的成绩。

8. **登录状态维持**:在Python爬虫中,使用`requests.Session()`创建一个会话对象,它可以自动处理COOKIES,使得后续的请求能保持登录状态。登录成功后,保存接收到的COOKIES,然后在后续请求中携带这些COOKIES,以模拟用户已登录的状态。

9. **错误处理和反反爬策略**:在实际爬虫编写中,需要考虑各种可能的异常,如网络错误、验证码、动态加载等。同时,很多网站会有反爬机制,需要通过设置延迟、随机User-Agent、模拟浏览器行为等方式避免被封禁。

10. **爬虫伦理**:最后,虽然爬虫技术可以自动化获取数据,但必须遵守网站的使用条款,尊重网站的版权,不进行非法数据采集,以免触犯法律法规。

以上就是从提供的资源摘要中提炼出的Python爬虫相关知识,包括HTTP请求分析、登录处理、COOKIES管理和网页数据抓取等核心步骤。

653 浏览量

2024-02-22 上传

153 浏览量

275 浏览量

点击了解资源详情

185 浏览量

378 浏览量

489 浏览量

weixin_38546608

- 粉丝: 6

- 资源: 945