深度学习PyTorch实践:RNN与GRU详解及训练

PDF格式 | 251KB |

更新于2024-08-29

| 53 浏览量 | 举报

本文主要介绍了如何在PyTorch环境中动手学习深度学习中的循环神经网络,包括传统RNN和GRU以及LSTM的实现。文章结构清晰,分为三个部分:

1. **传统RNN**:

- RNN(循环神经网络)在处理时间序列数据时存在梯度消失或梯度爆炸的问题,这源于反向传播通过时间步骤时的链式法则可能导致梯度信息逐渐衰减或变得过大。BPTT(Backpropagation Through Time)是解决这个问题的一种策略,但并非完全有效。

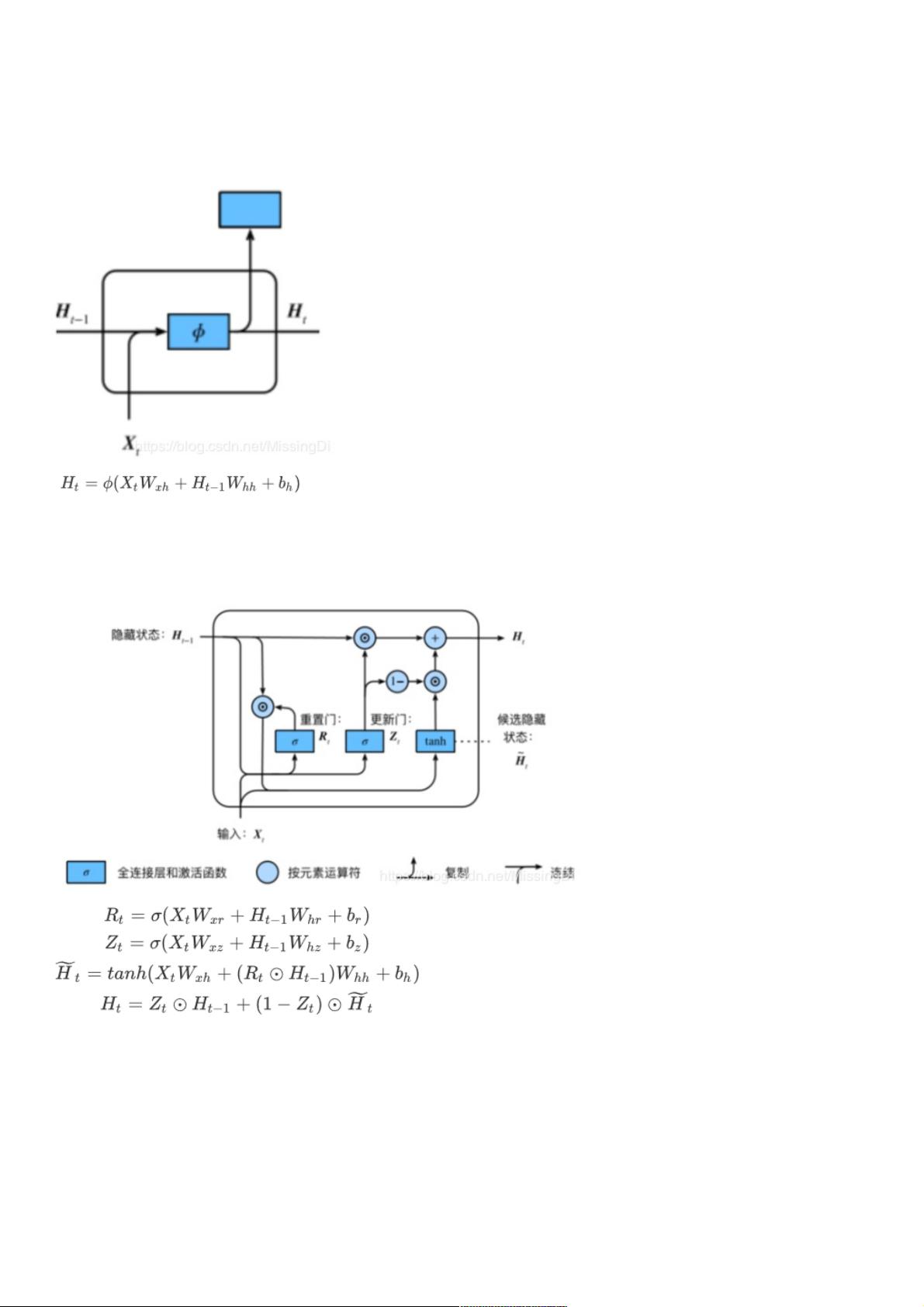

2. **GRU (Gated Recurrent Unit)**:

- GRU是一种改进的RNN结构,通过引入重置门和更新门来缓解梯度问题。重置门控制着信息是否应忘记之前的状态,而更新门则决定新输入与旧状态的融合程度。这种设计使得GRU能够更好地捕捉时间序列中不同时间步之间的依赖关系,尤其是长期依赖。

- 实现步骤:

- 载入数据集:首先导入必要的库,如os、numpy、torch等,并加载预处理过的歌词数据集。

- 初始化参数:定义模型参数,如输入、隐藏层和输出大小,以及随机生成初始权重。

3. **LSTM (Long Short-Term Memory)**:

- LSTM同样用于处理时间序列,它有三个门(输入门、遗忘门和输出门),可以更好地控制信息流,避免了传统RNN的梯度问题。

- 实现步骤:

- 同样初始化参数,如GRU部分,但增加了额外的门参数。

- LSTM主函数,定义LSTM单元的计算过程。

- 训练模型:使用PyTorch的nn.Module和优化器进行模型训练,包括前向传播、损失计算和反向传播。

- 简洁实现:文章还提到了如何使用简洁的方式实现这些复杂的神经网络结构,可能包括封装模块和使用高级API。

本篇文章通过实践介绍了如何使用PyTorch构建和训练循环神经网络(RNN、GRU和LSTM),并展示了在实际项目中处理时间序列数据的关键步骤和参数初始化。这对于理解和应用深度学习在序列建模任务中非常重要。

相关推荐

weixin_38728277

- 粉丝: 3

最新资源

- 32位TortoiseSVN_1.7.11版本下载指南

- Instant-gnuradio:打造定制化实时图像和虚拟机GNU无线电平台

- PHP源码工具PHProxy v0.5 b2:多技术项目源代码资源

- 最新版PotPlayer单文件播放器: 界面美观且功能全面

- Borland C++ 必备库文件清单与安装指南

- Java工程师招聘笔试题精选

- Copssh:Windows系统的安全远程管理工具

- 开源多平台DimReduction:生物信息学的维度缩减利器

- 探索Novate:基于Retrofit和RxJava的高效Android网络库

- 全面升级!最新仿挖片网源码与多样化电影网站模板发布

- 御剑1.5版新功能——SQL注入检测体验

- OSPF的LSA类型详解:网络协议学习必备

- Unity3D OBB下载插件:简化Android游戏分发流程

- Android网络编程封装教程:Retrofit2与Rxjava2实践

- Android Fragment切换实例教程与实践

- Cocos2d-x西游主题《黄金矿工》源码解析