迁移学习详解:归纳式与直推式

需积分: 0 17 浏览量

更新于2024-08-05

收藏 547KB PDF 举报

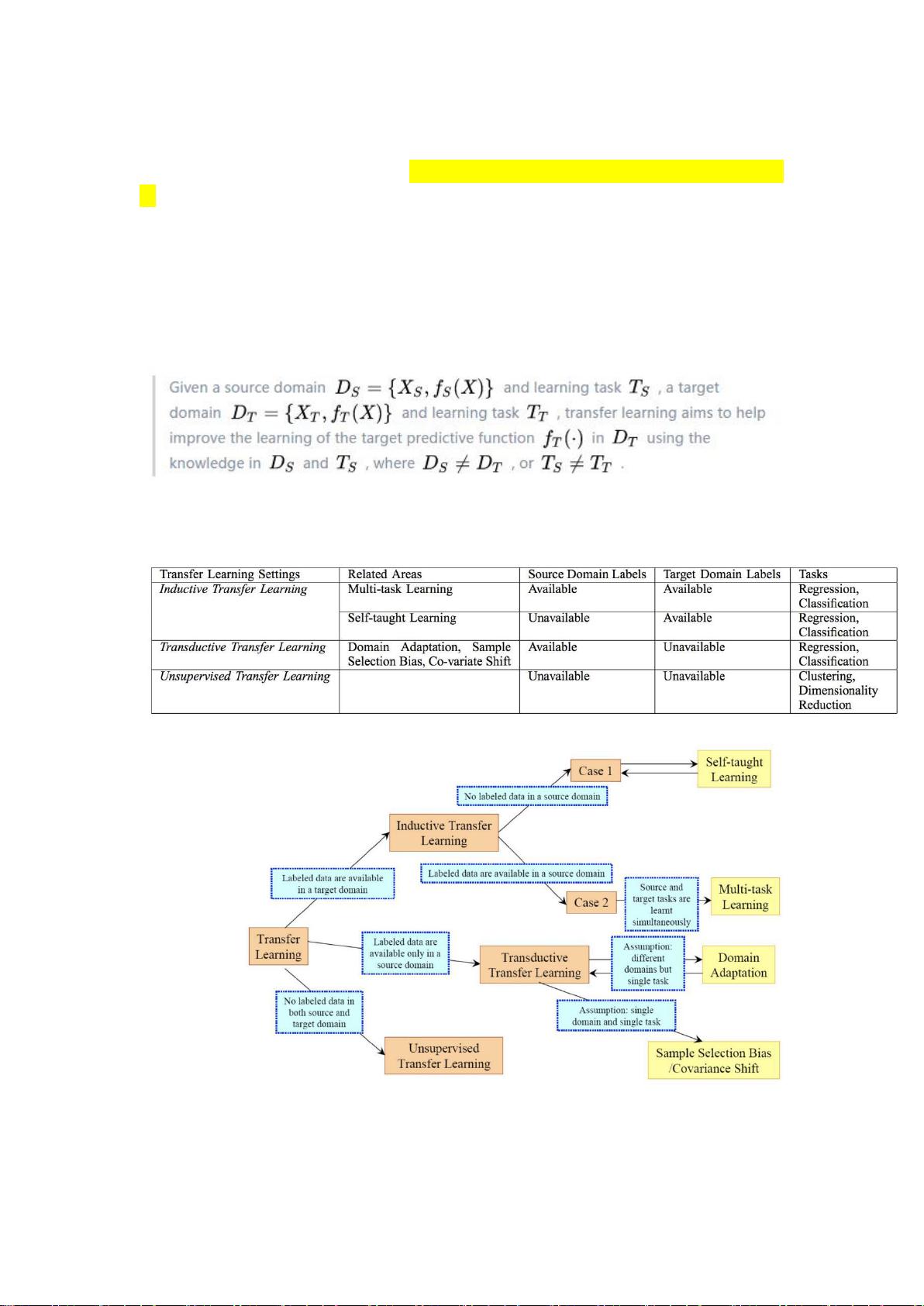

"这篇文章主要介绍了迁移学习的基本概念和两种主要分类——归纳式迁移学习和直推式学习。迁移学习是一种利用已有模型的知识来加速和优化新任务学习的技术。文章提到了自我学习作为归纳式迁移学习的一个例子,并讨论了深度学习中可能遇到的问题,如灾难性遗忘,以及解决这个问题的方法,如进步神经网络。"

正文:

迁移学习是机器学习领域的一个重要分支,它的核心思想是利用预训练模型在源任务上学到的知识来改进目标任务的学习效果。在实际应用中,由于不同任务之间通常存在某种程度的相关性,迁移学习能够显著提高模型的泛化能力,特别是在数据有限或新任务与源任务高度相关的场景下。

**归纳式迁移学习(Inductive Transfer Learning)**

归纳式迁移学习着重于学习出适用于目标领域的网络特征。在这一过程中,我们拥有目标领域的 Ground Truth Label,即真实标签,这意味着我们可以直接利用这些标签来指导网络学习和特征提取。自我学习是归纳式迁移学习的一个实例,通过在大量数据上预训练模型,然后将学习到的特征应用于特定任务,例如图像分类。

然而,归纳式迁移学习面临一个问题,即“灾难性遗忘”(Catastrophic Forgetting)。当预训练模型用于新任务时,它可能会忘记在原始任务中学习到的特征。为了解决这个问题,研究人员提出了几种策略:

1. **进步神经网络(Progressive Neural Networks)** 通过横向连接的方式,将已经训练好的模型参数传授给新任务,同时保持原有模型的参数不变,避免在反向传播过程中破坏原有的学习成果。

2. **克服灾难性遗忘的其他方法** 包括动态权重分配、多任务学习、记忆强化学习等,目的是在学习新任务的同时保持对旧任务的知识。

**直推式学习(Transductive Transfer Learning)**

直推式学习则更侧重于利用源任务的数据直接对目标任务进行预测,而不需要在目标域上重新训练模型。这种情况下,目标域的数据通常在学习过程中不可见,只在最后阶段用于评估。直推式学习在实际应用中可能更为灵活,但其效果依赖于源任务和目标任务之间的相似性。

迁移学习通过充分利用现有资源,提高了模型在新任务上的适应性和性能。随着深度学习技术的发展,迁移学习在图像识别、自然语言处理、推荐系统等多个领域都取得了显著的成果。对于有限数据和资源约束的项目,迁移学习已经成为提升模型表现的重要工具。

2021-10-01 上传

2022-07-14 上传

2019-01-25 上传

2023-09-09 上传

2022-07-15 上传

2022-07-14 上传

2022-09-23 上传

明儿去打球

- 粉丝: 17

- 资源: 327

最新资源

- 掌握Jive for Android SDK:示例应用的使用指南

- Python中的贝叶斯建模与概率编程指南

- 自动化NBA球员统计分析与电子邮件报告工具

- 下载安卓购物经理带源代码完整项目

- 图片压缩包中的内容解密

- C++基础教程视频-数据类型与运算符详解

- 探索Java中的曼德布罗图形绘制

- VTK9.3.0 64位SDK包发布,图像处理开发利器

- 自导向运载平台的行业设计方案解读

- 自定义 Datadog 代理检查:Python 实现与应用

- 基于Python实现的商品推荐系统源码与项目说明

- PMing繁体版字体下载,设计师必备素材

- 软件工程餐厅项目存储库:Java语言实践

- 康佳LED55R6000U电视机固件升级指南

- Sublime Text状态栏插件:ShowOpenFiles功能详解

- 一站式部署thinksns社交系统,小白轻松上手