大数据技术入门:Hadoop2.7+HBase1.0+Hive1.2安装配置指南

需积分: 10 32 浏览量

更新于2024-07-20

收藏 5.05MB PDF 举报

"这篇文档详细介绍了在2015年如何安装配置大数据技术栈,包括Hadoop2.7.1、HBase1.0、Hive1.2以及ZooKeeper3.4.6。作者提供了相关的安装参考网址,并列举了一系列在Linux系统中进行操作的基础命令,如用户管理、文件解压、远程拷贝、进程管理和端口检查等。此外,还提及了使用VMware虚拟机来搭建测试集群环境的初步步骤。"

在大数据处理领域,Hadoop、HBase和Hive是三个至关重要的组件:

1. Hadoop是Apache基金会的一个开源项目,主要由HDFS(分布式文件系统)和MapReduce(并行计算框架)两大部分组成。Hadoop2.7.1是Hadoop的一个稳定版本,提供了高可用性(HA)的NameNode和提升的性能优化。安装Hadoop涉及配置HDFS的各个节点,如DataNodes和NameNodes,以及设置环境变量,确保集群间通信正常。

2. HBase是构建在Hadoop之上的NoSQL数据库,它提供实时读写和强一致性,特别适合于大数据的随机读取和写入操作。HBase1.0版引入了许多增强功能和稳定性改进。安装HBase需要配置HBase的Master节点、RegionServers以及与Hadoop的集成。

3. Hive是一个数据仓库工具,可以将结构化的数据文件映射为一张数据库表,并提供SQL查询功能。Hive1.2是支持Hadoop2.x的版本,它增强了查询性能和元数据管理。在安装Hive时,需要配置Hive服务器,连接到Hadoop集群,并设定好Hive Metastore,以便存储元数据。

4. ZooKeeper是另一个Apache项目,用于集群协调和服务发现,是Hadoop生态系统中的关键组件。ZooKeeper3.4.6在这里作为HBase和Hadoop的协调器,确保分布式环境中的数据一致性。安装ZooKeeper涉及到设置多个ZooKeeper节点,并配置集群间的通信。

在实际安装过程中,会涉及到以下步骤:

- 安装Java环境,因为所有这些组件都依赖Java运行。

- 创建系统用户,例如“wukong”,并分配权限。

- 下载并解压各组件的安装包。

- 配置环境变量,如`JAVA_HOME`, `HADOOP_HOME`, `HBASE_HOME`, `HIVE_HOME`等。

- 修改配置文件,如`hadoop-env.sh`, `core-site.xml`, `hdfs-site.xml`, `mapred-site.xml`, `yarn-site.xml`, `hbase-site.xml`, `hive-site.xml`等,以适应集群需求。

- 初始化HDFS和HBase,格式化NameNode和HBase的HMaster。

- 启动和停止服务,如`start-dfs.sh`, `start-yarn.sh`, `start-hbase.sh`等。

- 使用命令行工具进行测试,如`hadoop fs -ls`检查HDFS,`hbase shell`进行HBase操作,`hive`进入Hive交互式shell。

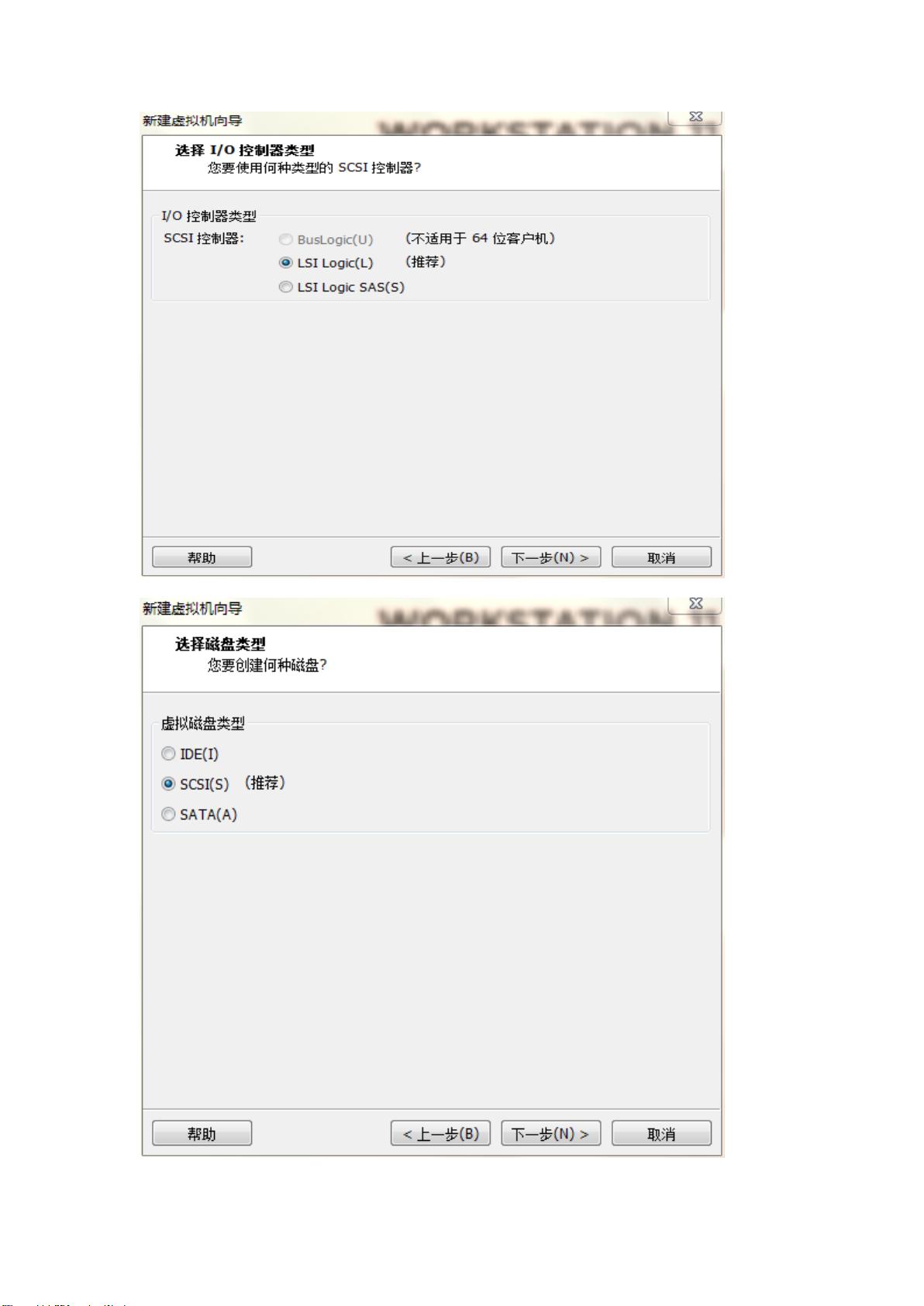

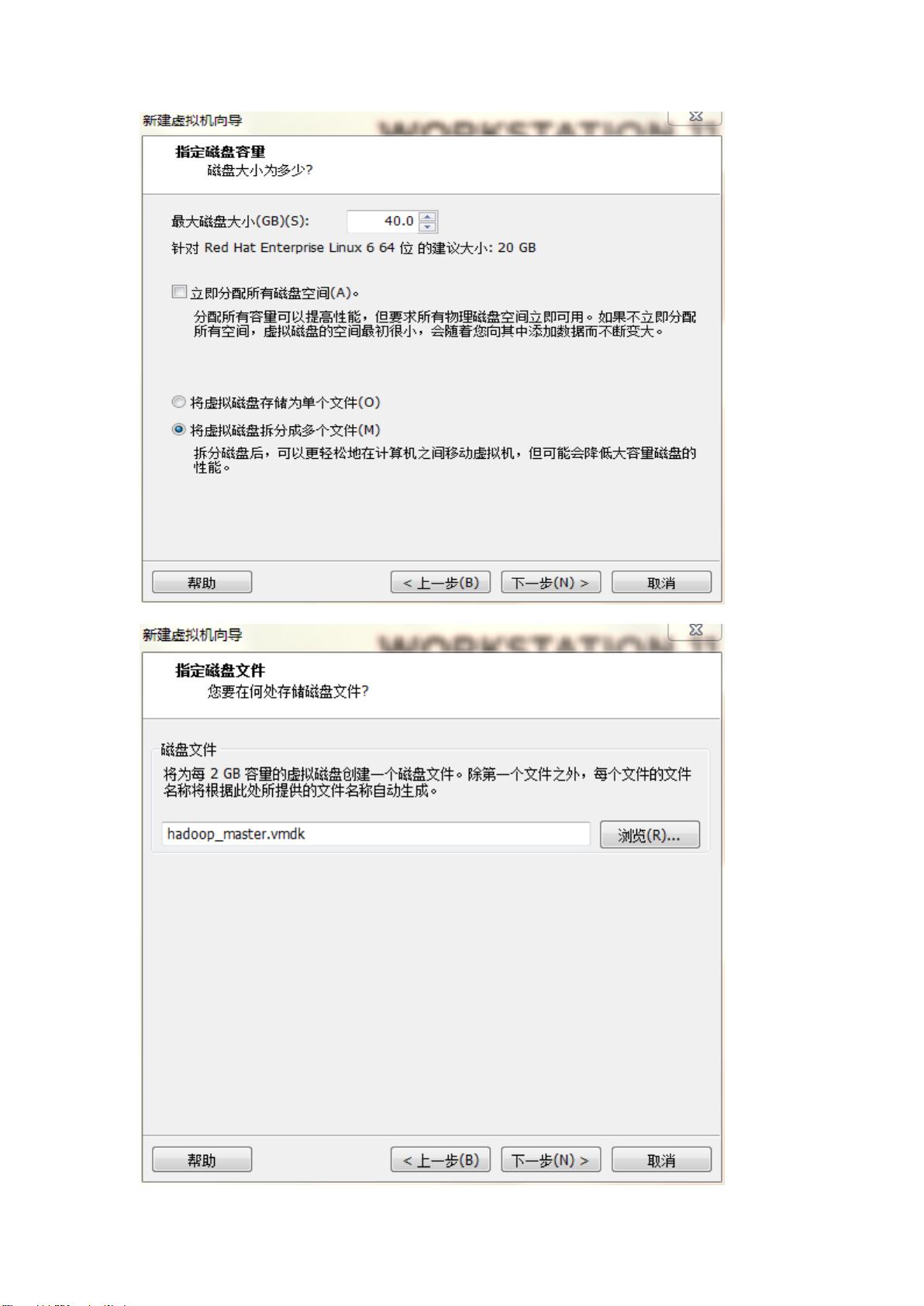

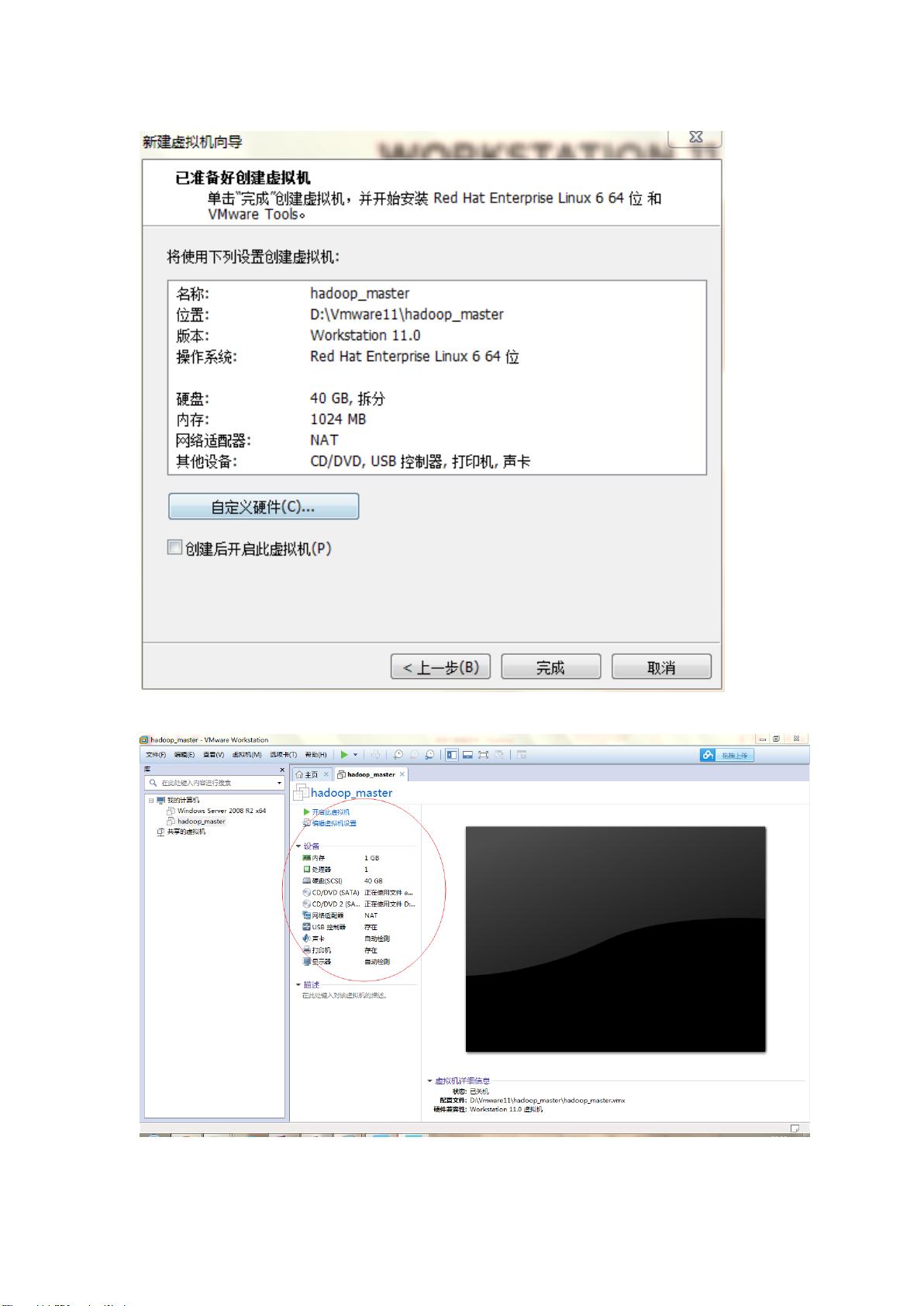

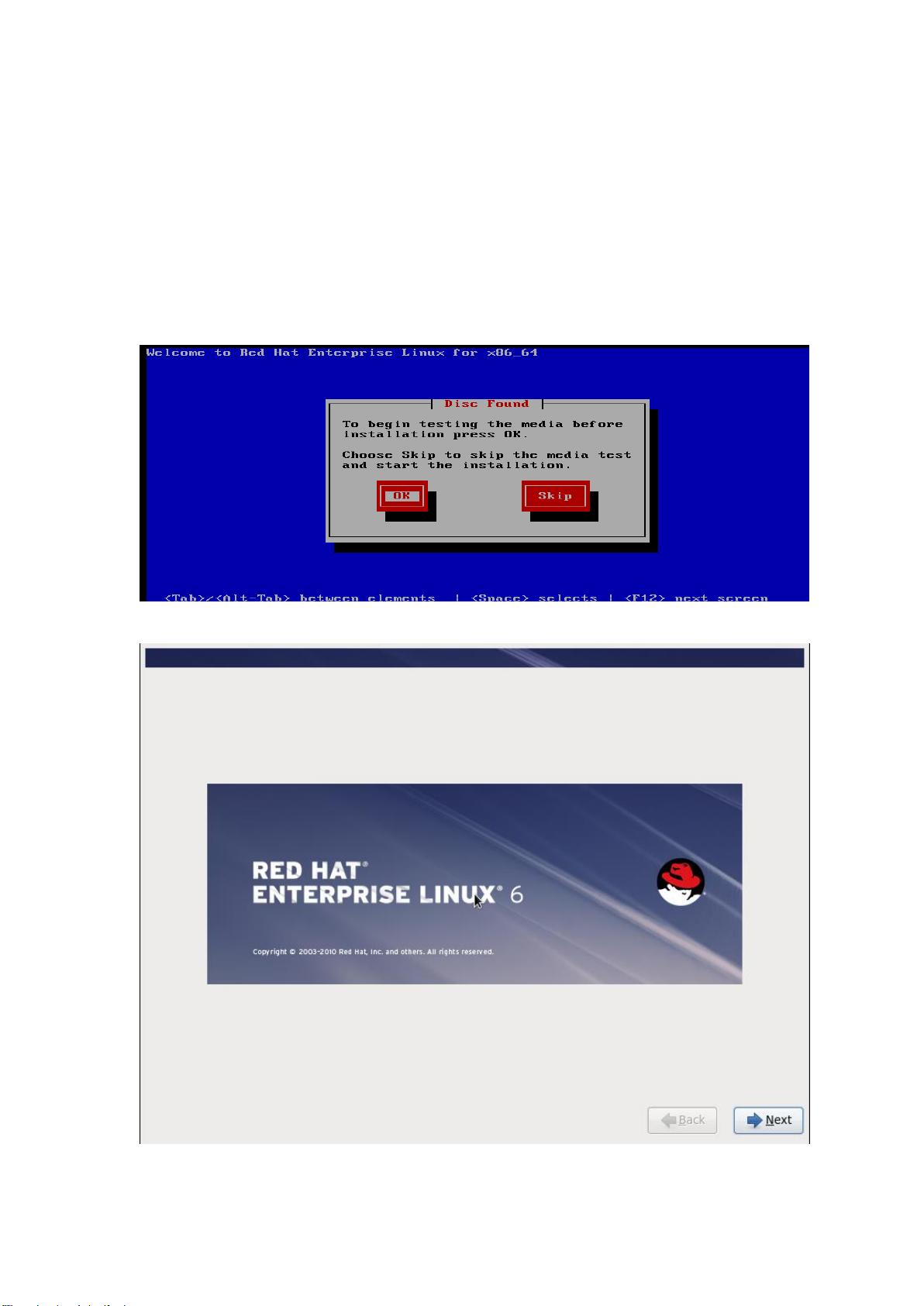

在虚拟机环境中,VMware可以方便地模拟多台机器,构建一个小型的Hadoop集群,便于学习和测试。这通常包括下载VMware,创建虚拟机,分配合适的硬件资源,安装操作系统,然后按照上述步骤安装和配置大数据组件。

这个文档为初学者提供了一条清晰的学习路径,涵盖了从基础命令到集群配置的所有关键环节,是掌握大数据技术栈的宝贵资料。

2018-07-16 上传

2015-08-16 上传

点击了解资源详情

2022-01-15 上传

2022-08-03 上传

2024-03-04 上传

2021-10-14 上传

kuge3390

- 粉丝: 5

- 资源: 11

最新资源

- Java集合ArrayList实现字符串管理及效果展示

- 实现2D3D相机拾取射线的关键技术

- LiveLy-公寓管理门户:创新体验与技术实现

- 易语言打造的快捷禁止程序运行小工具

- Microgateway核心:实现配置和插件的主端口转发

- 掌握Java基本操作:增删查改入门代码详解

- Apache Tomcat 7.0.109 Windows版下载指南

- Qt实现文件系统浏览器界面设计与功能开发

- ReactJS新手实验:搭建与运行教程

- 探索生成艺术:几个月创意Processing实验

- Django框架下Cisco IOx平台实战开发案例源码解析

- 在Linux环境下配置Java版VTK开发环境

- 29街网上城市公司网站系统v1.0:企业建站全面解决方案

- WordPress CMB2插件的Suggest字段类型使用教程

- TCP协议实现的Java桌面聊天客户端应用

- ANR-WatchDog: 检测Android应用无响应并报告异常