集成学习探析:从Bagging到Boosting,以GBDT为例

需积分: 0 185 浏览量

更新于2024-08-05

收藏 866KB PDF 举报

"本文介绍了机器学习中的集成学习方法,特别是关注于Bagging和Boosting类方法,包括随机森林和GBDT等。"

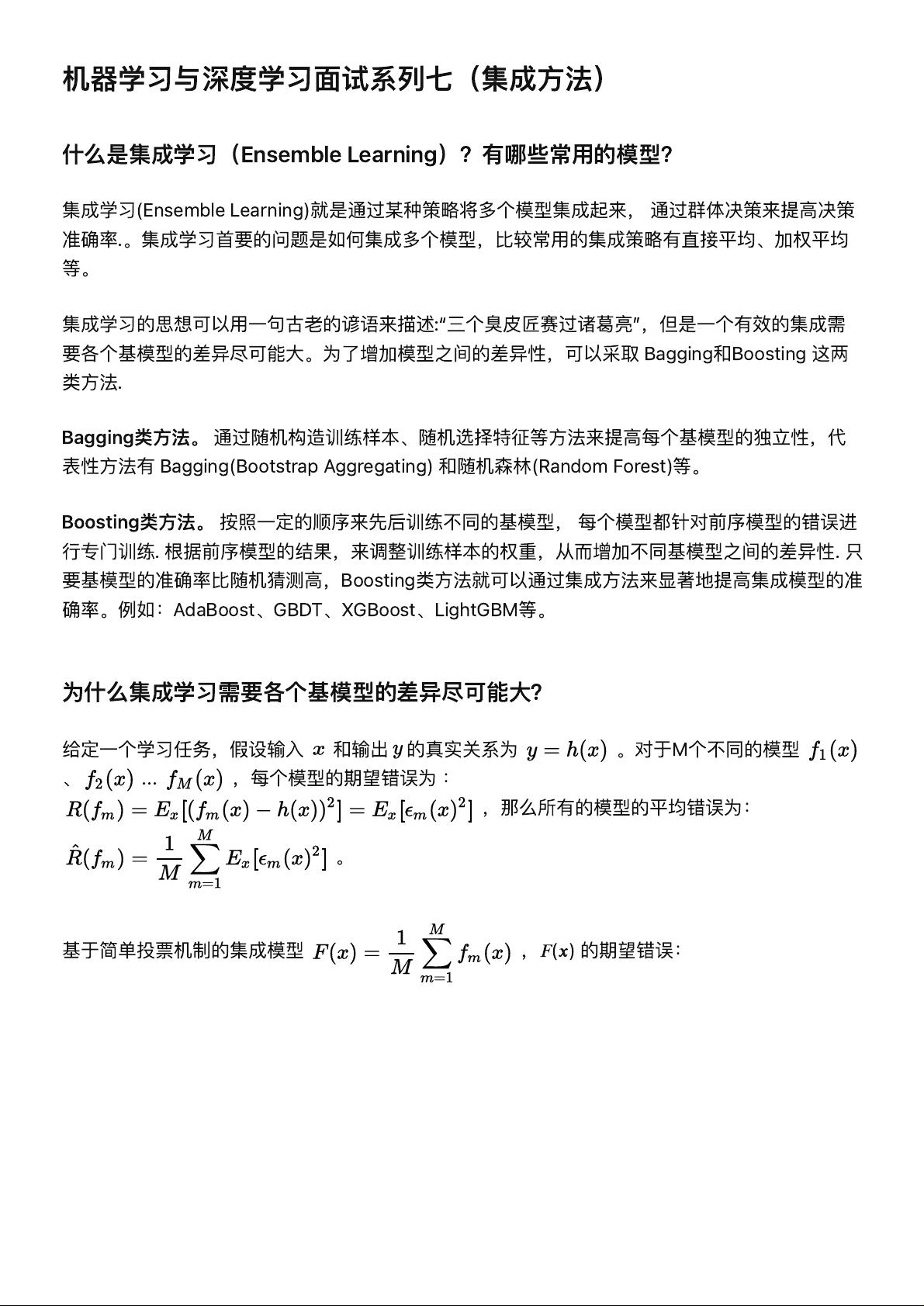

集成学习是机器学习领域的一种重要技术,它通过结合多个弱预测器来创建一个强预测器。这种策略的核心在于,通过多个模型的集合,能够减少过拟合,提高模型的稳定性和准确性。集成学习主要有两种策略:Bagging和Boosting。

Bagging(Bootstrap Aggregating)是一种并行化的集成方法,它通过从原始数据集中随机抽取有放回的子样本来构建不同的训练集,每个模型在这些子样本上独立训练。这种方法降低了模型之间的相关性,提高了多样性。比如,随机森林就是Bagging的一个实例,它利用决策树作为基模型,并且在构建每棵树时还会对特征进行随机选择,进一步增强模型的多样性。

另一方面,Boosting是一种序列化的集成方法,它依次训练模型,每个新模型都会重点处理前一个模型的错误。Gradient Boosting Decision Tree (GBDT)是Boosting方法的一个例子,它通过最小化残差来迭代地构建决策树,每次迭代都针对前一棵树的残差进行优化。这样,每个新树都能专注于纠正之前模型的错误,从而逐步提升整体预测性能。XGBoost和LightGBM是GBDT的高效实现,它们在保持高准确率的同时,显著提升了训练速度。

集成学习中,基模型的差异性至关重要,因为只有当各个模型的预测结果不完全一致时,集成模型才能从它们的多样性中受益。如果所有基模型都给出相同的结果,那么集成将无法提供额外的优势。数学上,模型之间的不相关性会导致集成模型的期望错误减少,这意味着在理想情况下,当模型间的误差不相关时,集成模型的性能可以接近最优。

在实际应用中,集成学习广泛用于各种任务,尤其是在Kaggle等数据科学竞赛中,GBDT因其优秀的泛化能力和计算效率而备受青睐。通过理解和有效地应用集成学习,开发者可以构建出更强大、更鲁棒的机器学习系统,以应对复杂和多样化的预测挑战。

2023-07-14 上传

2019-08-10 上传

2022-08-03 上传

2024-11-20 上传

2018-09-26 上传

2019-03-08 上传

2021-02-04 上传

2022-08-04 上传

2018-07-27 上传

不知者无胃口

- 粉丝: 32

- 资源: 328

最新资源

- CoreOS部署神器:configdrive_creator脚本详解

- 探索CCR-Studio.github.io: JavaScript的前沿实践平台

- RapidMatter:Web企业架构设计即服务应用平台

- 电影数据整合:ETL过程与数据库加载实现

- R语言文本分析工作坊资源库详细介绍

- QML小程序实现风车旋转动画教程

- Magento小部件字段验证扩展功能实现

- Flutter入门项目:my_stock应用程序开发指南

- React项目引导:快速构建、测试与部署

- 利用物联网智能技术提升设备安全

- 软件工程师校招笔试题-编程面试大学完整学习计划

- Node.js跨平台JavaScript运行时环境介绍

- 使用护照js和Google Outh的身份验证器教程

- PHP基础教程:掌握PHP编程语言

- Wheel:Vim/Neovim高效缓冲区管理与导航插件

- 在英特尔NUC5i5RYK上安装并优化Kodi运行环境