"深入理解Spark on Yarn的启动流程与源码编译"

需积分: 11 132 浏览量

更新于2024-01-31

收藏 2.49MB DOCX 举报

Spark的初始化源码阅读主要涉及到SparkOnYARN中的client和cluster区别以及编译源码包和启动流程。首先,要进行Spark初始化源码阅读,需要下载Spark源码并在Linux系统上进行编译。在编译之前,需要安装JDK(1.8)和Maven3.3.9,然后解压源码包并调整Maven编译时的内存大小。接下来,执行编译普通包命令和编译可执行的安装包命令,以便开始Spark的初始化。

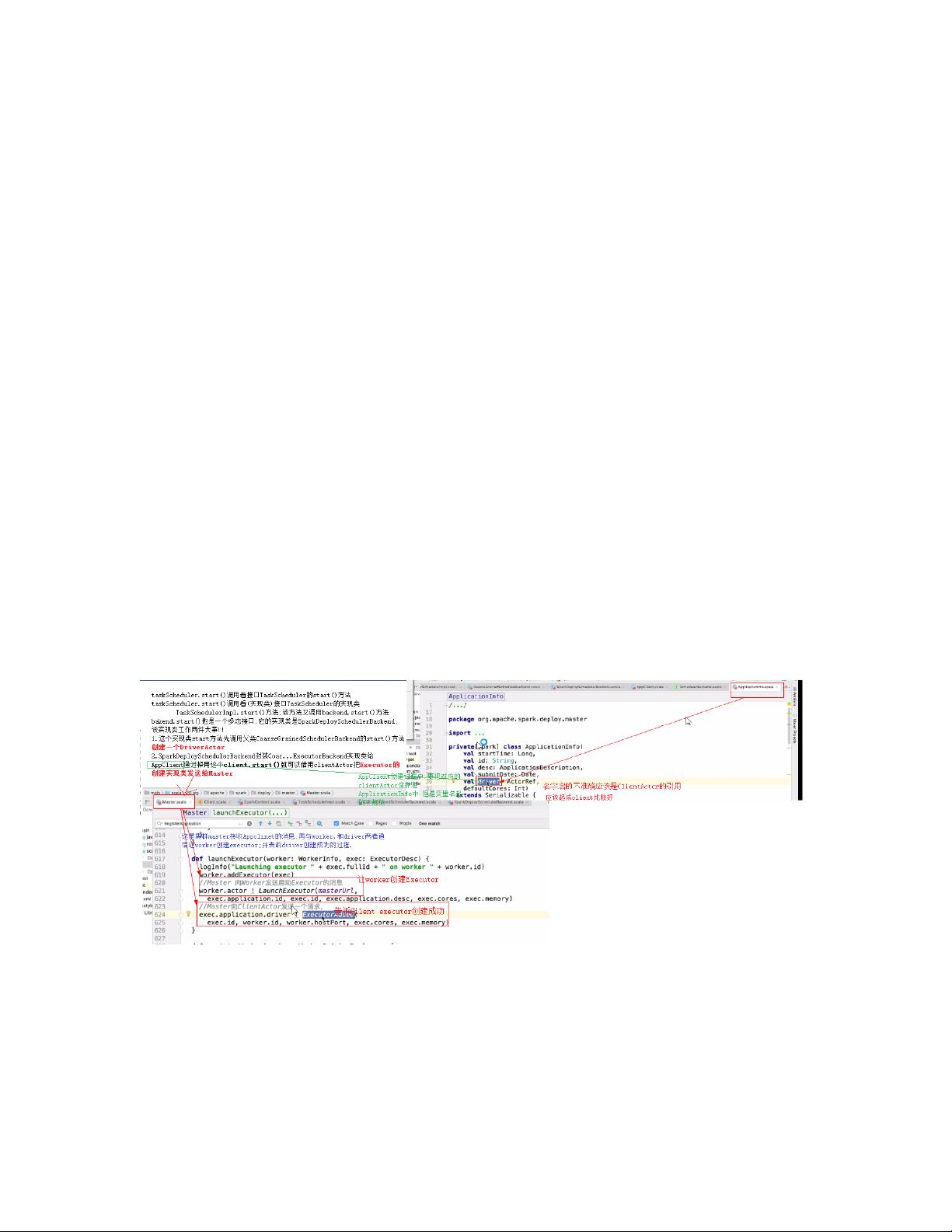

在编译完成后,可以进行Spark的启动流程。启动流程包括使用sbin/start-all.sh命令来启动Spark并调用start-master.sh和start-slaves.sh来启动master节点和slaves节点。start-master.sh之后会调用spark-daemon.sh来启动org.apache.spark.deploy.master.Master。这一系列的操作是为了确保Spark的启动流程能够顺利进行并且各个节点能够正常工作。

此外,在进行Spark初始化源码阅读的过程中,需要注意SparkOnYARN中的client和cluster区别。在SparkOnYARN中,client模式是指客户端模式,这种模式下驱动程序运行在客户端机器上,而不是集群中。而cluster模式是指集群模式,这种模式下驱动程序运行在集群中。理解client和cluster区别对于源码的阅读和理解非常重要,因为不同的模式下Spark的工作机制和流程会有所不同。因此,在源码阅读过程中要特别关注这两种模式下的区别和影响。

在总结上述内容时,需要注意到编译源码包和启动流程是Spark初始化的关键步骤,而理解client和cluster区别是源码阅读的重点。通过深入分析源码,可以更好地理解Spark的工作原理和内部机制,从而为应用开发和调优提供参考和帮助。因此,在进行Spark初始化源码阅读时,需要着重关注这些内容,并通过实际操作和调试来加深理解和掌握。

1042 浏览量

142 浏览量

713 浏览量

153 浏览量

136 浏览量

222 浏览量

156 浏览量

153 浏览量

155 浏览量

Sahag321

- 粉丝: 34

- 资源: 4

最新资源

- 行业分类-设备装置-一种接布机.zip

- pop-punk.vim::guitar: vim 的深色、高对比度配色方案

- 基于Java Web 技术的网上订餐系统.zip

- avsdpll_1v8_sky130_ss

- 草地lar

- random-int:产生一个随机整数

- 利用Python实现三层BP神经网络.zip

- ajax_app

- ctcsound:使用 ctypes 的 Csound 的 Python 绑定。 也可以从 python2.x 和 python3.x 使用

- 行业分类-设备装置-一种接地箱门锁.zip

- 可调叶片离心泵的实际应用.rar

- 学生信息管理系统(含Java源代码) 毕业论文

- gnome-email-notifications:侏儒电子邮件通知

- ORACLE清理工具

- 真棒测试用例集合:此存储库包含初学者的测试用例集合,在验证不同领域的项目时需要包括这些测试用例

- coreos-kubernetes:用于在 CoreOS 上安装和运行 Kubernetes 的 Cloud init 和 Fleet 文件