Python入门:字典类型与jieba库详解

45 浏览量

更新于2024-08-29

收藏 429KB PDF 举报

本资源是关于Python编程的入门教程,主要讲解了字典类型和jieba库的使用。在第8天的学习中,太原理工大学机器人团队深入探讨了字典作为映射数据结构的特点和应用场景,并介绍了jieba库进行中文分词的三种模式。

**字典类型详解**

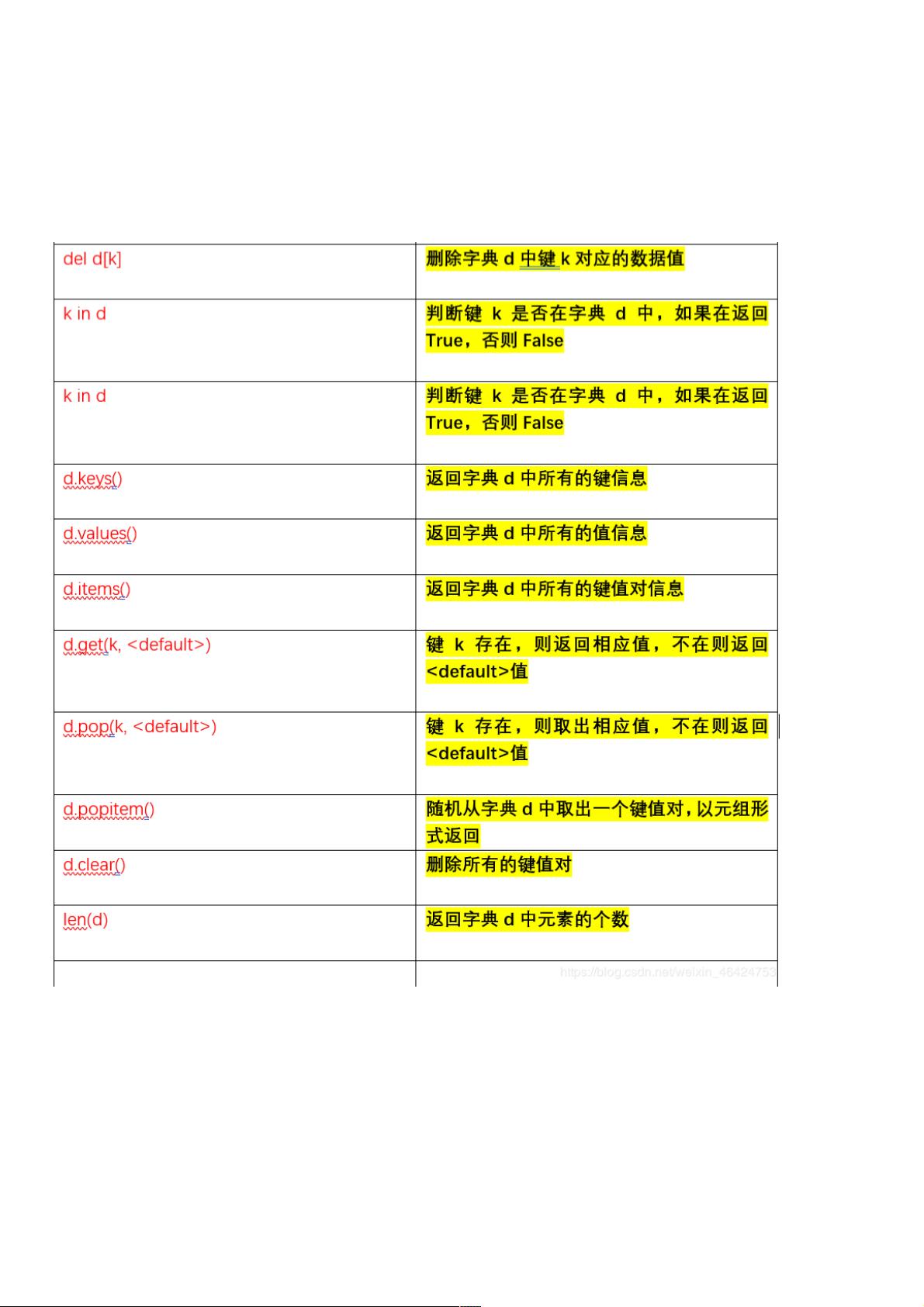

字典是Python中的一个核心数据结构,它是一种映射类型的容器,用来存储键值对。键在字典中起着索引的作用,而值则是与之关联的数据。字典的特点如下:

1. **键值对**: 字典由一系列键值对组成,每个键唯一对应一个值。

2. **无序性**: 字典中的键值对没有固定的顺序,不能像列表那样通过索引位置访问。

3. **创建方式**: 可以使用大括号{}或者内置的`dict()`函数创建字典。例如:

```python

a = {"name": "太原理工大学", "address": "山西太原"}

```

4. **访问方式**: 通过键来获取对应的值,如`a["name"]`将返回"太原理工大学"。

5. **字符类型操作**: 字典的键通常为不可变类型,如字符串、数字或元组;值可以是任意Python对象。

**字典的应用场景**

字典在数据处理中非常常见,例如:

- 统计分析:键代表数据,值表示该数据出现的次数。

- 配置文件:键是配置项名称,值是配置的值。

- 缓存管理:键为缓存的标识,值为缓存的内容。

**jieba库介绍**

jieba是一个强大的Python库,用于中文文本的分词处理。它可以将一段中文文本切割成有意义的词汇,这对于自然语言处理和文本分析至关重要。jieba提供了三种分词模式:

1. **精确模式** (`jieba.lcut(s)`):尽可能精确地将句子切分成词语,较少的分词错误。

2. **全模式** (`jieba.lcut(s, cut_all=True)`):将句子中所有可能的词语都扫描出来,可能会包含冗余的词汇。

3. **搜索引擎模式** (`jieba.lcut_for_search(s)`):在精确模式的基础上,对较长的词进行再次切分,以提高召回率,适合搜索引擎构建。

**jieba库的安装**

jieba是Python的第三方库,可以通过pip命令进行安装。如果pip版本过低,可以先升级pip,然后安装jieba:

```bash

pip install --upgrade pip

pip install jieba

```

**示例代码**

以下代码演示了使用jieba库进行分词并统计词频的简单过程:

```python

import jieba

with open("threekingdoms.txt", "r", encoding='utf-8') as f:

txt = f.read()

words = jieba.lcut(txt)

counts = {}

for word in words:

if len(word) == 1:

continue

else:

counts[word] = counts.get(word, 0) + 1

items = list(counts.items())

items.sort(key=lambda x: x[1], reverse=True)

for i in range(15):

word, count = items[i]

print(f"{word:5} {count}")

```

这段代码首先使用jieba库对文本进行分词,然后统计每个词的出现次数,并按词频降序排列,输出前15个最常出现的词及其频率。

通过以上的学习,你已经掌握了Python中的字典类型以及jieba库的基本使用,这将有助于你进行更复杂的文本处理和数据分析任务。

181 浏览量

130 浏览量

141 浏览量

158 浏览量

152 浏览量

348 浏览量

219 浏览量

207 浏览量

2025-01-05 上传

weixin_38731123

- 粉丝: 3

最新资源

- 免安装滚动截屏录屏软件

- Swagger转TypeScript客户端及模型生成器

- Weather-Dashboard: 探索与定制天气预报界面

- 探索Filter Solutions:强大滤波器设计工具

- FANUC机器人系统8.30P版本安装包介绍

- Sushi Chef脚本:母鹅俱乐部内容导入解决方案

- 闻道抠图软件v1.0:免费中文绿色电脑抠图工具

- 绿色汉化版Notepad++下载:亲测可用

- 软件IIC读取L3G4200D陀螺仪值的STM32F103应用

- CPP问题解决方案仓库

- 备考二级C语言的最佳模拟系统

- 基于ThinkPHP的货运公司网站源码-快递与物流配送服务

- 林巧山开发的批量分离分析脚本使用指南

- 超分辨率训练的通用数据集 - General-100

- Gitpod学生模板指南 - 前后端运行教程

- 微软图表控件示例环境:Web与Winform实例解析