"卷积神经网络综述:历史发展与核心模型"

需积分: 0 127 浏览量

更新于2024-01-03

收藏 1.95MB DOCX 举报

本文综合讨论了CNN(卷积神经网络)的一些主要概念和发展历史。首先,作者提到了卷积核大小采用1、3和5的原因,主要是为了方便对齐。这是因为不同大小的卷积核可以用来捕捉不同尺度的特征,而为了能够在不同大小的特征图上进行操作,选择这些不同大小的卷积核是十分必要的。

其次,文章提到了pooling的有效性,因此在Inception模型中也嵌入了pooling。Pooling操作可以有效减少待处理的特征数,从而降低计算负担。这一设计使得Inception模型在处理大规模图像数据时表现出色。

在接下来的内容中,作者列举了几个著名CNN模型的发展历史。其中,Lenet是1986年的一款CNN模型,它由两个卷积层、两个池化层和两个全连接层组成。这个模型的设计为后来的CNN模型提供了很好的借鉴。

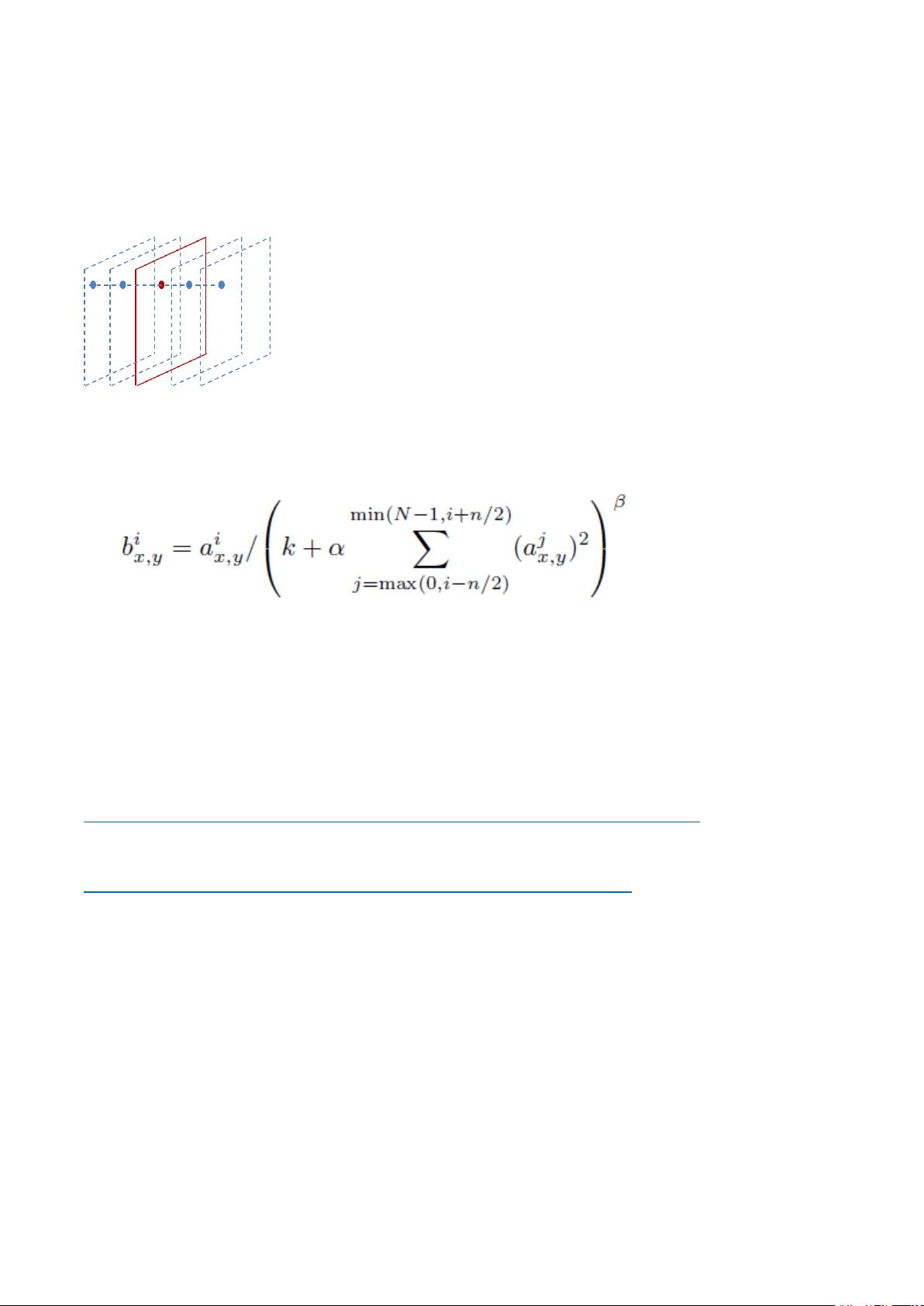

接着,作者提到了2012年的Alexnet模型,这个模型在当年的Imagenet比赛中获得了冠军。该模型的意义在于证明了CNN在复杂模型下的有效性,并且GPU的实现使得其在可接受的时间范围内能够训练得到结果。这一成就不仅推动了CNN和GPU的发展,也推动了有监督深度学习的发展。

紧接着便是2014年的GoogleNet和VGG等模型,它们进一步拓展了CNN的深度和广度,提高了网络的性能。

在2015年,深度残差学习(Deep Residual Learning)开始流行起来。这种结构允许网络学习残差,从而大大提升了网络的学习效率和性能。

随后,ResNeXt模型出现在2016年,它在网络结构上作出了创新,并且在ImageNet比赛中取得了优异的成绩。

最后,作者提到了2017年的DenseNet模型以及ImageNet的历年冠军和相关CNN模型。这些模型在设计上均体现了对网络结构的创新和优化,从而取得了较好的性能。

综上所述,本文回顾了CNN模型的一些发展历史和一些主要概念。这对于理解CNN的发展脉络和优化方向有很大的帮助。同时,本文也展望了CNN模型的未来发展方向,为相关研究提供了一些借鉴和启发。

2022-08-03 上传

157 浏览量

2021-04-22 上传

2018-05-25 上传

132 浏览量

2013-12-02 上传

英次

- 粉丝: 22

最新资源

- ITween插件实用教程:路径运动与应用案例

- React三纤维动态渐变背景应用程序开发指南

- 使用Office组件实现WinForm下Word文档合并功能

- RS232串口驱动:Z-TEK转接头兼容性验证

- 昆仑通态MCGS西门子CP443-1以太网驱动详解

- 同步流密码实验研究报告与实现分析

- Android高级应用开发教程与实践案例解析

- 深入解读ISO-26262汽车电子功能安全国标版

- Udemy Rails课程实践:开发财务跟踪器应用

- BIG-IP LTM配置详解及虚拟服务器管理手册

- BB FlashBack Pro 2.7.6软件深度体验分享

- Java版Google Map Api调用样例程序演示

- 探索设计工具与材料弹性特性:模量与泊松比

- JAGS-PHP:一款PHP实现的Gemini协议服务器

- 自定义线性布局WidgetDemo简易教程

- 奥迪A5双门轿跑SolidWorks模型下载