数据质量决定模型成败:揭示ML模型对垃圾输入的敏感性

版权申诉

37 浏览量

更新于2024-06-21

收藏 1.91MB PDF 举报

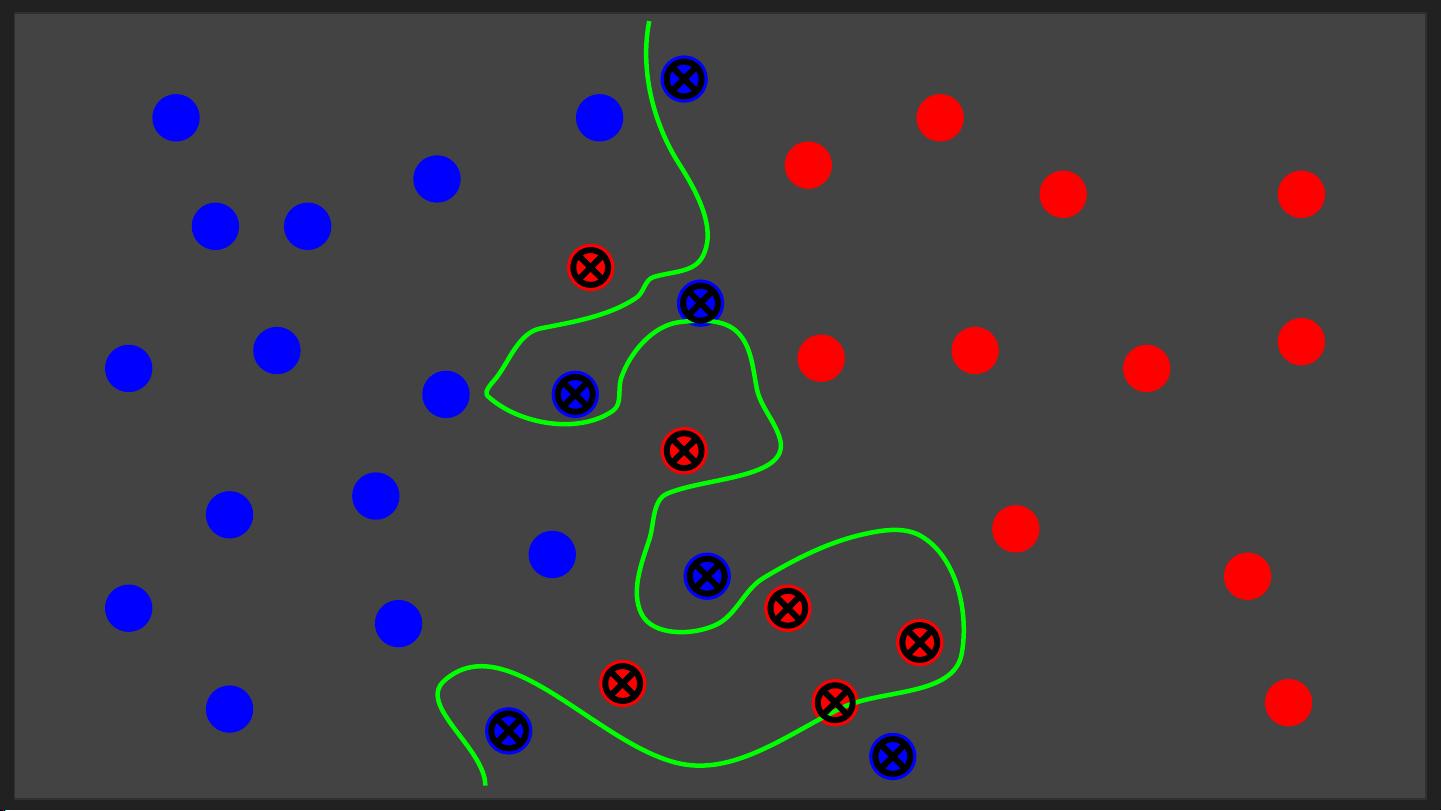

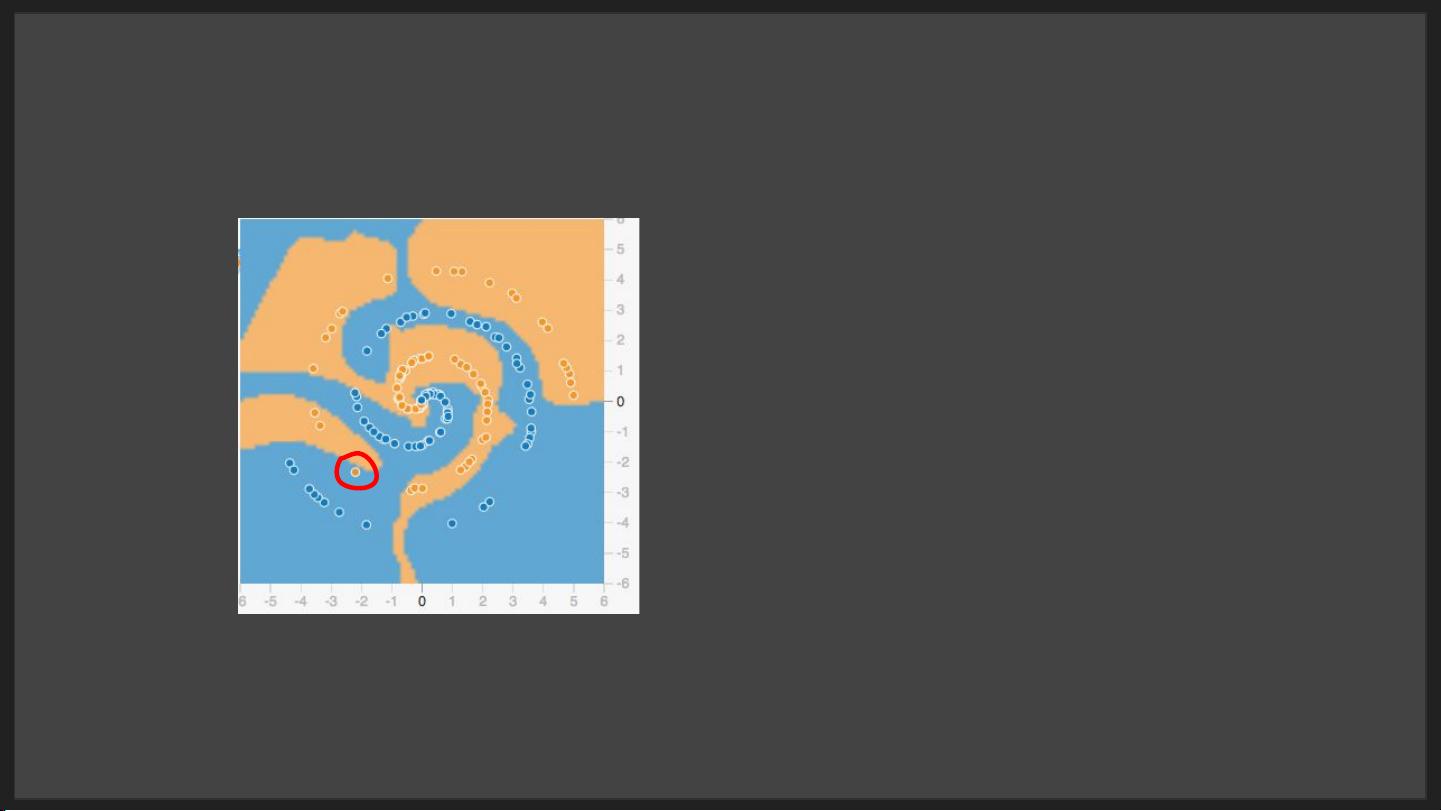

在《藏经阁-Garbage In, Garbage Out》这份文档中,作者探讨了机器学习(Machine Learning)模型在处理数据质量不佳时可能出现的问题,特别是安全领域中人工智能(AI)研究人员所宣称的模型准确性可能存在的误导性。文档以"Garbage In, Garbage Out"为标题,强调了数据质量对模型性能的决定性影响。

首先,文档指出,许多声称具有高准确性的机器学习模型其实可能受到偏见的影响,这种偏见通常是过于乐观的估计。例如,当研究人员评估安全相关的模型时,他们可能会过度夸大模型在识别恶意网站或钓鱼链接上的表现,如:

- 通过输入"http://www.trustus.evil.ru/paypal/login/",模型输出了令人瞩目的0.944780,这可能给人一种高度准确的印象。

- 而对于像"https://www.facebook.com/"这样的合法网站,模型却给出了较低的0.019367,显示出在区分正负样本时可能存在显著误差。

其次,文档通过训练数据示例展示了问题的关键。在监督学习的场景下,模型被"fit"到特定的数据集上,如包含恶意链接("http://www..evil.ru/paypal/login/", "http://gsbynr.ru/start_page.exe")和非恶意链接("https://www.facebook.com/", "http://imgur.com/r/cats/omgn4Zv")。然而,这些训练数据的质量直接影响模型的泛化能力,如果训练数据本身就存在偏差,那么模型学到的可能是错误的关联,导致在实际应用中的表现大打折扣。

因此,文档强调了评估数据质量、识别并纠正潜在偏见的重要性。模型的准确性不能仅仅依赖于理论上的数值,而是必须结合实际测试数据和对数据集真实性的深入理解。正确的方法是通过细致的测试和验证,确保模型在处理不同类型和质量的数据时都能提供可靠的结果,防止"Garbage In"导致"Garbage Out",即输入垃圾数据得到错误的输出。这对于任何从事数据科学和机器学习的团队,尤其是那些负责模型部署和运营的团队来说,都是至关重要的指导原则。

2022-09-21 上传

2024-10-20 上传

2020-08-22 上传

2019-05-28 上传

2022-09-20 上传

2023-08-31 上传

2020-05-12 上传

2023-07-19 上传

weixin_40191861_zj

- 粉丝: 84

- 资源: 1万+

最新资源

- 深入浅出:自定义 Grunt 任务的实践指南

- 网络物理突变工具的多点路径规划实现与分析

- multifeed: 实现多作者间的超核心共享与同步技术

- C++商品交易系统实习项目详细要求

- macOS系统Python模块whl包安装教程

- 掌握fullstackJS:构建React框架与快速开发应用

- React-Purify: 实现React组件纯净方法的工具介绍

- deck.js:构建现代HTML演示的JavaScript库

- nunn:现代C++17实现的机器学习库开源项目

- Python安装包 Acquisition-4.12-cp35-cp35m-win_amd64.whl.zip 使用说明

- Amaranthus-tuberculatus基因组分析脚本集

- Ubuntu 12.04下Realtek RTL8821AE驱动的向后移植指南

- 掌握Jest环境下的最新jsdom功能

- CAGI Toolkit:开源Asterisk PBX的AGI应用开发

- MyDropDemo: 体验QGraphicsView的拖放功能

- 远程FPGA平台上的Quartus II17.1 LCD色块闪烁现象解析