TensorFlow2.0实战:深度可分离卷积神经网络解析与实现

77 浏览量

更新于2024-08-29

4

收藏 1012KB PDF 举报

"TensorFlow2.0深度可分离卷积神经网络的实现与比较"

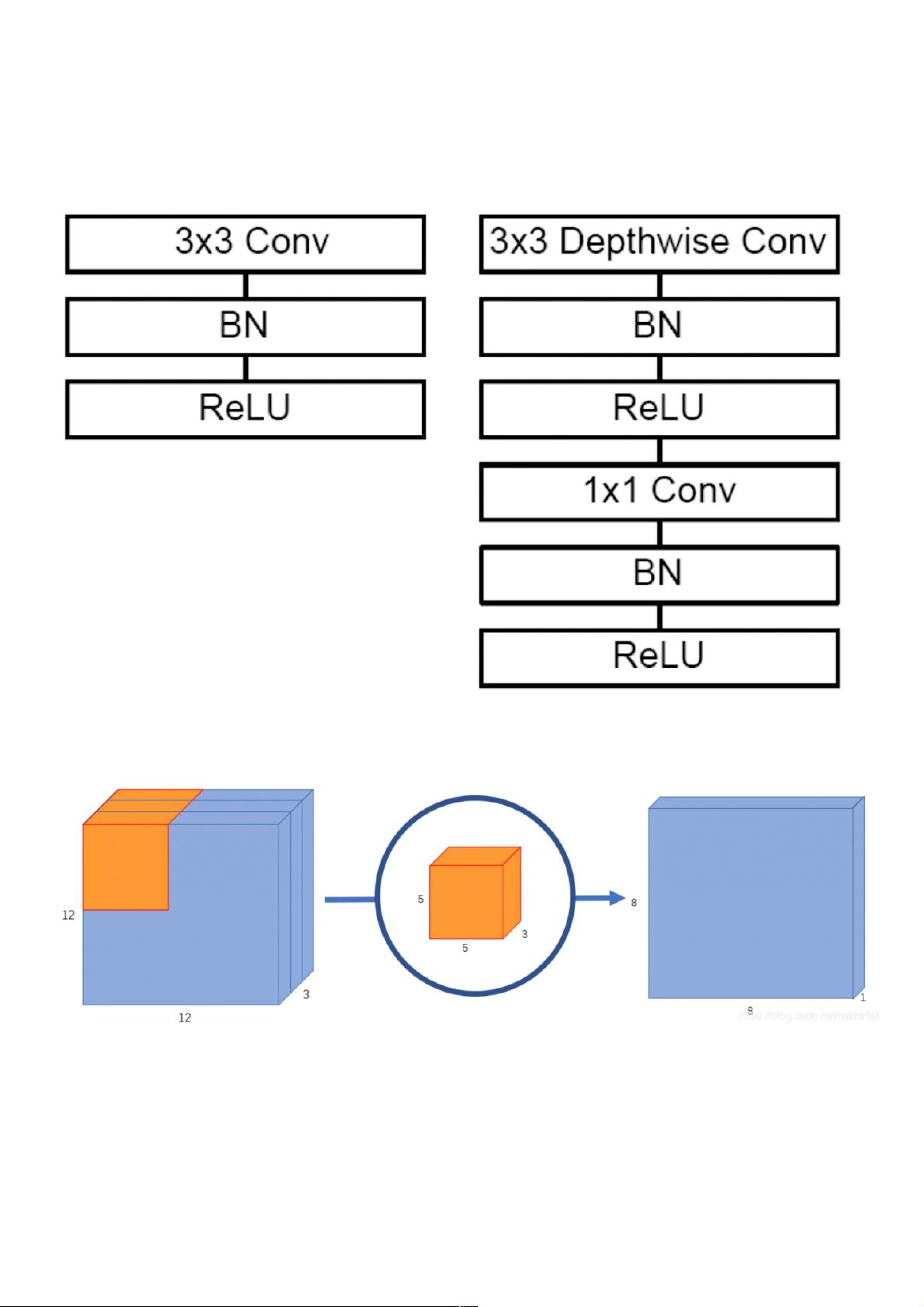

深度可分离卷积神经网络(Depthwise Separable Convolution)是一种在卷积神经网络(CNN)中减少计算复杂度和参数数量的技术。在普通卷积网络中,每个卷积核会跨过所有输入通道进行卷积,这导致了大量的计算。而深度可分离卷积网络将这一过程分解为两个步骤:深度卷积(Depthwise Convolution)和逐点卷积(Pointwise Convolution)。

1.1 深度可分离卷积网络与普通卷积网络的区别

深度卷积首先对每个输入通道独立应用卷积核,这样每个输入通道的特征被单独处理,减少了计算量。接着,逐点卷积通过1×1卷积层来融合这些通道的特征,生成最终的输出通道。这种分解方法大大减少了参数数量和计算成本,尤其在需要大量输出通道时效果显著。

1.2 计算量对比

普通卷积的计算量公式为:$O(D_k^2 \times M \times N)$,其中$D_k$是卷积核的边长,$M$是输入通道数,$N$是输出通道数。相比之下,深度可分离卷积的计算量为:$O(D_k^2 \times M + M \times N)$,前一部分是深度卷积的计算量,后一部分是逐点卷积的计算量。通常情况下,深度可分离卷积的计算量远小于普通卷积。

2. 实现深度可分离卷积网络的步骤

在TensorFlow2.0中实现深度可分离卷积网络包括以下步骤:

2.1 导入必要的库,如TensorFlow、Keras等。

2.2 加载并预处理数据集,例如MNIST、CIFAR-10或ImageNet。

2.3 构建模型结构,包括深度可分离卷积层,可能还包含池化层、全连接层等其他组件。

2.4 编译模型,设置损失函数、优化器和评估指标。

2.5 训练模型,通过迭代更新权重以最小化损失函数。

2.6 评估模型性能,绘制学习曲线,并在验证集上验证模型的泛化能力。

3. 应用场景

深度可分离卷积在网络轻量化和移动设备上的应用尤为突出,如MobileNet系列模型。它们在保持模型性能的同时,显著减少了内存占用和计算需求,使得深度学习模型能在资源有限的环境中运行。

总结,深度可分离卷积神经网络是一种有效的优化策略,通过分解普通卷积为两个独立的步骤,既保留了特征提取的能力,又降低了计算复杂度,使得深度学习模型更适用于资源受限的环境。在TensorFlow2.0中,我们可以轻松实现这样的网络,从而在实际项目中获得更好的效率和性能。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2020-12-20 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

2024-04-03 上传

weixin_38612095

- 粉丝: 10

- 资源: 921

最新资源

- Elasticsearch核心改进:实现Translog与索引线程分离

- 分享个人Vim与Git配置文件管理经验

- 文本动画新体验:textillate插件功能介绍

- Python图像处理库Pillow 2.5.2版本发布

- DeepClassifier:简化文本分类任务的深度学习库

- Java领域恩舒技术深度解析

- 渲染jquery-mentions的markdown-it-jquery-mention插件

- CompbuildREDUX:探索Minecraft的现实主义纹理包

- Nest框架的入门教程与部署指南

- Slack黑暗主题脚本教程:简易安装指南

- JavaScript开发进阶:探索develop-it-master项目

- SafeStbImageSharp:提升安全性与代码重构的图像处理库

- Python图像处理库Pillow 2.5.0版本发布

- mytest仓库功能测试与HTML实践

- MATLAB与Python对比分析——cw-09-jareod源代码探究

- KeyGenerator工具:自动化部署节点密钥生成