Spark开发环境搭建教程与单机部署

需积分: 48 133 浏览量

更新于2024-07-20

收藏 1.59MB PDF 举报

Spark开发环境搭建指南

在这个PDF文档中,作者提供了详细的步骤来帮助读者在Windows和Ubuntu操作系统上设置Spark开发环境。Spark是一种强大的大数据处理框架,特别适合实时数据处理和机器学习任务。以下是文档中的关键知识点:

1. **系统需求**:

- 支持平台:文档推荐使用Ubuntu操作系统,因为其与Spark有更好的兼容性,尽管Windows理论上也可运行,但未在文档中进行详细测试。

- Java Development Kit (JDK): 使用Oracle官方提供的Java 8版本(如jdk1.8.0_25),因为Spark支持Java 8及以上版本。

- Scala: 推荐使用Scala 2.10.4,因为它与Spark 1.3.1版本相匹配。

- Apache Spark: 下载1.3.1版本的Spark,并与Hadoop 2.6一起使用,可以从Apache官方网站获取。

2. **软件安装**:

- JDK:访问Oracle官网下载对应版本,根据文档示例,将JDK安装到指定目录`/home/dev/Downloads`。

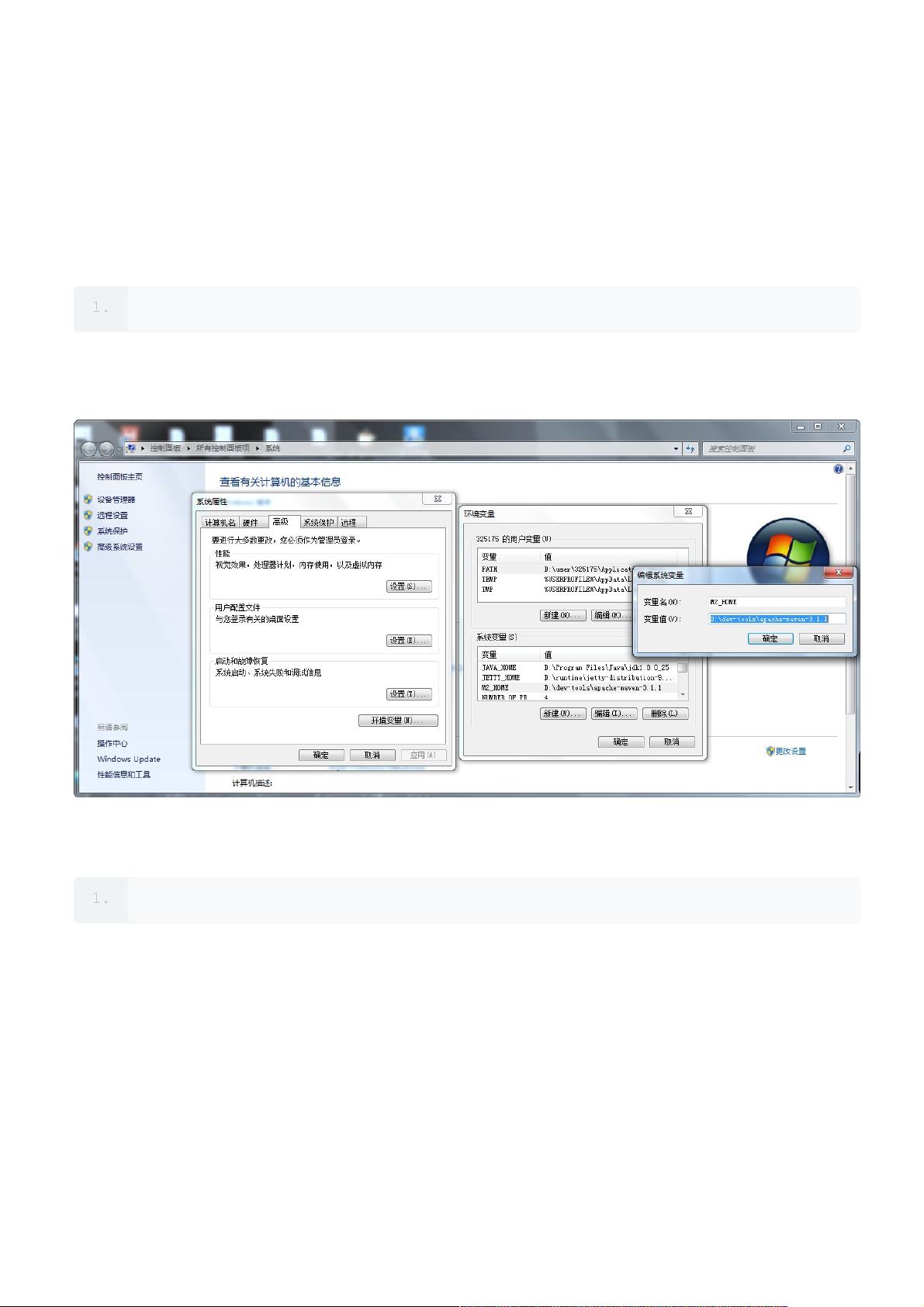

- Scala:在`/devtools`目录下创建scala子目录,解压scala-2.10.4.tgz文件,然后配置环境变量`SCALA_HOME`。

3. **IDE选择**:

- 构建工具:推荐使用Apache Maven 3.1.1,用于管理和构建Spark项目。

- 开发工具:推荐使用ScalaIDE或IntelliJ IDEA 14.15,作为Scala编程的集成开发环境(IDE)。

4. **Spark单机环境搭建**:

- 首先,确保所有软件已下载。然后,按照文档提供的步骤安装和配置,包括编辑`/etc/profile`文件来添加Scala路径,确保系统可以在命令行中正确识别Scala和Spark。

5. **实践环节**:

- 文档介绍了WordCount示例,这是一个Spark入门级别的任务,用于演示如何编写、测试、打包和发布Spark程序。通过这个实践,读者可以理解Spark的基本工作原理和开发流程。

这份文档旨在帮助新手快速上手Spark开发,通过一步步的指导,无论是安装过程还是实际操作,都为读者提供了一个清晰且实用的参考。完成这些步骤后,用户就能在本地搭建起一个基本的Spark开发环境,开始编写和运行自己的Spark应用程序了。

170 浏览量

点击了解资源详情

点击了解资源详情

223 浏览量

2017-10-17 上传

142 浏览量

116 浏览量

283 浏览量

2024-04-13 上传