万亿数据规模下,腾讯藏经阁的Group By性能揭秘

需积分: 0 65 浏览量

更新于2024-06-21

收藏 1.64MB PDF 举报

在"藏经阁-对2000多亿条数据做一次 Group By 需要多久?.pdf"这篇文档中,作者易杰,作为腾讯社交广告引擎研发团队的一员,深入探讨了如何高效处理大规模数据的Group By操作,特别是在面对2000亿条数据的情况下。文章主要分为以下几个部分:

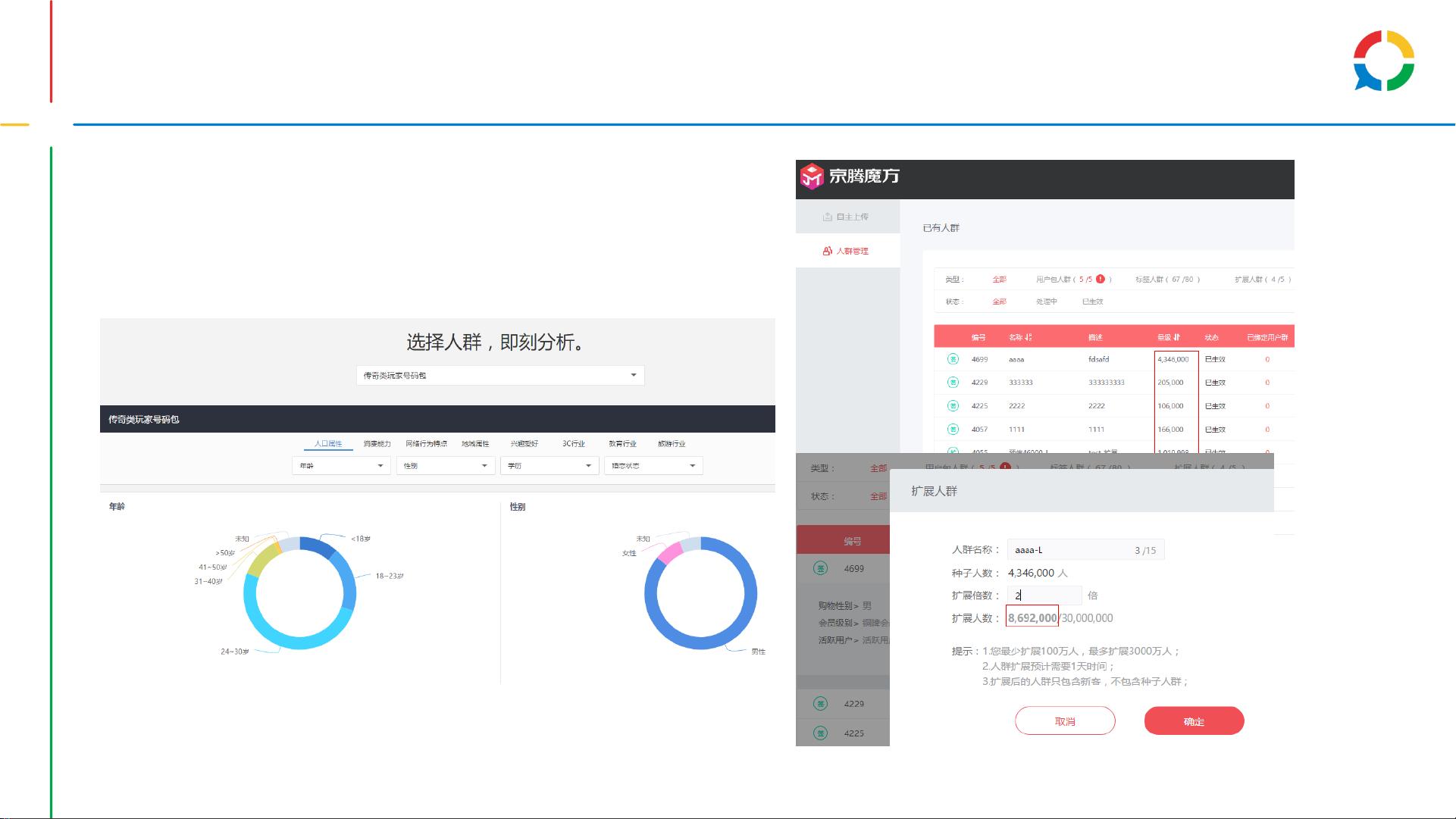

1. **业务背景**:文档首先介绍了腾讯社交广告的业务场景,涉及到8亿多优质用户,需要进行多维数据分析,包括人群管理、用户画像分析、定向人群预估以及广告效果诊断,这些都依赖于精确的Group By操作来实现。

2. **系统架构**:系统设计的核心是处理高性能和大规模数据,采用全量与增量数据相结合的方式,通过索引分片和多级聚合技术来优化查询效率。同时,标准SQL接口使得使用更为简便,强调快速响应的重要性。

3. **核心实现**:文档详细讲解了如何通过索引控制数据膨胀,使用SSD磁盘降低内存消耗,以及增量数据的更新策略。此外,还提到了自研的Pivot工具,可能是一种高效的数据处理引擎或算法。

4. **性能数据**:这部分会展示实际的性能测试结果,包括毫秒级的端到端响应时间,以及成本控制,如索引规模的增长和内存使用效率等关键指标。

5. **总结**:最后,文档会对整个系统的性能、成本效益和扩展性进行全面总结,指出系统设计的目的是既要满足高性能需求,又要保证低成本和易于扩展。

SQL示例展示了两个具体的查询案例,一个是广告主按年龄分布的统计,另一个是运营人员查询不同曝光次数的用户占比、点击率和收入等。这些例子展示了如何在实际工作中应用Group By来获取所需的信息。

业界实现方面,文章提到了SQL-on-Hadoop的一些解决方案,如Hive、Dremel、Kylin和Drill,以及Druid等实时分析工具,同时也介绍了腾讯自主研发的Pivot方案。

这篇文档提供了对处理海量数据Group By操作的深入洞察,对于理解大数据处理在广告行业中如何提高效率和效果具有重要价值。

2023-08-26 上传

2023-08-30 上传

2023-08-26 上传

2023-08-31 上传

2023-08-26 上传

2024-01-10 上传

点击了解资源详情

点击了解资源详情

weixin_40191861_zj

- 粉丝: 86

- 资源: 1万+

最新资源

- iamjoshbraun博客

- Password-Management-System-Nodejs-Mini_Project:使用Node js,Express js和Mongoose的初学者密码管理系统迷你项目

- reactjs-starter-kit:用于webpack捆绑包上的React JS应用的入门工具包(带有SCSS模块)

- SCA_SCA优化算法_正弦余弦优化算法_SCA_优化算法_正弦余弦算法

- Excel模板居民消费价格指数分析统计.zip

- algorithms-text-answers:在算法入门第3版中跟踪我的进度

- node-craigslist:搜索Craigslist.com列表的节点驱动程序

- physics_based_learning:计算成像系统的学习变得简单

- Python库 | python-google-places-1.2.0.tar.gz

- PMSM-vector-control_pmsm_BLDC_foc_滑膜观测器

- Ox_covid_data_and_charts

- react-native-smaato:Smaato支持** Android **和** iOS **

- Memoria-fox:用javascript编写的简单记忆游戏

- Python-Projects

- COMP397-KIIONICS-隐藏

- foundations_course:自治系统硕士课程新生的预备课程材料