机器学习基石:Regularization规则化详解

下载需积分: 0 | PDF格式 | 1.14MB |

更新于2024-08-05

| 42 浏览量 | 举报

"林轩田《机器学习基石》课程笔记14 -- Regularization1"

本文主要探讨了机器学习中解决过拟合问题的一种关键方法——Regularization(规则化)。过拟合是由于模型复杂度过高、数据噪声或数据量不足导致的现象,使得模型在训练数据上表现优秀,但在未见过的数据上表现糟糕。为了解决这个问题,Regularization被引入到模型训练过程中。

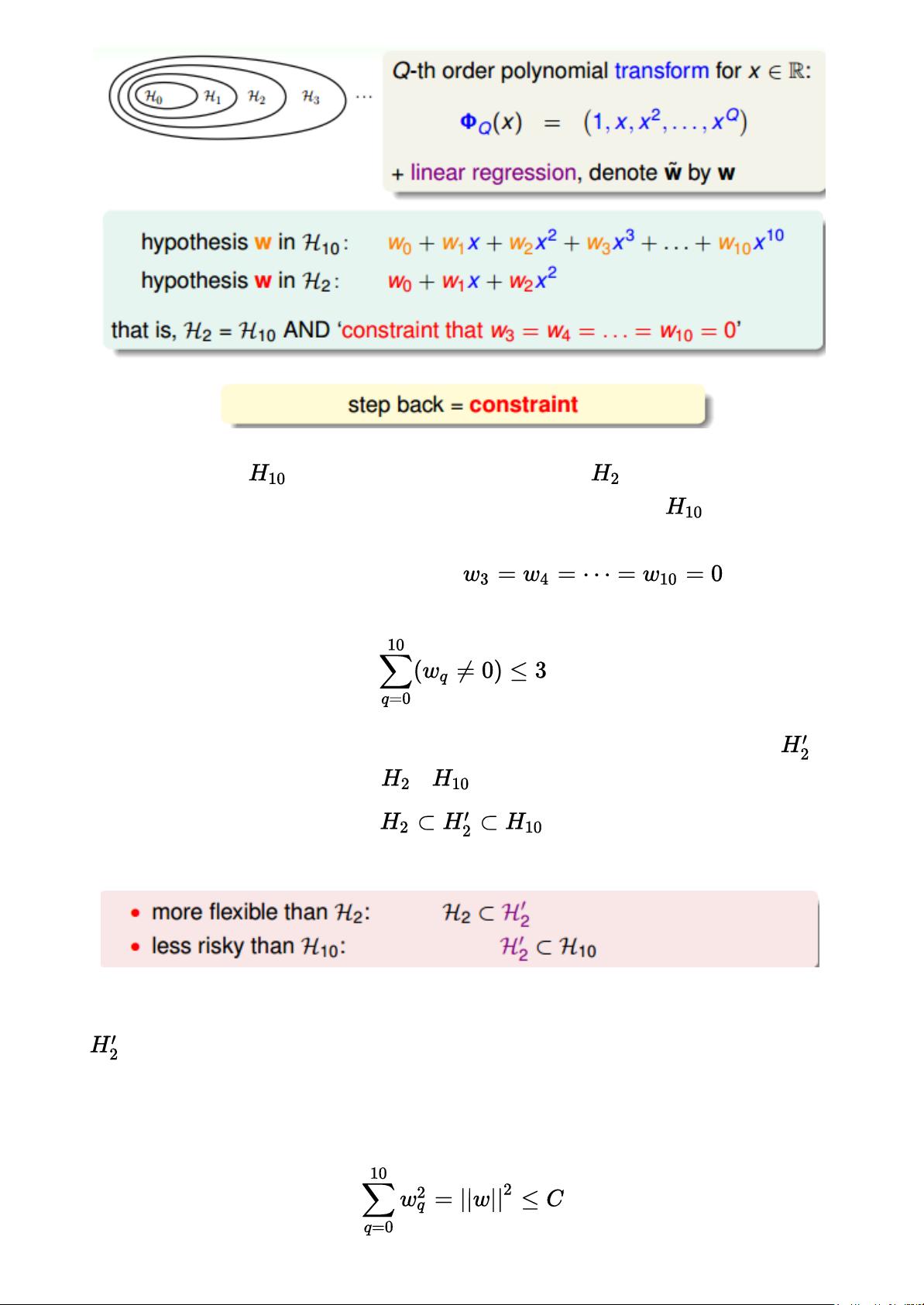

一、Regularized Hypothesis Set

规则化的假设集是通过在损失函数中添加正则项来限制模型复杂度的方法。这有助于避免过拟合,使得模型能够更好地泛化到新的数据。在上述例子中,通过将高阶多项式(如10阶)转换为低阶多项式(如2阶),可以有效地降低模型复杂度,从而减少过拟合的风险。不同的阶数的多项式假设集之间存在包含关系,高级别的假设集可以表示低级别的假设集的所有组合。

二、Weight Decay Regularization

Weight decay regularization,也称为L2正则化,是规则化的一种常见形式。在这种方法中,模型的权重向量w的平方和被添加到损失函数中,乘以一个正则化参数λ。这导致了模型倾向于选择具有较小权重的解,因为这些解的总损失会更高。公式表示为:L = L_data + λ * w^2,其中L_data是数据损失,λ控制正则化强度。

三、Looser Constraints

除了严格的约束,如让所有高阶权重w为0,还可以使用更宽松的约束。比如,可以只让一部分权重(如8个)为0,而不是全部。这样的约束被称为Looser Constraint,它可以写成:∑w² ≤ C,其中C是一个常数,限制了权重的总和。相比于严格的约束,这种松弛的限制允许模型在一定程度上保留其复杂性,但仍然能有效抑制过拟合。

总结来说,Regularization是通过在优化过程中引入额外的惩罚项来防止模型过拟合的有效手段。通过限制模型的复杂性,规则化有助于提高模型的泛化能力,使其在新数据上的表现更稳定。不同的正则化策略,如L2正则化,提供了调整模型复杂度的灵活度,以找到最优的平衡点,既能捕获数据的复杂性,又不会过度拟合训练数据。

相关推荐

杏花朵朵

- 粉丝: 732

最新资源

- 安装Oracle必备:unixODBC-2.2.11-7.1.x86_64.rpm

- Spring Boot与Camel XML聚合快速入门教程

- React开发新工具:可拖动、可调整大小的窗口组件

- vlfeat-0.9.14 图像处理库深度解析

- Selenium自动化测试工具深度解析

- ASP.NET房产中介系统:房源信息发布与查询平台

- SuperScan4.1扫描工具深度解析

- 深入解析dede 3.5 Delphi反编译技术

- 深入理解ARM体系结构及编程技巧

- TcpEngine_0_8_0:网络协议模拟与单元测试工具

- Java EE实践项目:在线商城系统演示

- 打造苹果风格的Android ListView实现与下拉刷新

- 黑色质感个人徒步旅行HTML5项目源代码包

- Nuxt.js集成Vuetify模块教程

- ASP.NET+SQL多媒体教室管理系统设计实现

- 西北工业大学嵌入式系统课程PPT汇总

已收录资源合集

已收录资源合集