章国锋教授解析视觉SLAM技术:实时定位与三维建图的应用

需积分: 46 91 浏览量

更新于2024-07-17

1

收藏 44.6MB PDF 举报

视觉同时定位与地图构建(Visual Simultaneous Localization and Mapping, SLAM)是机器人学和计算机视觉领域的核心问题,它旨在在一个未知环境中实时估计设备的位置(姿态)并构建三维场景结构。章国锋教授在CSIG第一届全国SLAM技术论坛于2022年7月28日至29日在浙江大学召开的会议上,对视觉SLAM技术及其广泛应用进行了深入探讨。

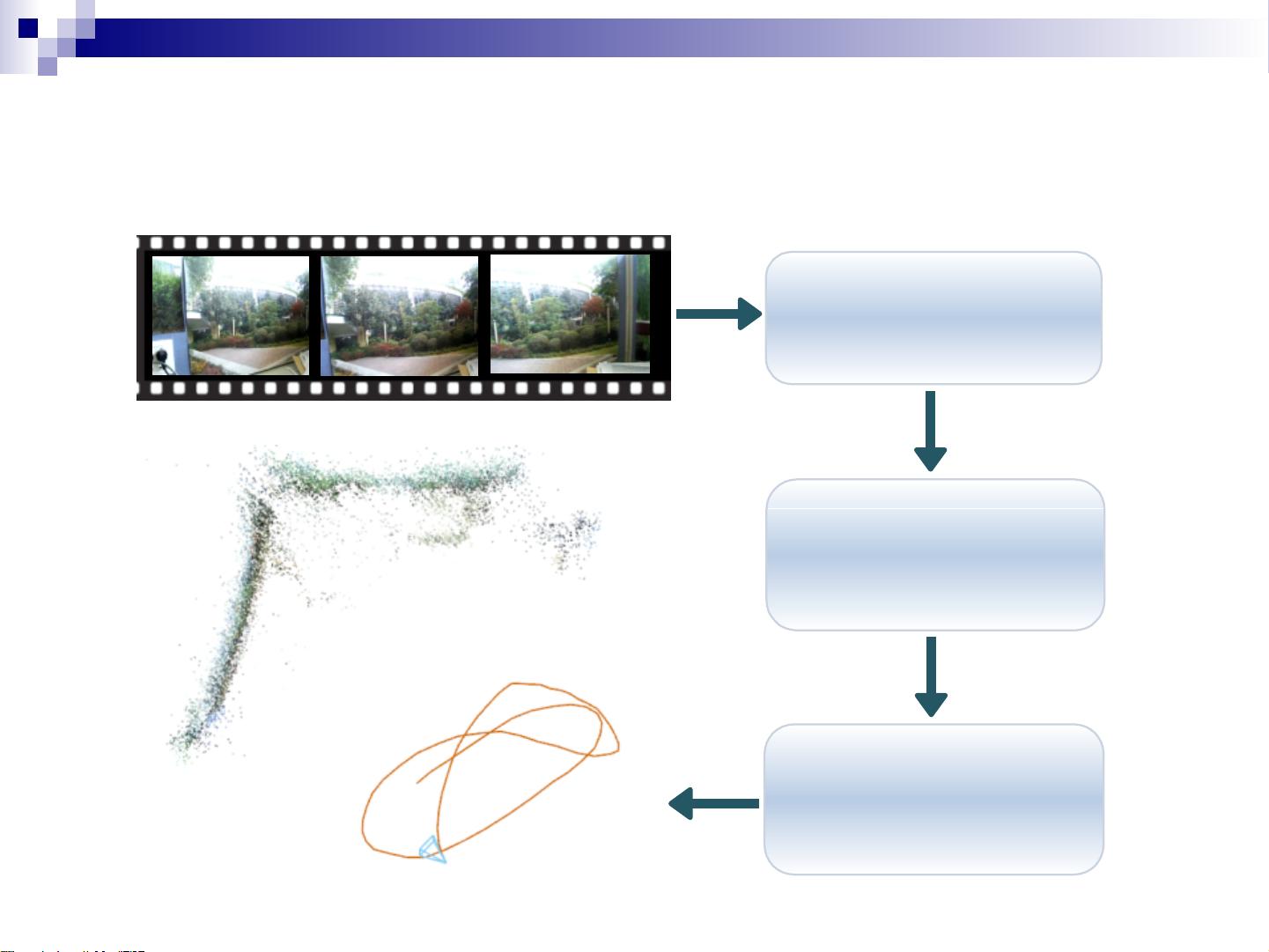

视觉SLAM是通过摄像头捕捉的图像数据来实现定位和建图,它广泛应用于增强现实(Augmented Reality)、虚拟现实(Virtual Reality)、机器人导航(包括自动驾驶)等领域。在实际操作中,SLAM系统通常包含两个主要工作线程:实时的前端传感器数据处理,负责计算设备的当前位置和方向;以及后台优化模块,进行局部或全局地图的优化,包括检测和解决循环闭合(Loop Closure Detection),这有助于减少累积误差。

传统的SLAM框架通常涉及以下几个步骤:

1. 输入:接收传感器数据,如RGB图像、深度图像、惯性测量单元(IMU)数据等。

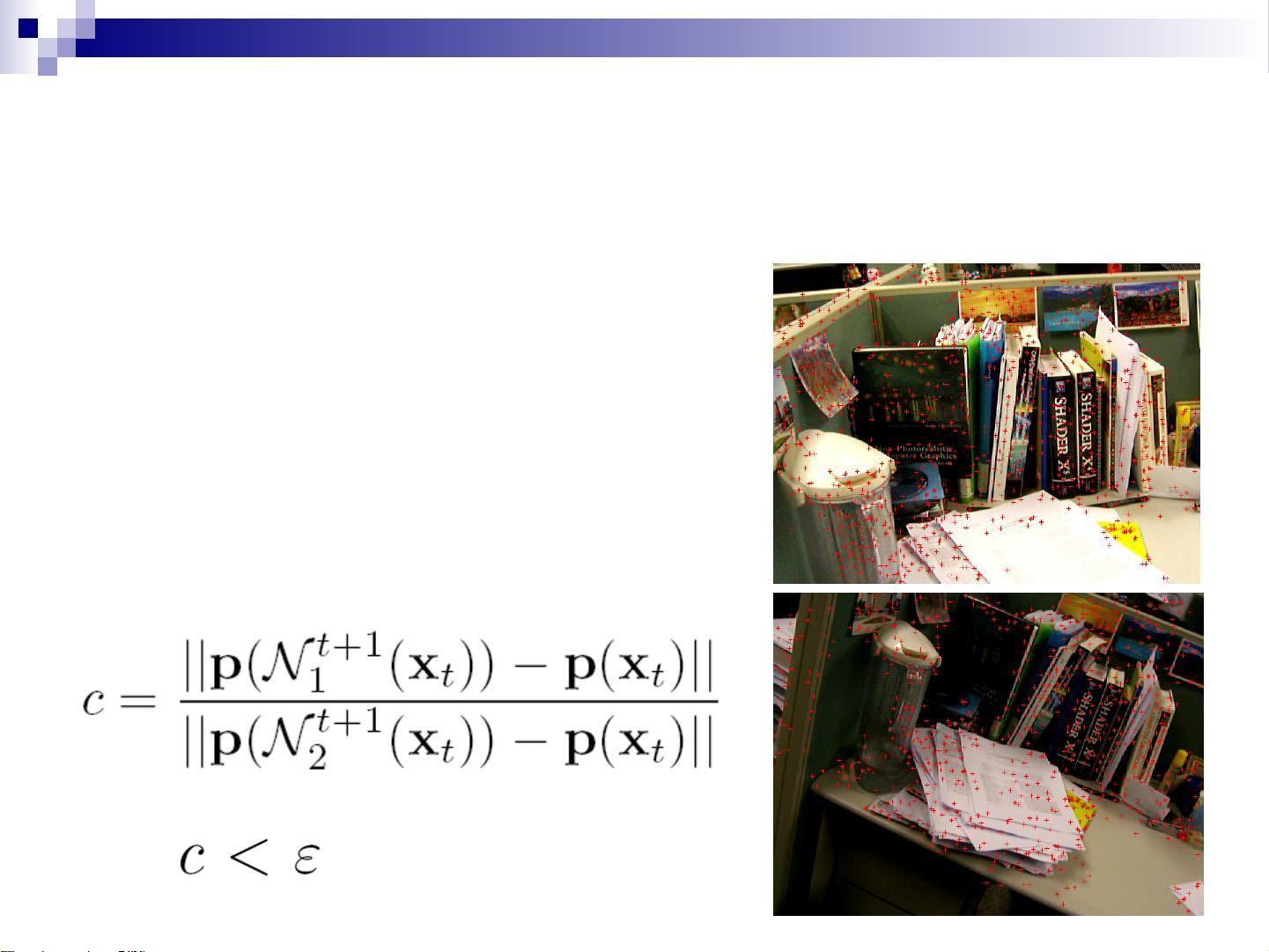

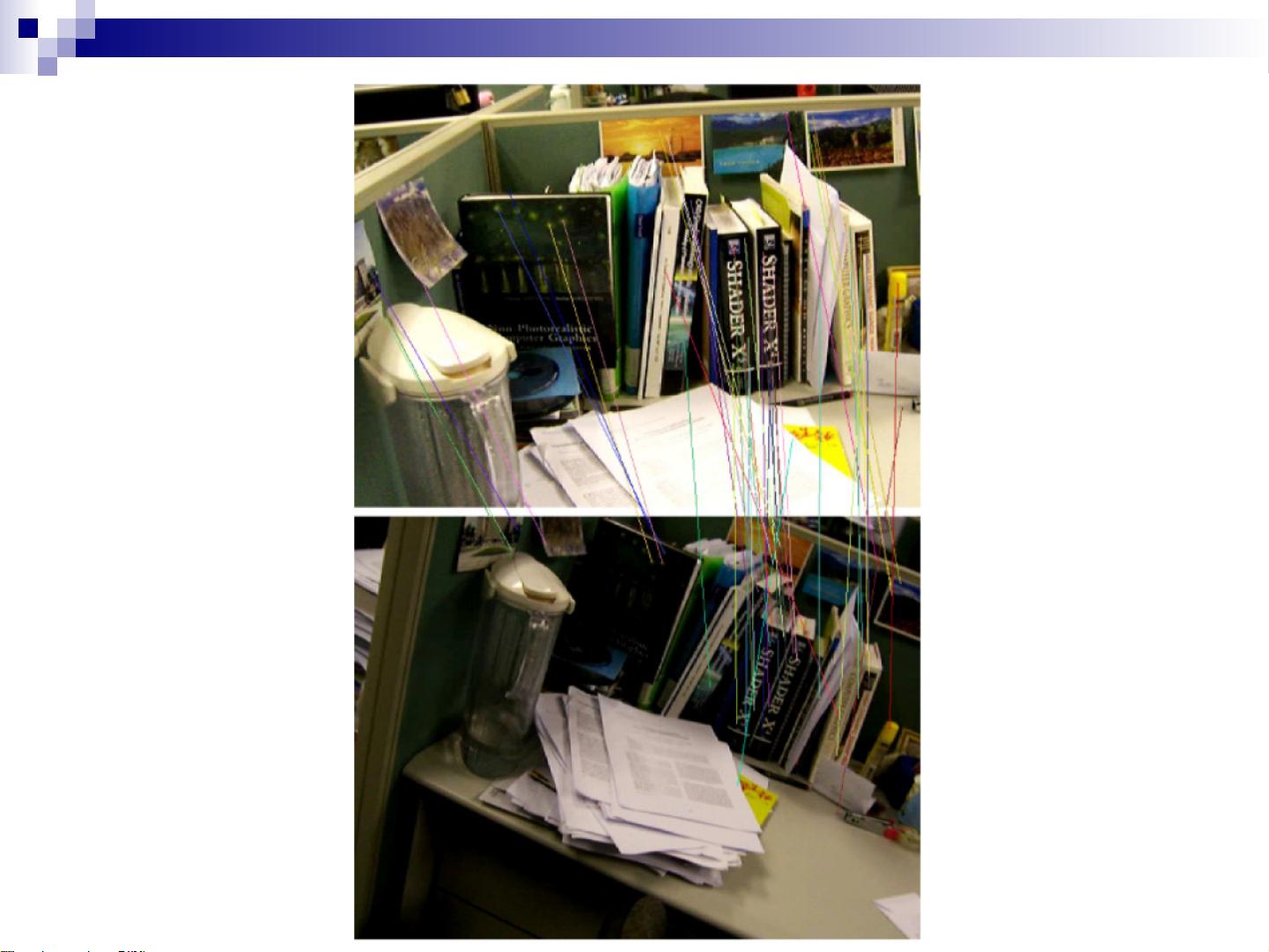

2. 前端处理:在一个前台线程中,实时计算设备的位姿。

3. 后台优化:在后台,通过优化算法处理这些数据,形成局部地图,并寻找可能的循环闭合证据,以提升地图精度。

4. 输出:最终结果包括设备的位置信息、三维点云以及用于进一步处理的传感器数据。

视觉SLAM有多种实现方式,根据硬件配置的不同,可以采用单目相机、双目相机或多目相机。辅助传感器如廉价的IMU和GPS,以及深度相机也被广泛应用,以提高系统的成本效益。视觉SLAM的优势在于较低的成本、在小空间内高精度的定位能力,以及无需预先设置场景的特点。

在小范围内,视觉SLAM尤其适合于那些对位置准确性要求较高的应用场景,比如室内导航或者机器人自主探索。然而,由于光照、遮挡和纹理缺乏等因素,视觉SLAM在复杂环境中的性能可能会受到挑战。因此,研究者们持续致力于改进算法,提升鲁棒性和效率,以便在各种环境下都能有效运行。

章国锋教授的报告涵盖了视觉SLAM的基本原理、关键技术、硬件选择以及其在现代科技中的关键作用,为我们提供了深入了解这一前沿技术的宝贵资源。参加这次论坛的听众不仅能够学习到最新的研究成果,还能了解到如何将这些技术应用于实际产品和解决方案中。

点击了解资源详情

点击了解资源详情

142 浏览量

411 浏览量

331 浏览量

296 浏览量

304 浏览量

296 浏览量

300 浏览量

CLM_Only

- 粉丝: 21

最新资源

- 逆强化学习项目示例教程与BURLAP代码库解析

- ASP.NET房产销售管理系统设计与实现

- Android精美转盘交互项目开源代码下载

- 深入理解nginx与nginx-http-flv-module-1.2.9的整合推流

- React Progress Label:实现高效进度指示的组件

- mm3Capture:JavaFX实现的MM3脑波数据捕获工具

- ASP.NET报表开发设计与示例解析

- 打造美观实用的Linktree侧边导航栏

- SEO关键词拓展软件:追词工具使用体验与分析

- SpringBoot与Beetl+BeetlSQL集成实现CRUD操作Demo

- ASP.NET开发的婚介管理系统功能介绍

- 企业政府网站源码美化版_全技术领域项目资源分享

- RAV4 VFD屏时钟自制项目与驱动程序分析

- STC_ISP_V481 在32位Win7系统上的成功运行方法

- Eclipse RCP用例深度解析与实践

- WPF中Tab切换与加载动画Loding的实现技巧