探索Flink核心技术:流处理与批处理的统一平台

125 浏览量

更新于2024-08-28

收藏 462KB PDF 举报

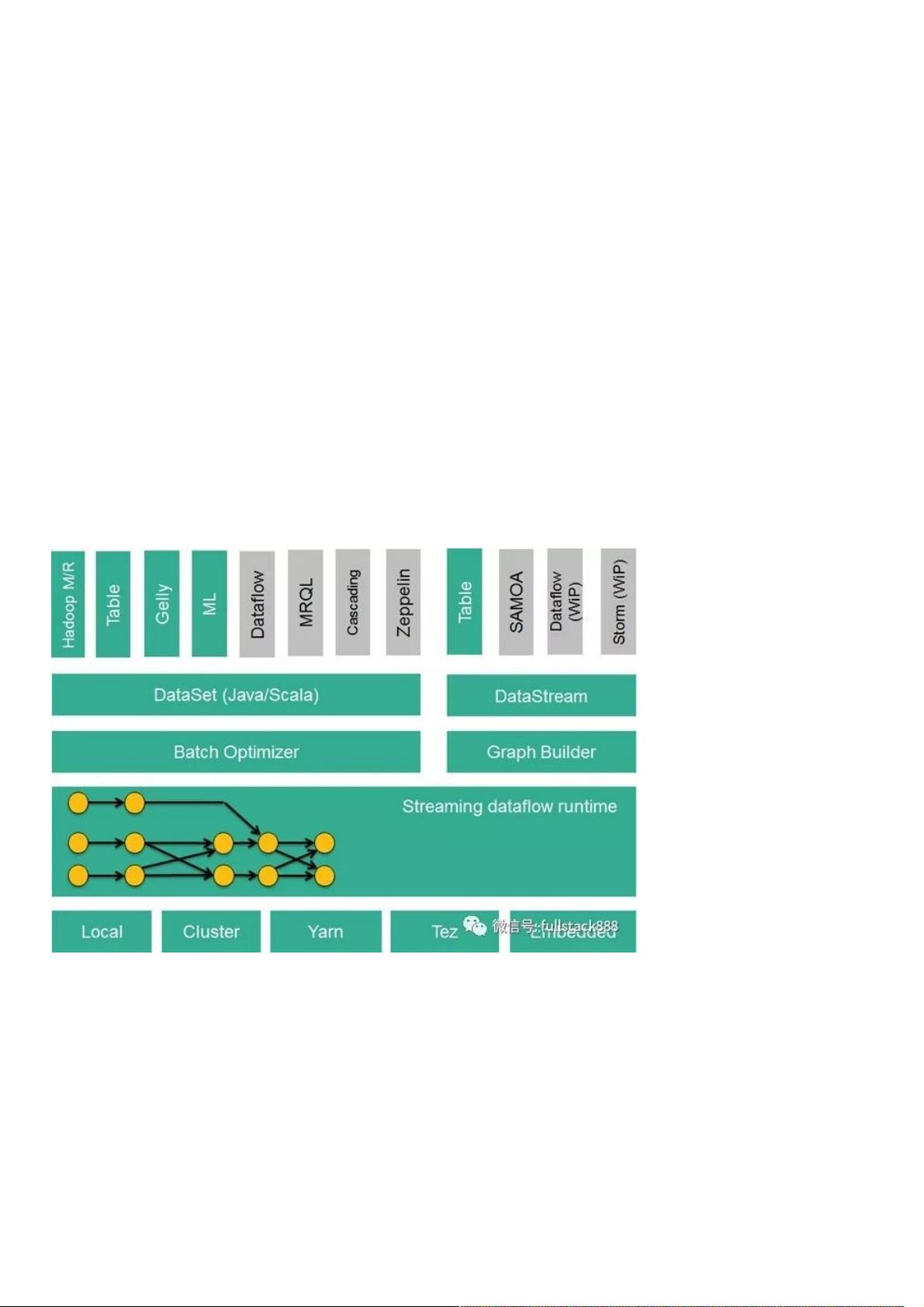

Apache Flink,作为一个新兴的大数据处理框架,以其独特的设计理念和高效性能吸引了众多关注。它不同于传统的MapReduce、Spark和Storm等框架,Flink的核心是流式数据流执行引擎,专注于数据流的分布式计算,提供了数据分布、数据通信和容错机制,这使得它能够在实时性和批处理之间实现无缝切换。

Flink的主要特性包括三个核心API:DataSet API、DataStream API和Table API。DataSet API专用于批处理操作,允许用户以分布式数据集的形式处理静态数据,提供丰富的操作符支持,涵盖Java、Scala和Python等多种编程语言。DataStream API则针对流处理,将数据视为连续的数据流,支持实时操作,仅限于Java和Scala。Table API则引入了结构化数据查询的概念,用户可以使用类SQL的Domain Specific Language (DSL) 对关系表进行查询,同样支持Java和Scala。

除了基础API,Flink还针对特定应用场景提供了扩展库,如FlinkML用于机器学习,提供了机器学习管道和多种算法实现;Gelly则专注于图计算,提供图算法的API。这表明Flink不仅仅是一个通用的大数据处理工具,它还能够满足复杂的业务需求。

Flink技术栈的完整性使其能够与Hadoop生态系统无缝集成,比如读取HDFS或HBase中的数据,或者使用Kafka作为流数据源。更重要的是,Flink能够将批处理和流处理任务统一在一个平台上执行,打破了传统框架对任务类型的限制,这意味着开发者可以在同一个系统中灵活处理实时和批量数据,提高了效率和灵活性。

总结来说,深入理解Apache Flink的核心技术包括其流式数据流执行引擎、多模式API的设计、领域库的支持以及与Hadoop生态系统的集成能力。掌握这些核心特性和优势,对于大数据处理开发者来说,无疑能够提升其在实时和批处理场景下的解决方案构建能力。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2017-07-26 上传

2020-05-04 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

2024-12-25 上传

weixin_38591291

- 粉丝: 6

- 资源: 956

最新资源

- example-website:在以下网站发布事件的示例网站

- 学习201

- 电力设备行业:特斯拉产能加速扩建,光伏平价时代方兴未艾.rar

- TechAvailabilityBot

- whoistester WrapEasyMOnkey:查看monkeyrunner 脚本的交互jython 库-开源

- vc游戏编程库的源程序,如A*算法 A星算法 AStar自动寻路算法

- GenomicProcessingPipeline:用于处理“原始”基因组数据的管道(全基因组测序,RNA测序和靶标捕获测序)

- 行业文档-设计装置-一种制备弯曲钢绞线的装置.zip

- config-server-data

- 蓝桥杯嵌入式 mcp4017 iic

- com.tencent.mtt.apkplugin.ipai9875.zip

- kokoa-talk:带有克隆编码(HTML,CSS)

- TaTeTi:TaTeTi多人游戏(进行中)

- 下午

- the-button-clicker:自动按下 reddit 上的“按钮”的 chrome 扩展

- 行业文档-设计装置-一种切纸机的斜刀连动机构.zip