保姆级教程:本地微调DeepSeek-R1-8b模型操作指南

PDF格式 | 6.39MB |

更新于2025-03-20

| 110 浏览量 | 举报

本教程详细介绍了如何在本地环境中微调DeepSeek-R1-8b模型的具体操作步骤和方法。DeepSeek模型是一种深度学习模型,尤其适用于处理复杂的数据分析和预测任务。而本地微调是指在特定的数据集上继续训练已经预训练好的模型,以期在该特定任务上获得更好的性能。

一、文档说明与服务器准备

1.1 文档说明

本教程是由一位正在从传统云计算领域向人工智能领域转型的作者所撰写,旨在记录作者在微调DeepSeek-R1-8b模型过程中遇到的问题及解决方案。文档适合有一定计算机软件知识的读者参考,帮助他们复现文档中的操作步骤。

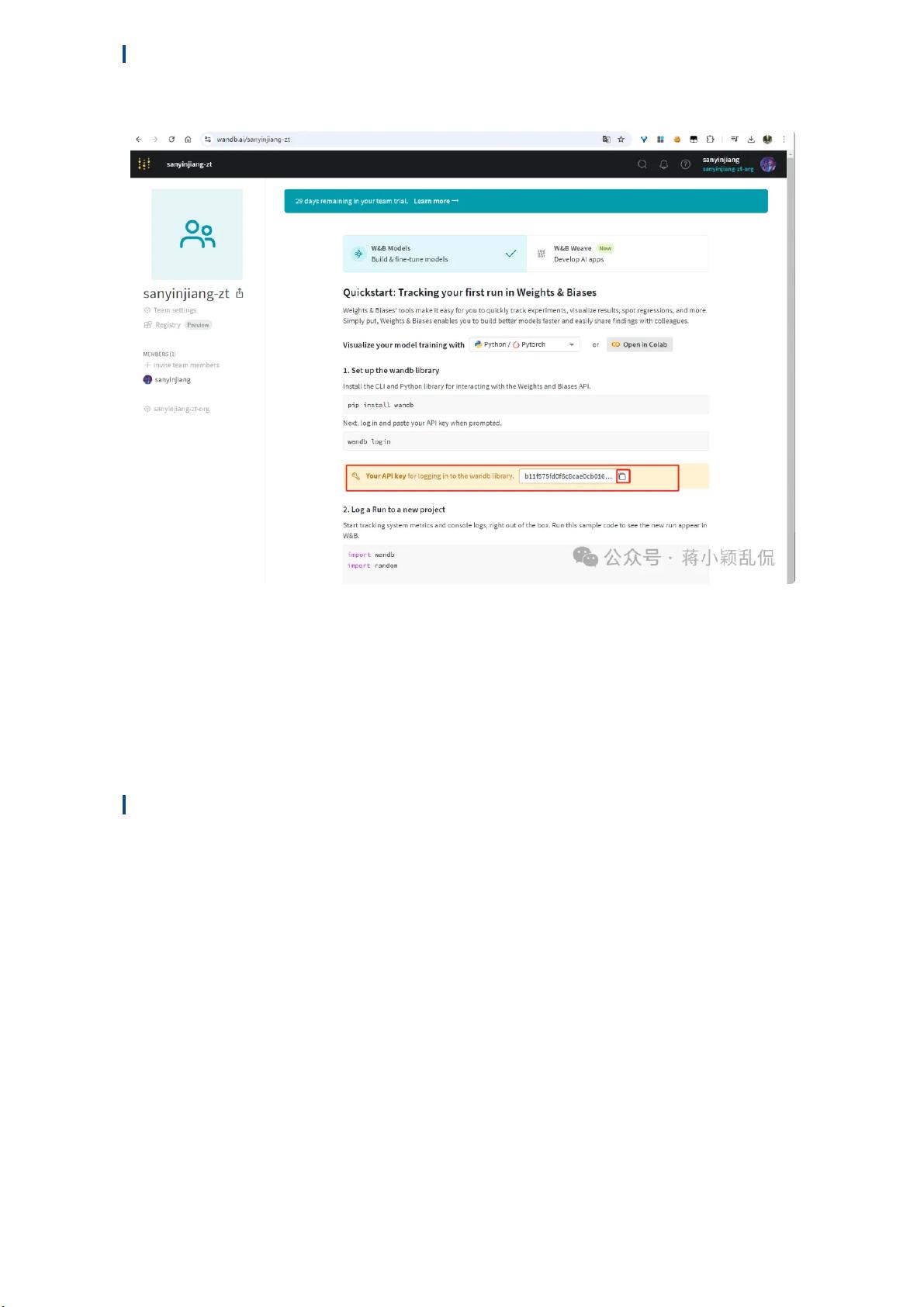

在操作过程中,作者解决了一些常见的问题,如下载大型模型文件时的限制、操作过程中相关python库版本的兼容性问题、以及wandb认证问题等。所有这些内容都被详细记录在本教程中。

1.2 服务器与GPU准备

教程中提到的服务器配置为x86_64构架的Hygon C86 5380物理服务器,具有32核CPU和64GB内存以及960GB的硬盘空间。该服务器还装备了NVIDIA A40 GPU,专门用于处理深度学习任务。如果读者的GPU资源更为有限,建议使用参数更少的模型版本,例如DeepSeek-R1蒸馏模型的1.5B版本,该版本甚至能够在没有GPU支持的情况下仅靠CPU运行。

作者还提到了一些重要软件的版本信息,建议使用conda创建一个新的虚拟环境,并在该环境中安装指定版本的python库。这是为了确保软件环境的一致性,并避免版本冲突导致的问题。所使用的具体软件版本如下:

• GPU驱动版本:550.54.15

• Cuda版本:V12.4.131

• torch版本:2.6.0

• transformers版本:4.48.3

• unsloth版本:2025.2.5

1.3 大模型微调定义

文档中对大模型微调进行了解释,即使用特定领域的数据集对已经预训练完成的大模型进行进一步训练的过程。这个过程的目的是优化模型在特定任务上的性能,使得模型能够更好地适应并完成特定领域的任务。在微调过程中,最重要的是对超参数(如学习率、批次大小和训练轮次等)的调整优化,以提高模型在特定数据集上的表现。

二、相关文件下载

2.1 模型文件下载

由于网络访问限制,作者未能直接从huggingface网站下载所需的模型文件与数据集。因此,文档中提供了访问魔搭平台的链接(https://modelscope.cn/mod),这是一个国内网络可以正常访问的平台,用于下载所需的模型文件和数据集。

总结来说,本教程涵盖了从准备微调环境到下载所需文件的所有步骤,不仅提供了具体的操作指南,还考虑了软件版本兼容性问题和网络访问问题。对于希望在本地环境微调DeepSeek-R1-8b模型的读者来说,这是一份非常有价值的指导资料。

相关推荐

AI方案2025

- 粉丝: 1385

最新资源

- C++编程实现网络ping功能的源码工具解析

- QQ空间图片浏览效果仿制代码指南

- project_vj项目分析:深入CSS技术核心

- C#实现的FTPServer服务器:支持双模式并能承载500并发连接

- JSP留言板教程:在MyEclipse中快速搭建

- Java远程调用RMI的三种实现方法

- 下载酒店管理系统完整方案参考样本

- Java进阶必读:五百篇精选文档深度学习

- MySQL自动生成随机root密码的脚本使用指南

- VISION电池产品与市场应用的详细介绍

- JSON/JS格式COVID-19数据集:快速集成与多个国家数据整合

- C#即时通讯软件源码:快速聊天工具开发指南

- Android中实现邮件发送功能的详细教程

- 水溶性薄膜纸的创新制备技术介绍

- 一键去除Win7 64位系统桌面快捷箭头技巧

- Android触屏摇杆控制蓝牙车项目文件解析