深入剖析Hadoop源代码:分布式处理基石

需积分: 3 199 浏览量

更新于2024-07-24

收藏 5.84MB DOC 举报

"Hadoop源代码分析"

Hadoop是一个开源的分布式计算框架,它允许在廉价硬件上处理大规模数据集。这个框架主要由两个核心组件组成:Hadoop Distributed File System (HDFS) 和 MapReduce。HDFS是分布式文件系统,灵感来源于Google的GFS,它能高效地存储和处理大量数据;而MapReduce是并行处理和计算模型,灵感来源于Google的MapReduce,用于在分布式环境中执行大数据处理任务。

在Hadoop源代码分析中,我们可以看到Hadoop的设计理念和实现细节。例如,HDFS的设计目标是高容错性和高吞吐量的数据访问。它通过数据复制机制确保数据的可靠性,并通过将大文件分割成块并在多台机器上存储来实现并行处理。ZooKeeper在Hadoop中扮演了类似于Google Chubby的角色,提供分布式协调服务,保证系统中各个节点的同步和一致性。

MapReduce组件则负责任务调度和数据处理。它将大任务分解为多个小的Map任务和Reduce任务,这些任务可以在集群中的不同节点上并行执行。Map阶段将输入数据分片,应用用户定义的函数进行预处理,而Reduce阶段则聚合Map阶段的结果,生成最终输出。Hadoop的MapReduce实现还包括一个JobTracker,它负责监控和调度任务,以及TaskTrackers,它们在工作节点上运行Map和Reduce任务。

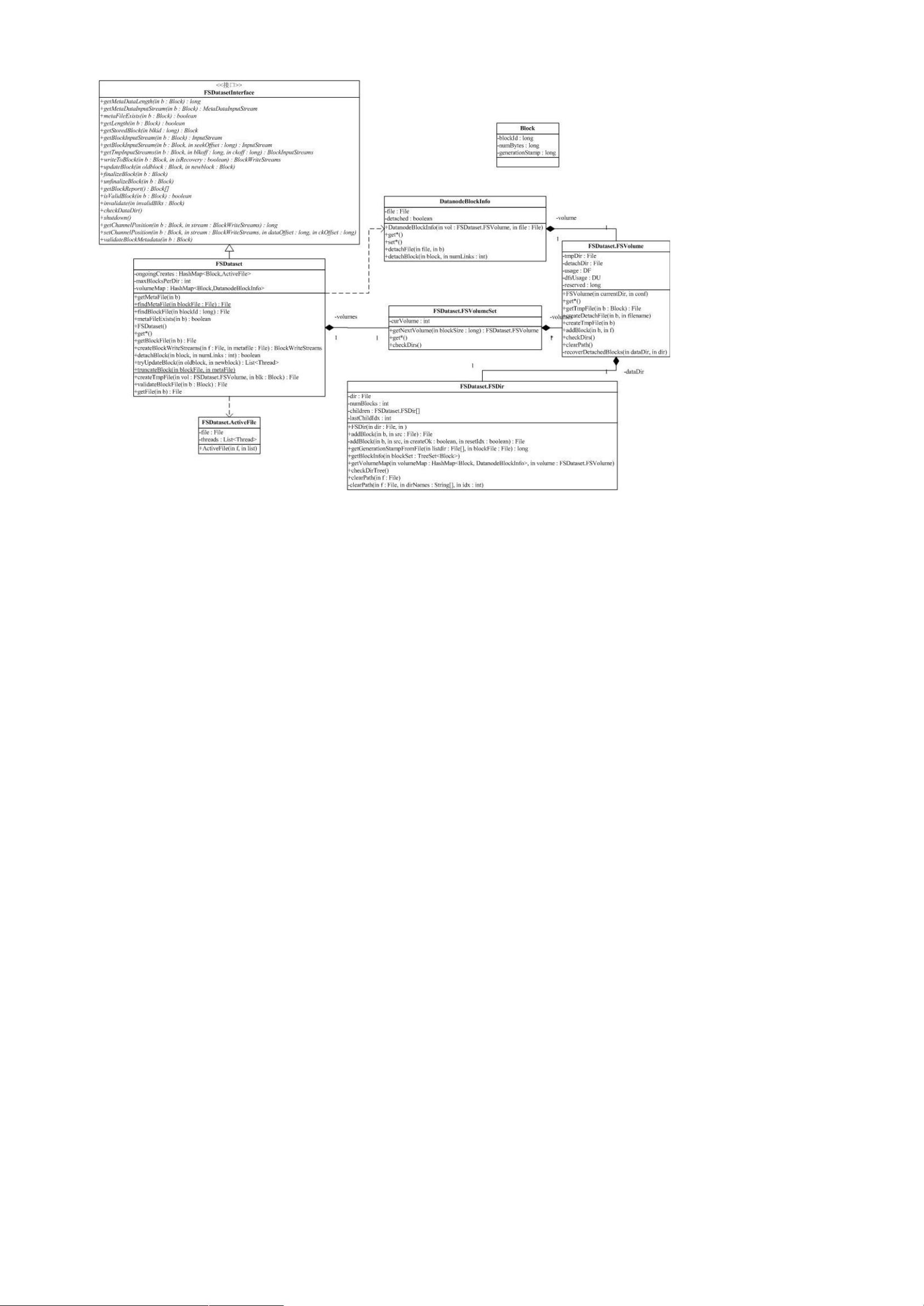

Hadoop的源代码结构复杂,各个包之间存在复杂的依赖关系。例如,`conf`包负责读取系统配置,它依赖于`fs`包来访问文件系统,而`fs`包又包含了一些抽象的文件系统操作。这种设计使得Hadoop能够透明地支持多种存储系统,包括本地文件系统、HDFS和Amazon S3。

在分析Hadoop源代码时,重点关注的部分包括HDFS的文件块管理、NameNode和DataNode的交互、MapReduce的作业生命周期管理以及容错机制等。Hadoop的工具包提供了许多实用工具,如用于数据迁移、格式化NameNode、检查HDFS健康状况等。

此外,Hadoop生态系统还包括了其他组件,如HBase,它是基于BigTable设计的分布式数据库,用于存储非结构化和半结构化数据;Hive则是Facebook开发的一种数据仓库工具,它允许用户使用SQL语法查询和分析存储在Hadoop上的数据。

深入理解Hadoop的源代码有助于开发者更好地优化和定制Hadoop集群,解决实际问题,如提高数据处理性能、优化资源分配,以及开发新的分布式应用程序。通过分析Hadoop的实现,我们可以学习到分布式系统设计的关键原则和最佳实践,这对于构建大规模分布式应用具有重要的指导意义。

389 浏览量

283 浏览量

2024-06-26 上传

226 浏览量

2024-09-03 上传

2024-09-25 上传

2024-10-26 上传

305 浏览量

weichengxing168

- 粉丝: 1

- 资源: 15

最新资源

- Books-Downloader:浏览器加载项(Google-Chrome Firefox Firefox-Android),使您可以从audioknigi.club网站下载整个有声读物

- metalus:该项目旨在通过抽象化将驱动程序组装成可重复使用的步骤和管道的工作,使编写Spark应用程序更加容易

- 点文件2

- TalkDemo_G711_AAC-master.zip

- 在哪里将actionPerformed方法放在类中?

- itwc

- Linux实训.rar

- CssAnimationLaboratory:我的css3动画实验室

- Bukubrow-crx插件

- 姆泽普

- M.O.M.P-Malks-Outragous-Mod-Pack:马尔克

- gmail-frontend:这是我关于gmail clone的简单项目

- FlaskWeb:在Azure上部署Flask的指南

- JITWatch.zip

- ajax-utilities:AJAX 辅助方法

- MicroJoiner.7z