ACL2023:GPT-3智能客服背后的成本考量:竟是赔钱的决定?

版权申诉

87 浏览量

更新于2024-08-04

收藏 1.38MB PDF 举报

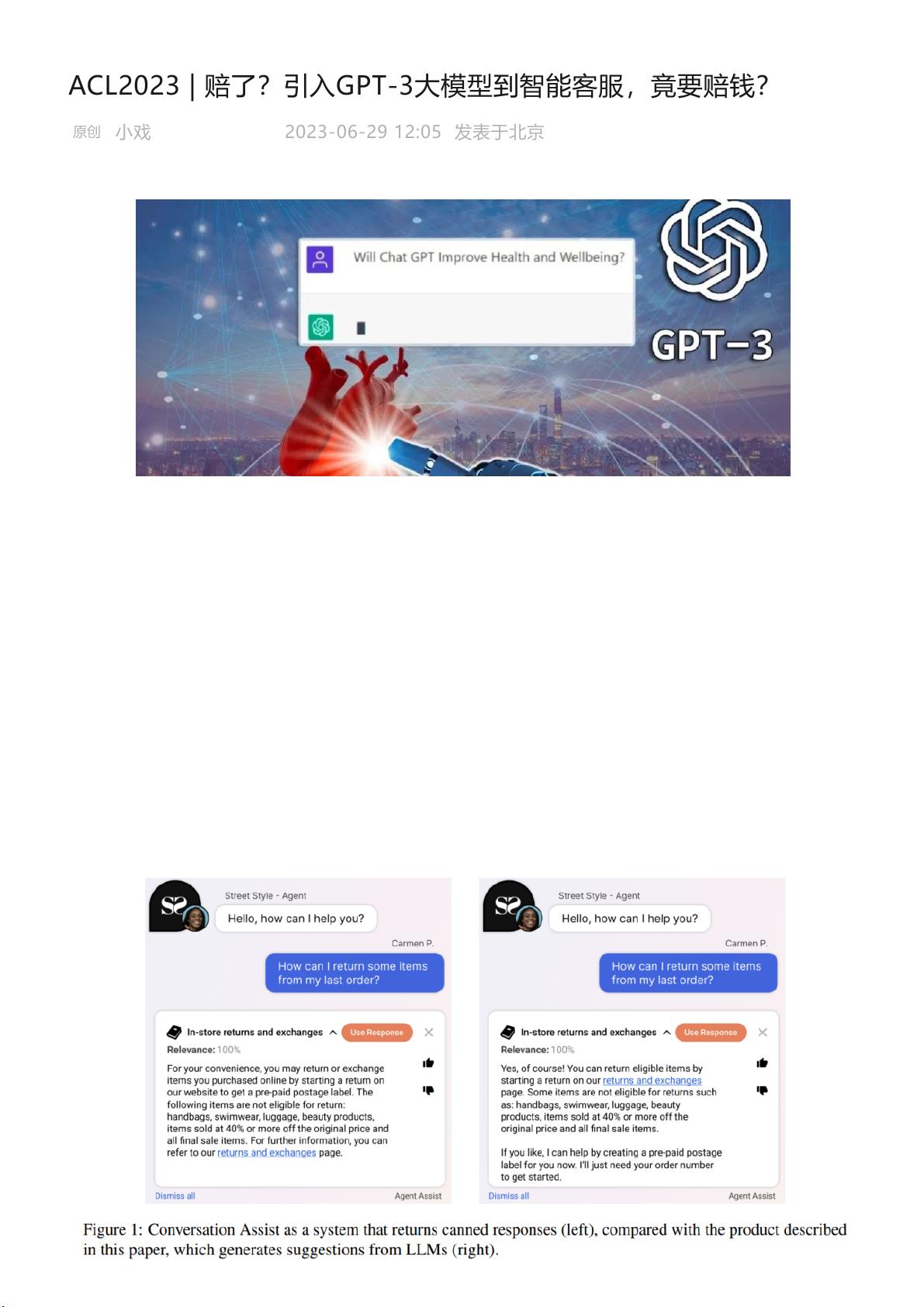

在2023年的国际计算机语言学会议(ACL2023)上,一篇引人关注的文章探讨了将大规模语言模型(如GPT-3)应用于智能客服领域的经济效益问题。尽管大模型,特别是对话式AI科技如Chat,被认为非常适合智能客服场景,因为它们能够处理大量用户交互并降低人工客服的成本,但研究人员发现,将GPT-3这样的大模型作为智能客服的核心(Backbone)可能并不像预期那样带来显著的成本节约。

文章指出,大模型如GPT-3的训练和响应成本非常高。例如,使用GPT-2与Nvidia A100 GPU进行一次响应的费用大约是0.0011美分,而换成基于GPT-3的Davinci模型,通过OpenAI API的响应成本则飙升至1.1美分。这表明,虽然大模型API的直接成本看似低廉,但实际应用中,企业所面临的成本远比这复杂,包括模型微调、集成到具体业务流程中的额外开发和维护费用,以及可能因模型升级导致的持续成本增加。

为了更准确地评估大模型在智能客服中的实际经济效果,研究人员提出了一种期望净成本节约(Expected Net Cost Savings, ENCS)的框架。该框架旨在综合考虑不同LLMs(大规模语言模型)以及不同供应商下部署大模型的成本与收益,以衡量是否真正实现了成本节约。ENCS框架需要考虑到模型性能提升带来的客户满意度提升、潜在的运营效率提升,以及与传统客服相比的长期效益,这些都是决定大模型商业落地经济效益的关键因素。

然而,文章结论令人意外的是,尽管大模型理论上能提高效率,但在某些特定情况下,引入GPT-3等大模型到智能客服可能并未带来实际的经济效益,甚至可能出现亏损。这引发了关于大模型商业应用策略的深入讨论,即如何平衡模型性能、成本和实际业务需求,以确保在AI客服领域的投资回报。未来的研究和实践可能会围绕这一议题展开,探索更为精细的成本效益分析方法和技术优化,以便在实际商业环境中最大化大模型的价值。

2023-10-18 上传

2023-05-18 上传

2022-07-15 上传

2023-05-26 上传

2023-08-12 上传

2021-03-05 上传

2022-09-19 上传

2024-09-16 上传

普通网友

- 粉丝: 1263

- 资源: 5619

最新资源

- 基于Python和Opencv的车牌识别系统实现

- 我的代码小部件库:统计、MySQL操作与树结构功能

- React初学者入门指南:快速构建并部署你的第一个应用

- Oddish:夜潜CSGO皮肤,智能爬虫技术解析

- 利用REST HaProxy实现haproxy.cfg配置的HTTP接口化

- LeetCode用例构造实践:CMake和GoogleTest的应用

- 快速搭建vulhub靶场:简化docker-compose与vulhub-master下载

- 天秤座术语表:glossariolibras项目安装与使用指南

- 从Vercel到Firebase的全栈Amazon克隆项目指南

- ANU PK大楼Studio 1的3D声效和Ambisonic技术体验

- C#实现的鼠标事件功能演示

- 掌握DP-10:LeetCode超级掉蛋与爆破气球

- C与SDL开发的游戏如何编译至WebAssembly平台

- CastorDOC开源应用程序:文档管理功能与Alfresco集成

- LeetCode用例构造与计算机科学基础:数据结构与设计模式

- 通过travis-nightly-builder实现自动化API与Rake任务构建