深度学习基础:LSTM模型详解与长期依赖问题

版权申诉

深度学习基础(六):LSTM模型及原理介绍

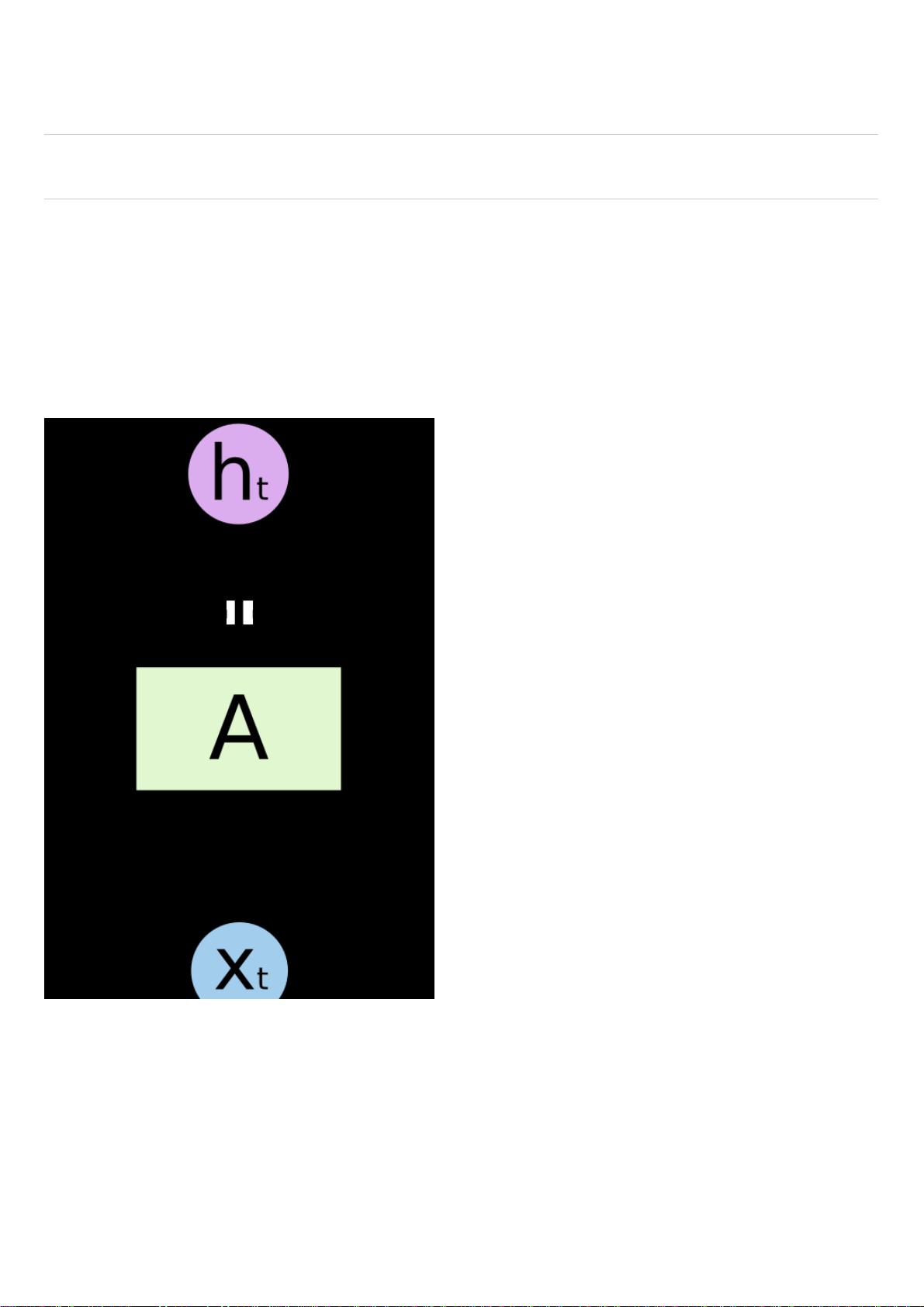

本文深入探讨了长短期记忆(LSTM)模型,一种特殊的循环神经网络(RNN),在深度学习领域中的重要性和应用。RNN因其循环结构能够处理序列数据,如文本、语音或视频中的时间序列信息,解决了传统神经网络在处理长期依赖问题上的局限性。它们能够利用先前的信息来影响后续的决策,使得在诸如语言建模、机器翻译和图像描述等任务中取得了显著的成功。

LSTM的核心在于其内部的记忆单元,它通过门控机制(包括输入门、遗忘门和输出门)来控制信息的流动,有效地解决了长期依赖问题。相比于标准RNN,LSTM能更好地保留并传播长期的历史信息,避免了梯度消失或爆炸的问题,从而提高了模型的性能和稳定性。在许多深度学习项目中,尤其是在自然语言处理(NLP)任务中,LSTM扮演了关键角色,尤其是在词嵌入和文本生成等领域。

在实际应用中,例如语言模型中,当预测一个句子的下一个词时,LSTM可以根据前面的词序列提供上下文信息,而不需要额外的全局上下文。这使得LSTM能够在保持长期记忆的同时,保持高效的计算效率。Andrej Karpathy的博客文章是一个很好的学习资源,展示了LSTM在各种复杂任务中的具体应用和优势。

总结来说,LSTM模型是深度学习中不可或缺的一部分,它通过创新的结构和机制,解决了传统RNN在处理序列数据中的挑战,极大地推动了在诸如机器翻译、情感分析、语音识别等领域的进展。掌握LSTM的工作原理和实践应用,对于理解和构建高效深度学习系统至关重要。

441 浏览量

985 浏览量

202 浏览量

384 浏览量

点击了解资源详情

点击了解资源详情

261 浏览量

480 浏览量

163 浏览量

_webkit

- 粉丝: 31

- 资源: 1万+

最新资源

- 酒店申报住宿登记制度

- SWTableViewCell(iPhone源代码)

- libdvid-cpp:用于访问 DVID 的 REST API 的 C++ 库

- Goodreads Half-Stars and Rating Tags-crx插件

- flex-blog:Projeto de site do curso da OrigamID feito com CSS flex box

- matlab开发-拉普拉斯随机数发生器

- activiti_designer需要额外插件JAR包.zip

- main:这将是与2019年Spring软件工程课程有关的所有内容的主要回购

- vscode windows 10 64位安装包

- aScopy-开源

- 酒店环境管理手册范例范例

- Carmen Sandiego HD Wallpapers Tab-crx插件

- jct-discord-bot:JCT ESP Compsci Discord的Bot

- jdk arm 32 压缩包

- Gator-Enterprise.github.io

- SmartControl:我的第一个Android应用,涵盖所有内容