ELK堆栈配置与实践:Logstash、Grok与Multiline应用详解

需积分: 16 175 浏览量

更新于2024-07-19

收藏 751KB DOCX 举报

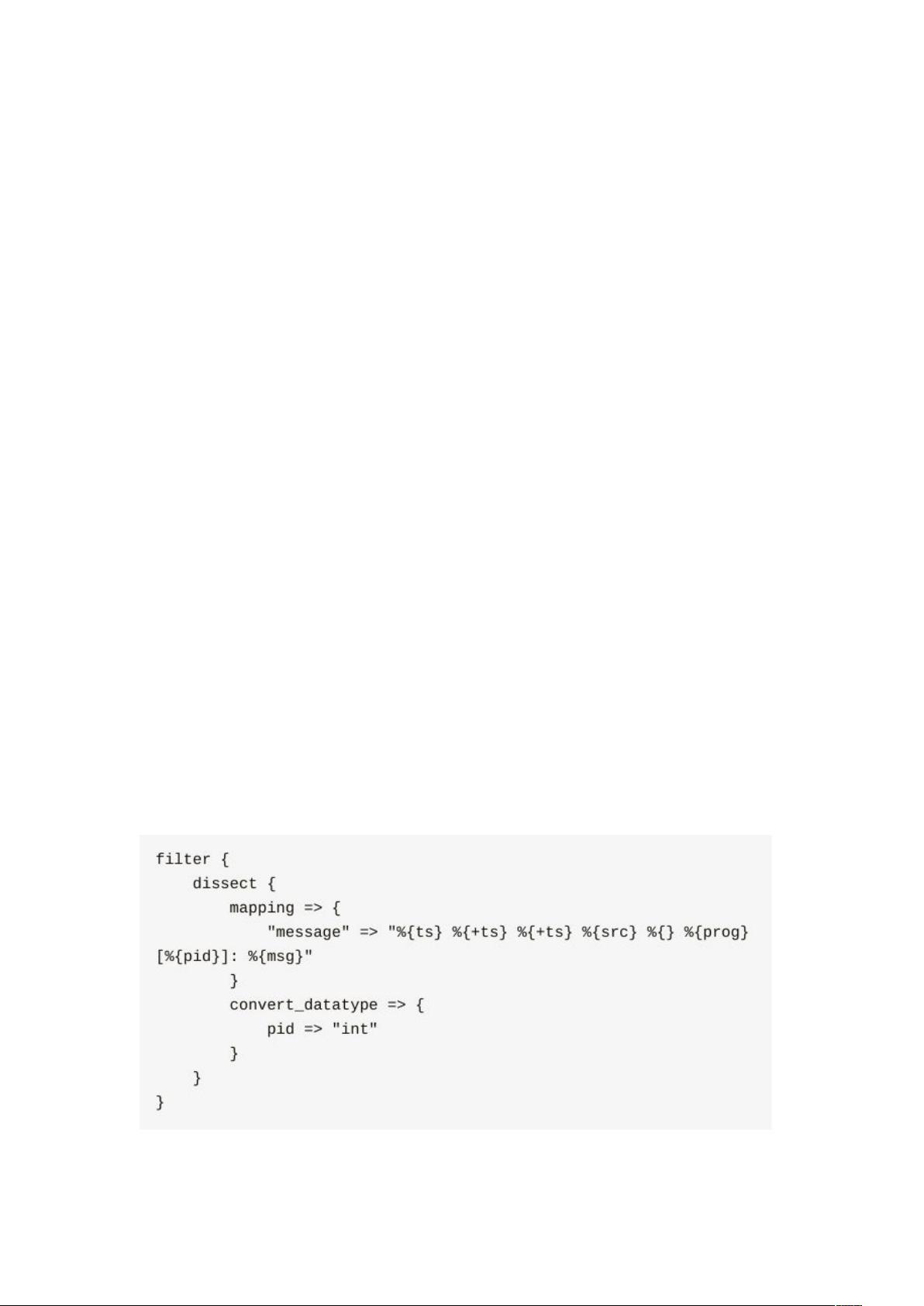

ELK(Elasticsearch、Logstash和Kibana)是一个流行的开源套件,用于日志管理和分析。本文将围绕ELK的各个组件进行深入学习,特别是Logstash的配置和使用方法。

1. **Logstash Input配置:** Logstash的核心功能之一是数据输入。其中,"文件"(file)输入是最基本的,用于读取本地文件中的日志。例如,通过指定文件路径、解析规则和模式,如:

```markdown

input {

file {

path => "/path/to/your/logs/*.log"

start_position => "beginning"

}

}

```

**最佳实践**推荐使用`LogStash::Inputs::TCP`结合`LogStash::Filters::Grok`处理来自网络的syslog日志,这可以更高效地解析复杂格式的日志数据。

2. **线程管理(-pipeline-workers或-w)**:设置`--pipeline-workers`参数可以控制Logstash在执行过滤器(filter)和输出(output)时使用的线程数,默认值是CPU核心数,有助于优化性能和并发处理能力。

3. **Codec**:Logstash的Codec模块允许与不同数据格式的产品(如Graphite、Fluentd、NetFlow等)无缝集成。使用`codec`可以确保数据格式的一致性,如JSON、MsgPack或EDN格式:

```markdown

output {

elasticsearch {

codec => "json"

}

}

```

4. **Multiline模式**:当一条日志跨越多行时,Logstash的Multiline插件可以帮助合并这些数据。例如,配置规则可以识别特定的分隔符或行数,以便正确解析多行信息。

5. **Collected插件**:用于收集系统性能指标,提供了多种存储机制,如内存、磁盘或数据库,用于监控和分析系统的实时运行状况。

6. **Grok**:Grok是Logstash的强大工具,用于解析日志消息中的结构化数据。它利用正则表达式匹配模式,如在上述示例中,定义了一个正则模式来解析Postfix anvil日志中的关键字段:

```markdown

grok {

patterns_dir => ["/etc/logstash/patterns.d"]

match => ["message", "%{POSTFIX_ANVIL}"]

tag_on_failure => ["_grok_postfix_anvil_"]

}

```

此处的正则表达式使用了特殊的符号如`(?m)`表示多行模式,并定义了一系列字段的名称和格式。

总结起来,学习ELK涉及配置输入源、处理数据流、设定线程管理、编码转换、解析复杂的日志模式以及收集系统性能数据。通过合理的配置和使用Grok,可以高效地管理和分析大规模的日志数据,为运维决策提供有力支持。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2019-05-01 上传

2019-04-26 上传

2018-02-03 上传

2023-10-13 上传

2024-04-16 上传

gaoyong19871104

- 粉丝: 2

- 资源: 8

最新资源

- react_website

- HCMGIS_Caytrong_Local

- 毕业设计&课设--毕业设计之鲜花销售网站的设计与实现.zip

- django-compiling-loader:Django的编译模板加载器

- Excel模板送货单EXCEL模板.zip

- tfbert:一个使用tf2复现的bert模型库

- 商用服务机器人行业研究报告-36氪-2019.8-47页.rar

- 愤怒的小鸟

- recommend-go:用户偏好推荐系统

- react-selenium-ui-test-example:示例项目显示了如何将Selenium Webdriver与Mocha结合使用以在本地环境中运行UI级别测试

- AttachmentManager:附件管理器库从Android设备中选择文件图像

- Excel模板财务报表-现金收支日记账.zip

- jquery-browserblacklist:处理浏览器黑名单的 jQuery 插件

- 毕业设计&课设--毕业设计--在线挂号系统APP(VUE).zip

- 017.长治市行政区、公交线路、 物理站点、线路站点、建成区分布卫星地理shp文件(2021.3.28)

- yfcmf-tp6:yfcmf新版本,基于thinkphp6.0和fastadmin