神经网络结构设计:理论、方法与应用探索

"神经网络结构设计的理论和方法"

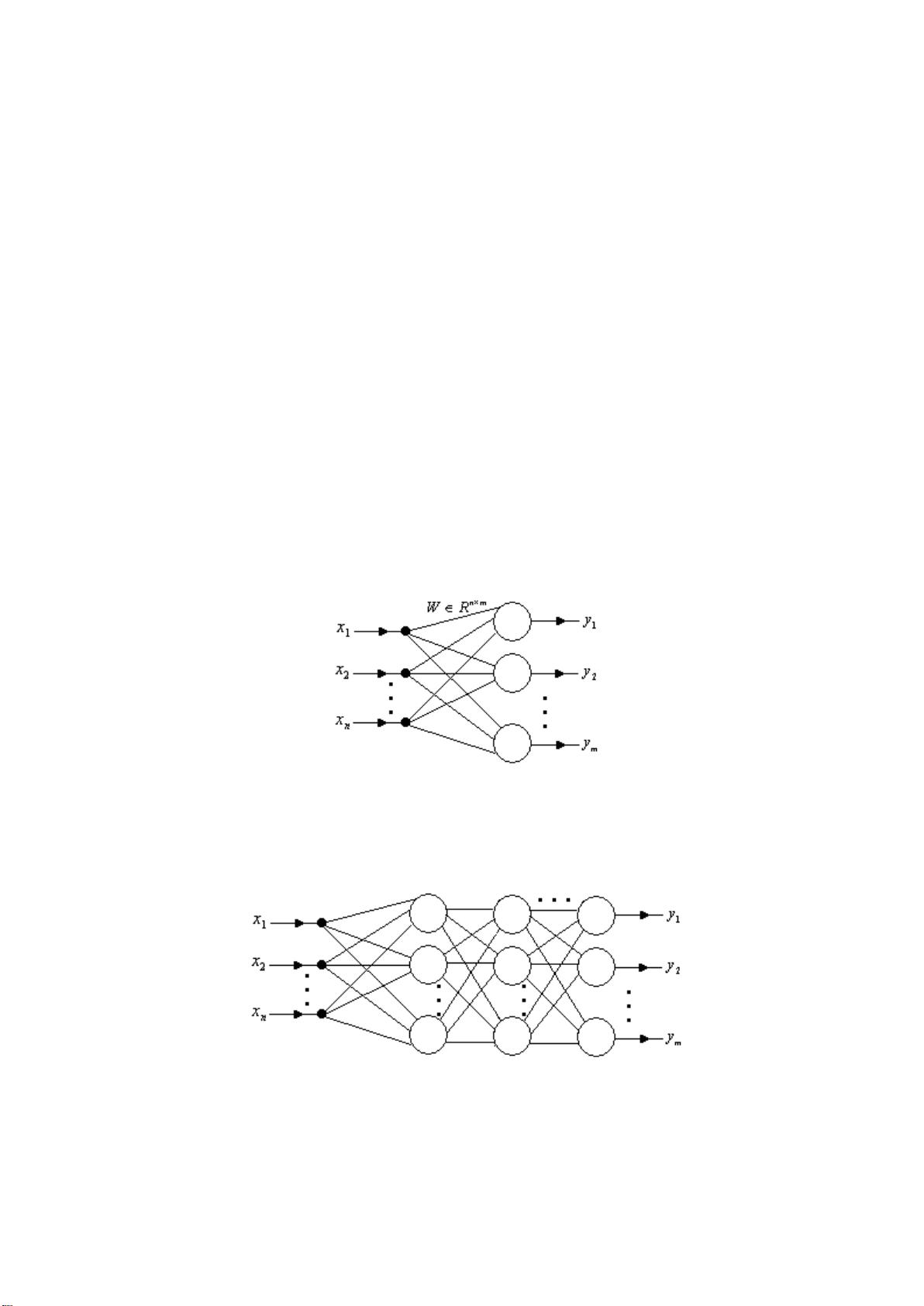

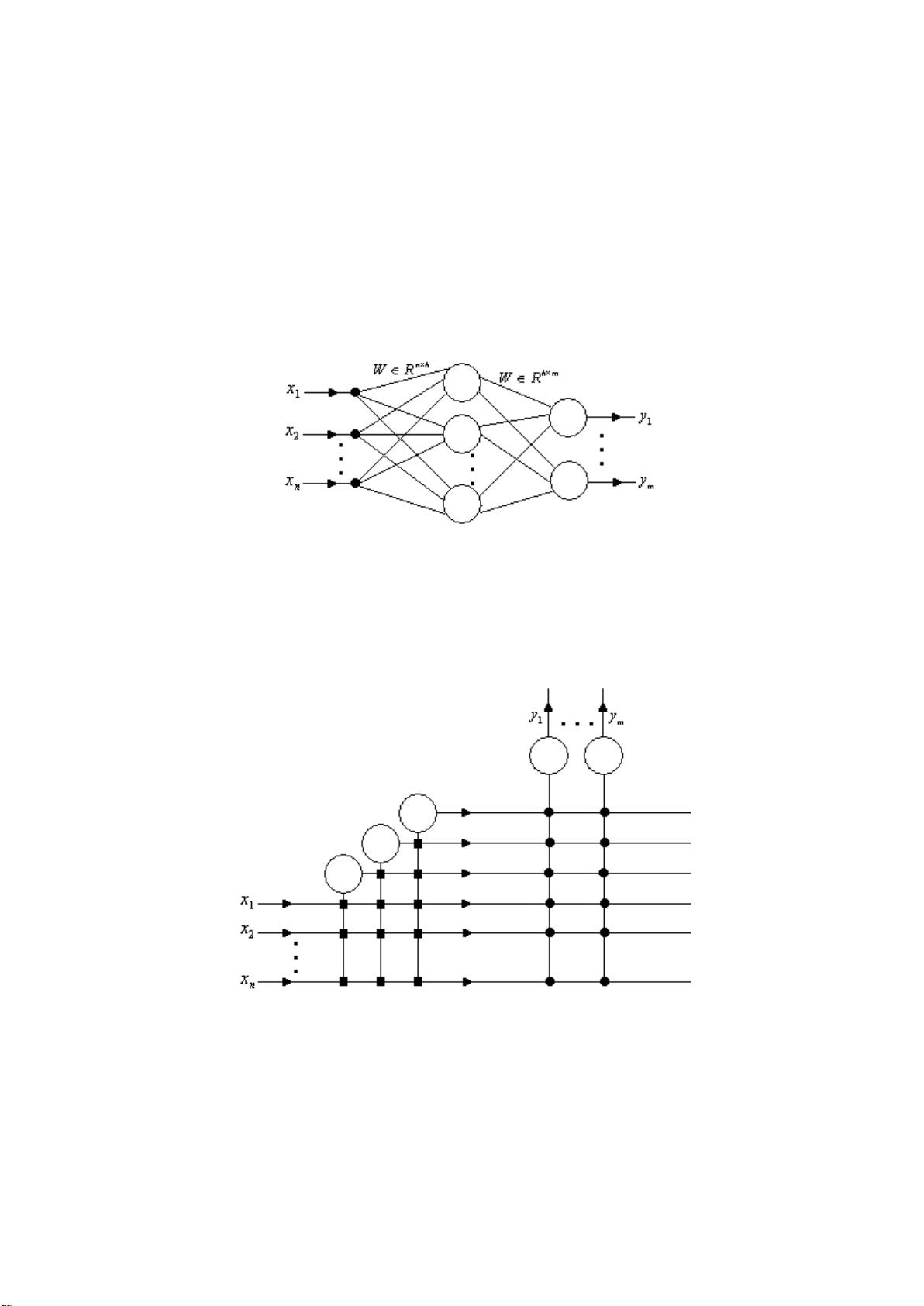

在深入探讨神经网络结构设计的理论和方法之前,我们首先需要理解神经网络的基本概念。神经网络是由大量简单计算单元,即神经元,组成的非线性系统。这些神经元通过复杂的连接方式形成网络,能够模拟人脑神经系统的信息处理机制,包括学习、记忆和决策等功能。神经网络的关键特性在于其非线性映射能力,这意味着它们可以处理非线性关系的数据,而传统线性模型往往难以胜任。此外,神经网络不依赖精确的数学模型,而是通过调整连接权重来学习输入输出之间的关系,这使得它们在数据驱动的学习任务中表现出色。

神经网络的发展历程可大致分为几个阶段。首先是初始发展期,这个阶段见证了神经网络模型的诞生。W.McCulloch和W.Pitts的MP模型奠定了神经元模型的基础,而D.Hebb的学习规则解释了大脑如何通过参与活动强化神经连接。接着,F.Rosenblat的感知器模型和B.Widrow与M.Hoff的自适应线性单元分别引入了早期的分类和自适应系统概念。

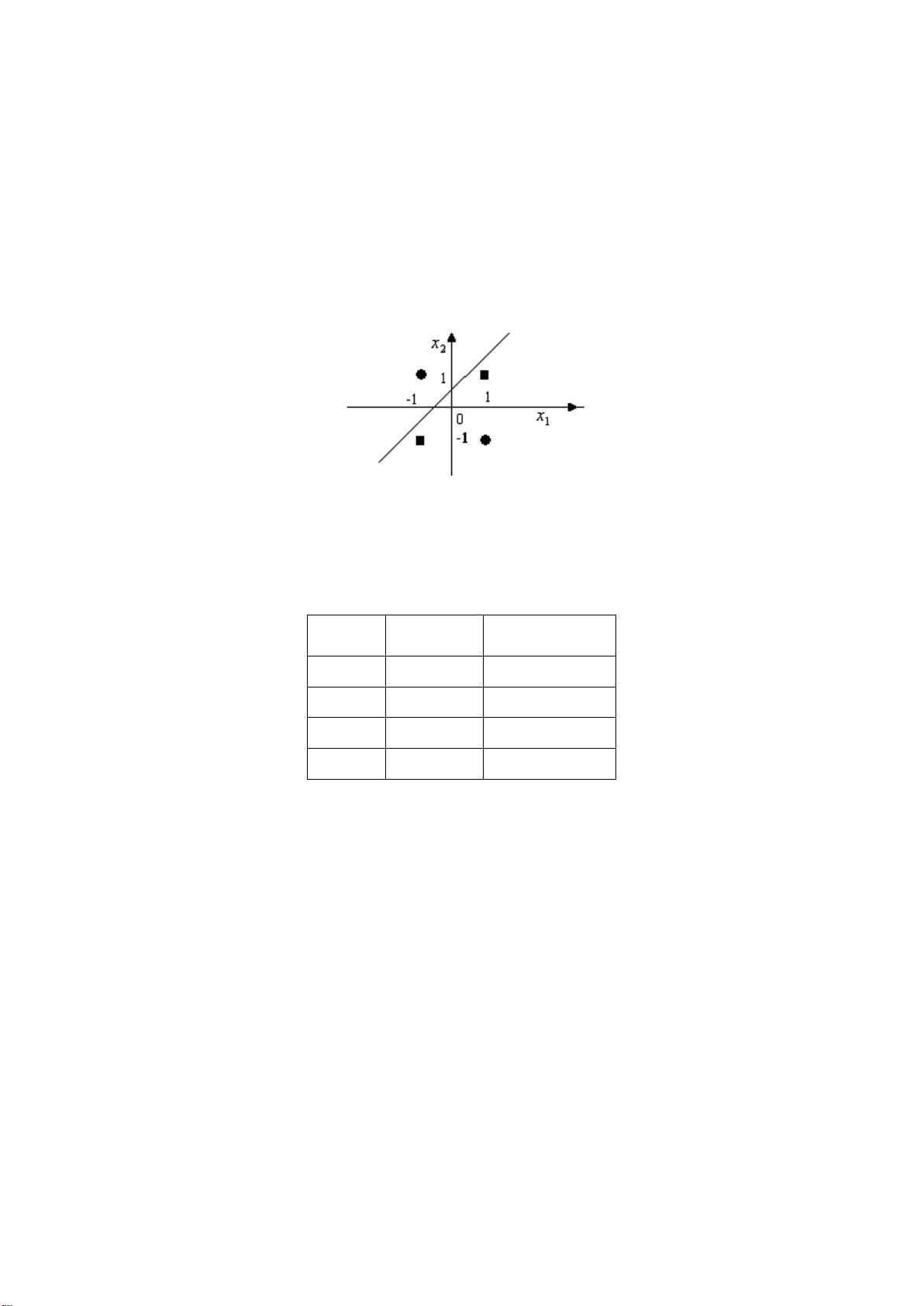

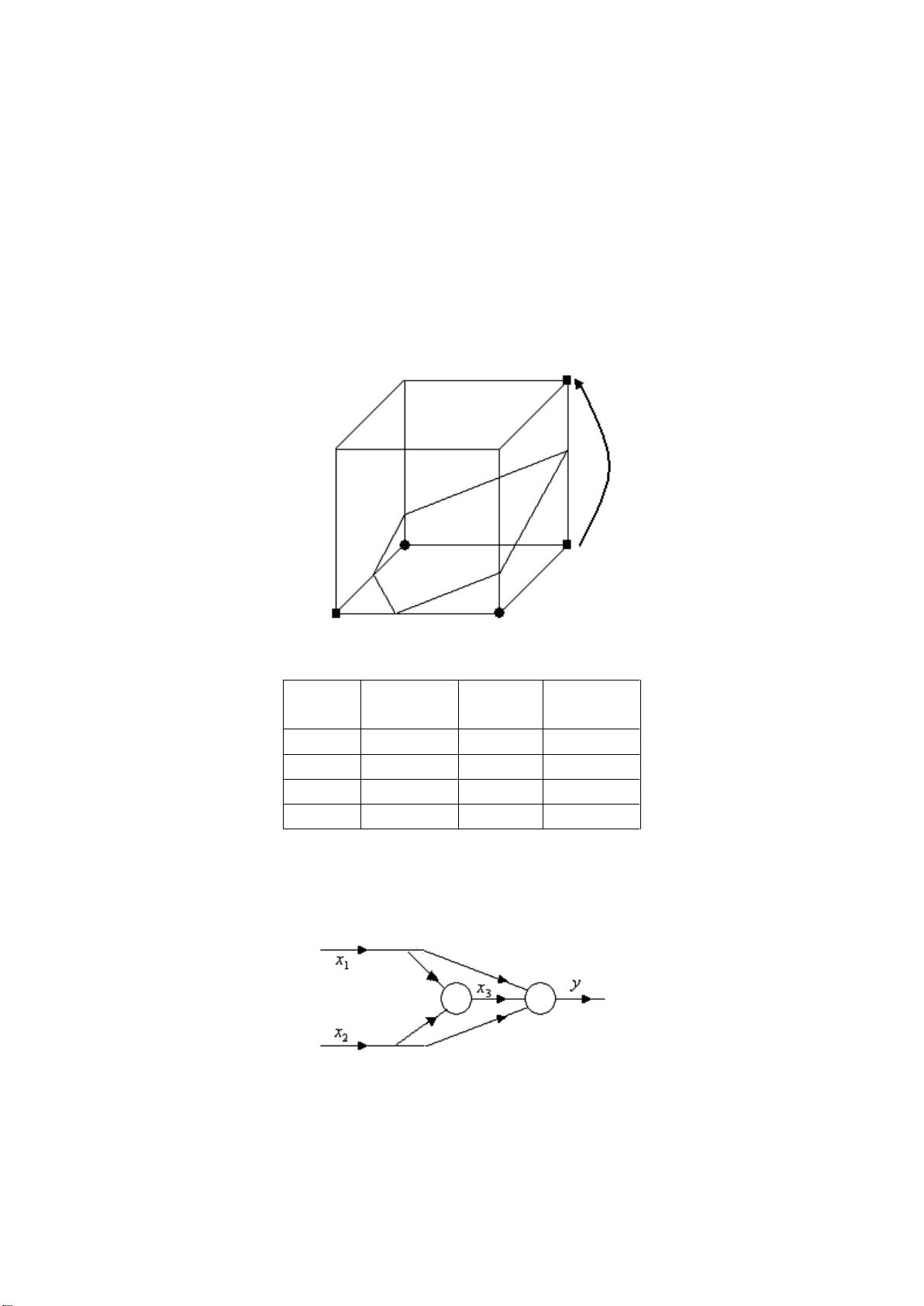

然而,1969年M.Minsky和S.Papert的《感知器》一书对单层感知器的局限性的揭示导致了神经网络研究的一段低潮。他们指出单层感知器只能处理线性可分问题,而多层网络的学习算法尚未明确,这引发了学术界的质疑。尽管如此,H.Hopfield在低潮期的研究仍然取得了突破,他提出的Hopfield网络引入了能量函数的概念,用于处理联想记忆和优化问题。

随着计算能力的提升和算法的进步,神经网络进入了复兴期。1986年,Rumelhart、Hinton和Williams等人提出的反向传播算法(BP算法)[Rumetal1986]解决了多层神经网络的学习问题,为神经网络的广泛应用打开了大门。BP算法使得神经网络在图像识别、语音处理等领域取得了一系列重大进展。

随后,神经网络的结构设计进一步发展,出现了多种复杂的网络架构,如卷积神经网络(CNN)用于图像处理,循环神经网络(RNN)用于序列数据,以及后来的长短期记忆网络(LSTM)和门控循环单元(GRU)解决了RNN中的梯度消失和爆炸问题。此外,深度学习的兴起推动了深度神经网络(DNN)的发展,多层结构的神经网络在各种任务中展现出强大的性能,例如在ImageNet大赛中,AlexNet、VGG、ResNet等模型接连刷新记录。

近年来,随着强化学习(Reinforcement Learning, RL)和生成对抗网络(GAN)的出现,神经网络的应用范围进一步扩展到游戏策略、自然语言处理、图像生成等领域。这些先进的网络结构和学习方法不断推动着人工智能的进步,使得神经网络成为现代科技领域不可或缺的一部分。

总结来说,神经网络结构设计的理论和方法涵盖了从早期的简单模型到复杂深度网络的演变,以及相应的学习算法和优化技术的发展。这些理论和实践的结合使得神经网络能够在诸多实际问题中找到解决方案,极大地推动了信息技术和人工智能的发展。

2019-08-14 上传

2010-01-22 上传

2019-08-14 上传

2019-08-14 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

lxf_2008

- 粉丝: 0

- 资源: 9

最新资源

- 基于元胞自动机的拓扑排序算法(pdf)

- RISC-DSP组合处理器设计优化

- ATL-之深入淺出,ATL是ActiveX Template Library 的缩写,它是一套C++模板库。

- c语言的面相对象设计

- GCC中文手册-gcc中文手册-相当详细的使用讲解手册

- VB小程序随即选数程序源码

- CSS及其应用 书籍

- 图书馆管理系统 需求分析

- IC生产流程与测试系统

- 达内实训笔记相关下载

- RDLC使用手册v2

- Quartus常见错误分析.doc

- VC++ 中实现进制2进制,10进制,16进制的相互转换

- IFIX 154学生手册

- Thinking.In.Java.3rd.Edition.Chinese.eBook

- css2.0高级技巧