理解word2vec:斯坦福CS224n作业二解析

需积分: 9 60 浏览量

更新于2024-09-06

收藏 291KB PDF 举报

"这是斯坦福大学CS224n课程关于word2vec的作业描述,主要涉及word2vec算法的理解和应用。"

在自然语言处理领域,word2vec是一种广泛使用的模型,它通过学习词汇在语料库中的上下文关系来表示单词的分布式向量。这个模型由Tomas Mikolov等人提出,它主要分为两种变体:连续词袋模型(CBOW)和 Skip-gram 模型。这里我们主要讨论的是Skip-gram模型,它是作业的重点。

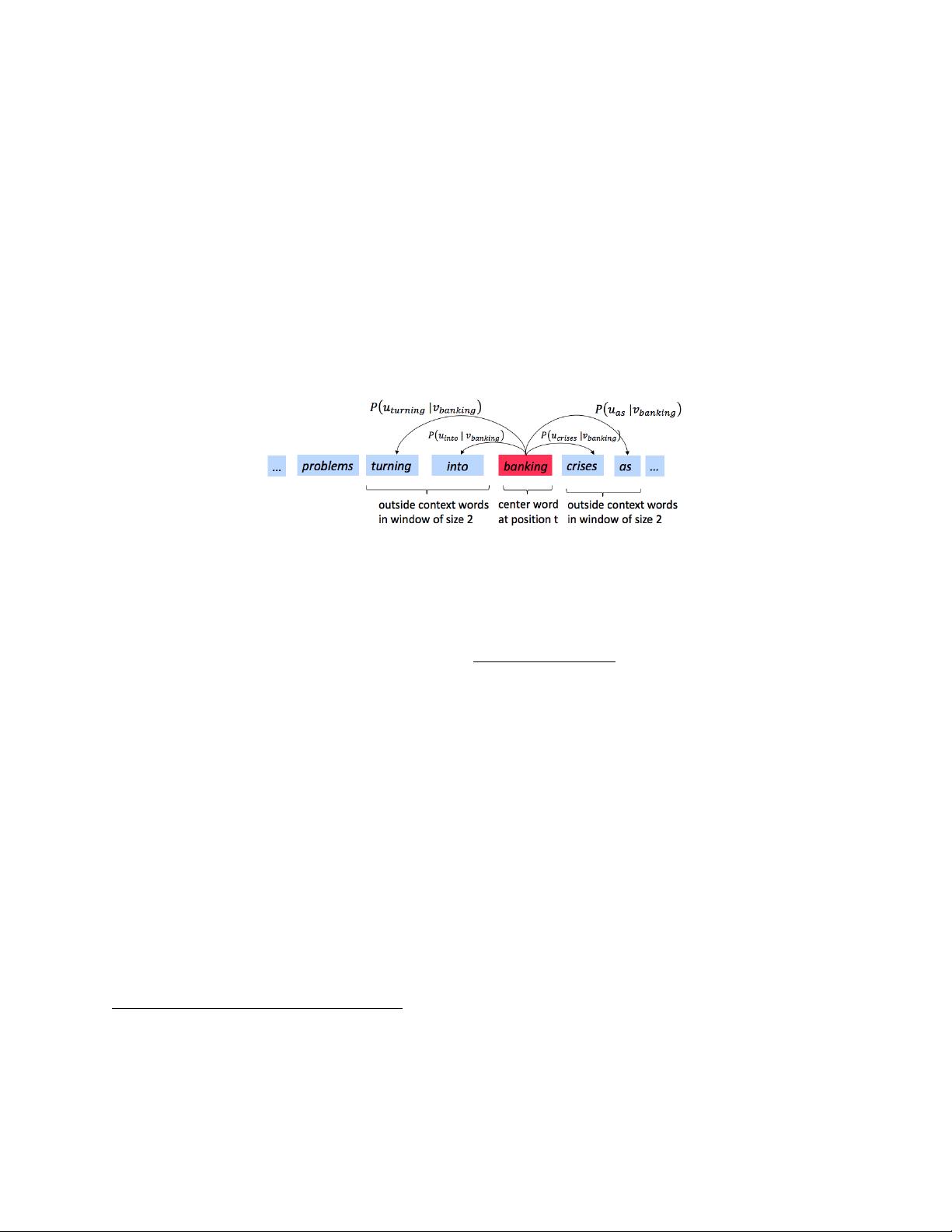

Skip-gram模型的核心思想是“一个词可以通过它的上下文来理解”(a word is known by the company it keeps)。换句话说,模型试图预测一个中心词周围的上下文词。在给定的描述中,例如中心词是"banking",上下文窗口大小为2,那么“turning”,“into”,“crises”,和“as”就是上下文词,即“outside words”。

模型的目标是准确地学习条件概率分布P(O|C),即给定中心词C时,预测上下文词O的概率。具体来说,P(O=o|C=c)是中心词为c时,出现特定的上下文词o的概率。

在word2vec中,这个条件概率分布是通过向量内积和softmax函数来计算的。这里的向量包括中心词的向量表示\(v_c\)和上下文词的向量表示\(u_o\)。公式可以表示为:

\[ P(O=o|C=c) = \frac{exp(u^\top ov_c)}{\sum_{w \in \text{Vocab}} exp(u^\top wv_c)} \]

其中,Vocab是词汇表,包含了所有可能的单词。softmax函数使得所有概率之和为1,确保了概率的合理性。向量\(u\)和\(v\)是通过训练数据学习得到的,它们捕捉了词与词之间的语义关系。

训练过程中,模型通常采用负采样或者Hierarchical Softmax等方法优化计算效率。负采样是在每个训练步骤中,除了真实的上下文词之外,还会随机选择一些“负样本”单词进行预测,这样可以减少计算复杂度。

在实际应用中,word2vec模型表现出强大的能力,能够捕捉到词汇之间的隐含关系,比如“king”-“man”="queen"-"woman"这样的类比关系。它也被广泛应用在推荐系统、文本分类、情感分析等任务中。

这份作业将要求学生深入理解word2vec的工作原理,包括其数学模型和训练过程,并可能涉及到模型优化、参数调整等方面的内容。完成这个作业需要对神经网络、概率论和矩阵运算有较好的理解。

185 浏览量

260 浏览量

399 浏览量

193 浏览量

209 浏览量

184 浏览量

2018-12-24 上传

2021-05-07 上传

224 浏览量

三七、

- 粉丝: 25

- 资源: 1

最新资源

- c++新手必看,手把手教你c++

- java课件, 包含多线程

- 数据库函数实例的小例子 有助于初学者更好的理解存储过程的操作

- Administracion Tomcat

- 易学c++初学者的好帮手

- java课件,入门者可以来参考一下

- OpenCms7教程(3)

- Patterns of Enterprise Application Architecture

- Architectural Blueprints—The “4+1” View英文

- OpenCms7教程(2).pdf

- 《计算机网络》课后习题答案

- Applying Domain Driven Design and Patterns

- A quick guide to CISSP certification

- 高质量C++C 编程指南.

- icc编译器中文使用说明

- JSP高级编程,详细介绍JSP的开发知识