分布式环境下的限流策略:Redis RateLimiter与Guava Token Bucket

需积分: 0 111 浏览量

更新于2024-07-01

收藏 331KB PDF 举报

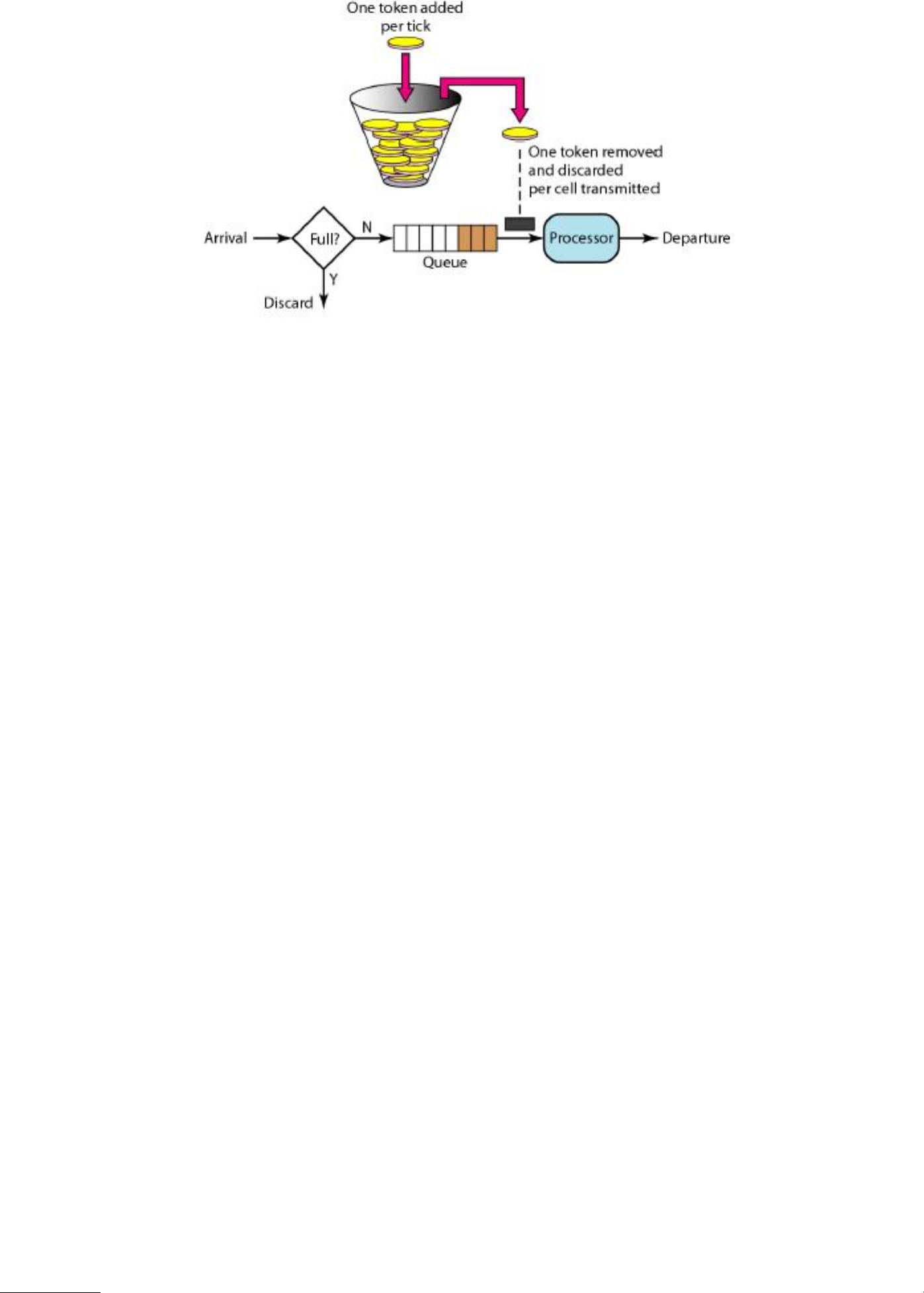

分布式环境下,为了应对高并发和保护系统稳定性,限流成为了一种必要的策略。本资源主要讨论了在分布式环境中如何实现限流,特别是针对服务商接口的访问限制,以避免超出服务商的服务上限导致的拒绝服务问题。文中提到了三种限流方案:Guava的RateLimiter、Token Bucket算法和Leaky Bucket算法,并具体介绍了使用Redis实现限流的方法。

首先,我们来看业务背景。在大规模的推广活动中,例如发送营销短信,可能会涉及到千万级别的用户群体。由于服务商接口的处理能力有限(例如400条/s),而业务方调用接口的速度无法预知,可能高达800/s或更高。在这种情况下,如果不限流,将可能导致服务商接口的超负荷,进而影响服务质量和数据丢失。此外,系统是分布式部署,所有节点都共享同一个服务商接口,因此需要在多个节点上实施一致的限流策略。

接下来,我们详细分析需求和设计:

1. 接口限流:由于业务方调用频率不可控,必须在业务层限制对服务商接口的调用,以确保接口的可用性。

针对这一需求,提出了三种限流方案:

- 方案一:使用Guava的RateLimiter。RateLimiter基于令牌桶算法,可以预先设定每秒允许处理的请求数(如400)。在每次调用接口之前,尝试获取一个令牌,如果获取成功则执行短信发送逻辑,否则等待或放弃此次请求。

- 方案二:利用Java的DelayQueue实现延迟队列,通过设置延迟时间来控制请求的处理速度。虽然实现较为复杂,但可以实现限流效果。

- 方案三:基于Redis实现限流。利用Redis的原子操作特性,设置两个Key,一个用于计时,一个用于计数。每次请求到来时,计数器加1,如果在预设的时间内计数未超过阈值,则允许处理任务。这种方法可以实现分布式环境下的限流,因为多个节点可以共享Redis中的状态。

以上三种方案各有优缺点,Guava的RateLimiter实现简单,适用于大多数情况;DelayQueue提供了更灵活的控制,但实现较为复杂;Redis方案则适用于分布式环境,可以保证多节点间的一致性。

在实际应用中,可以根据系统的具体需求和资源状况选择合适的限流策略。例如,如果系统主要关注的是稳定性和一致性,Redis方案可能是最佳选择。而如果对性能有较高要求,且系统规模较小,Guava的RateLimiter可能更为合适。在设计限流方案时,还需要考虑系统的扩展性和可维护性,以便在未来的业务增长中能够灵活调整。

3338 浏览量

181 浏览量

1296 浏览量

246 浏览量

170 浏览量

121 浏览量

226 浏览量

141 浏览量

148 浏览量

牛站长

- 粉丝: 33

最新资源

- Ruby语言集成Mandrill API的gem开发

- 开源嵌入式qt软键盘SYSZUXpinyin可移植源代码

- Kinect2.0实现高清面部特征精确对齐技术

- React与GitHub Jobs API整合的就业搜索应用

- MATLAB傅里叶变换函数应用实例分析

- 探索鼠标悬停特效的实现与应用

- 工行捷德U盾64位驱动程序安装指南

- Apache与Tomcat整合集群配置教程

- 成为JavaScript英雄:掌握be-the-hero-master技巧

- 深入实践Java编程珠玑:第13章源代码解析

- Proficy Maintenance Gateway软件:实时维护策略助力业务变革

- HTML5图片上传与编辑控件的实现

- RTDS环境下电网STATCOM模型的应用与分析

- 掌握Matlab下偏微分方程的有限元方法解析

- Aop原理与示例程序解读

- projete大语言项目登陆页面设计与实现