深度解析:卷积神经网络结构与典型应用

需积分: 46 23 浏览量

更新于2024-07-18

收藏 21.48MB PDF 举报

"卷积神经网络结构细讲"

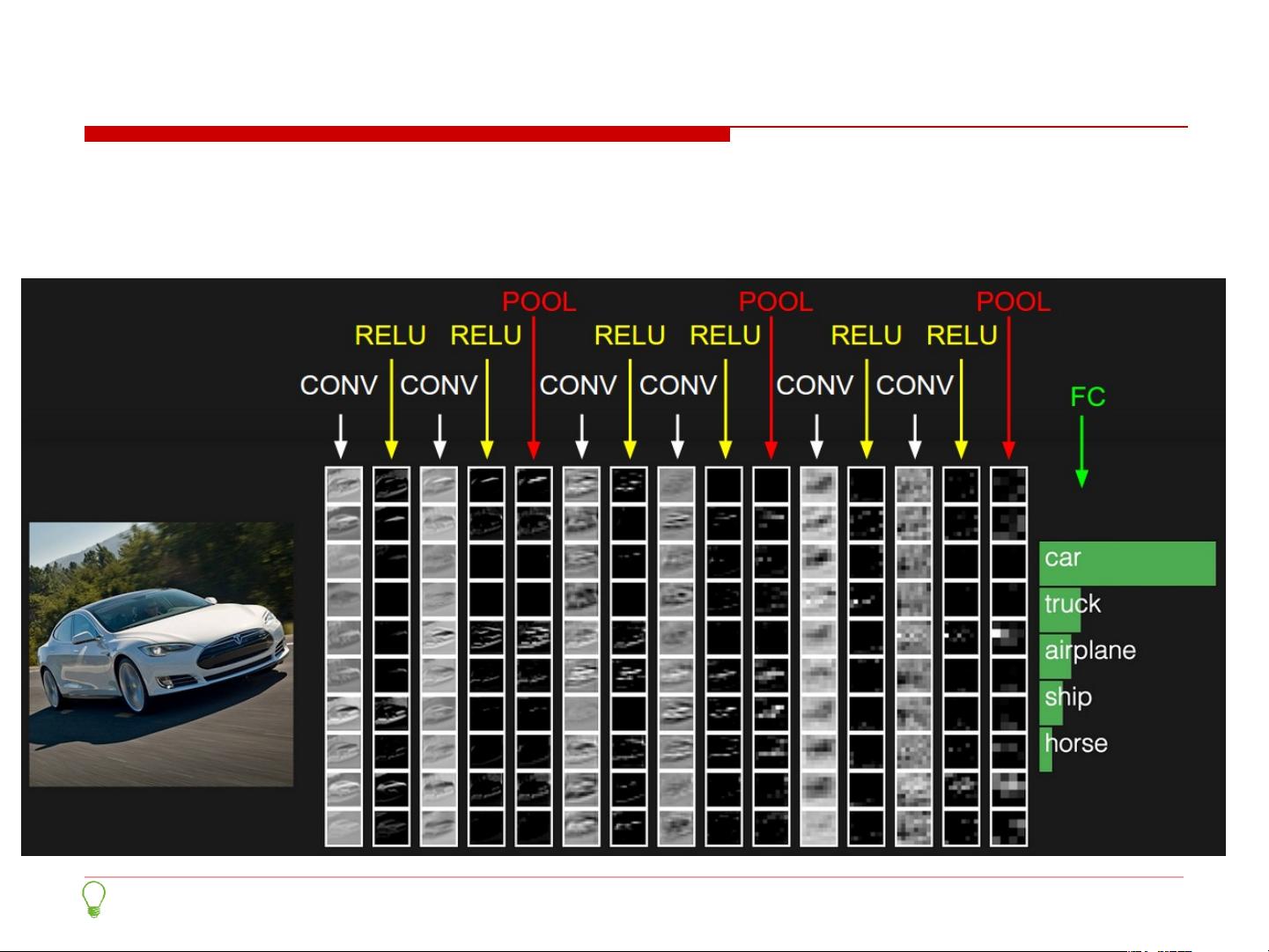

卷积神经网络(Convolutional Neural Network,简称CNN)是深度学习领域中的重要模型,尤其在计算机视觉任务中表现出色。CNN的特点在于其层级结构,每层执行不同的运算和功能,使得网络能够自动学习图像特征。

1. 层级结构

CNN通常包含以下几个主要层次:

- 数据输入层:输入图像或其他类型的数据,可以进行预处理,如去均值、归一化或PCA白化。

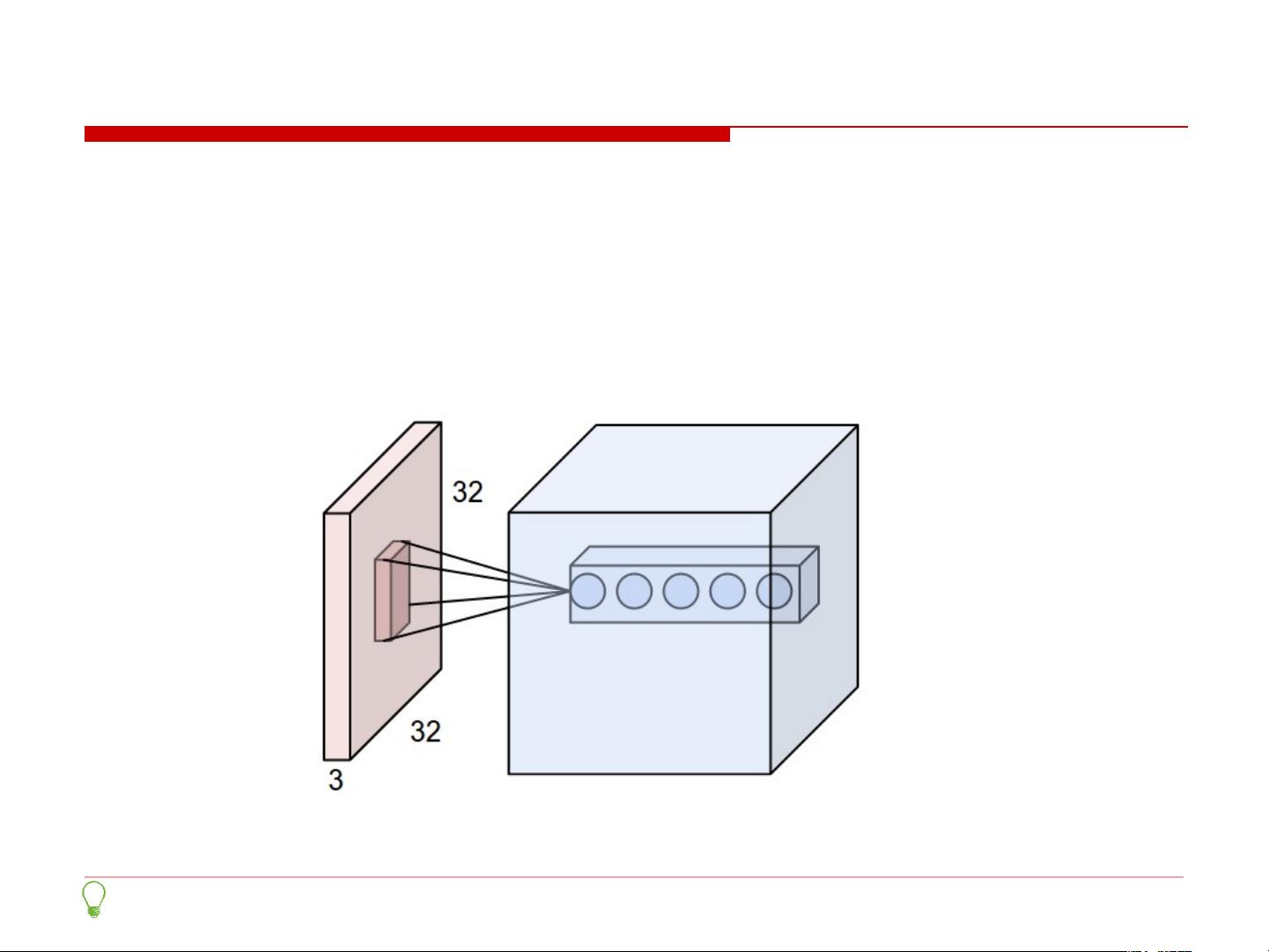

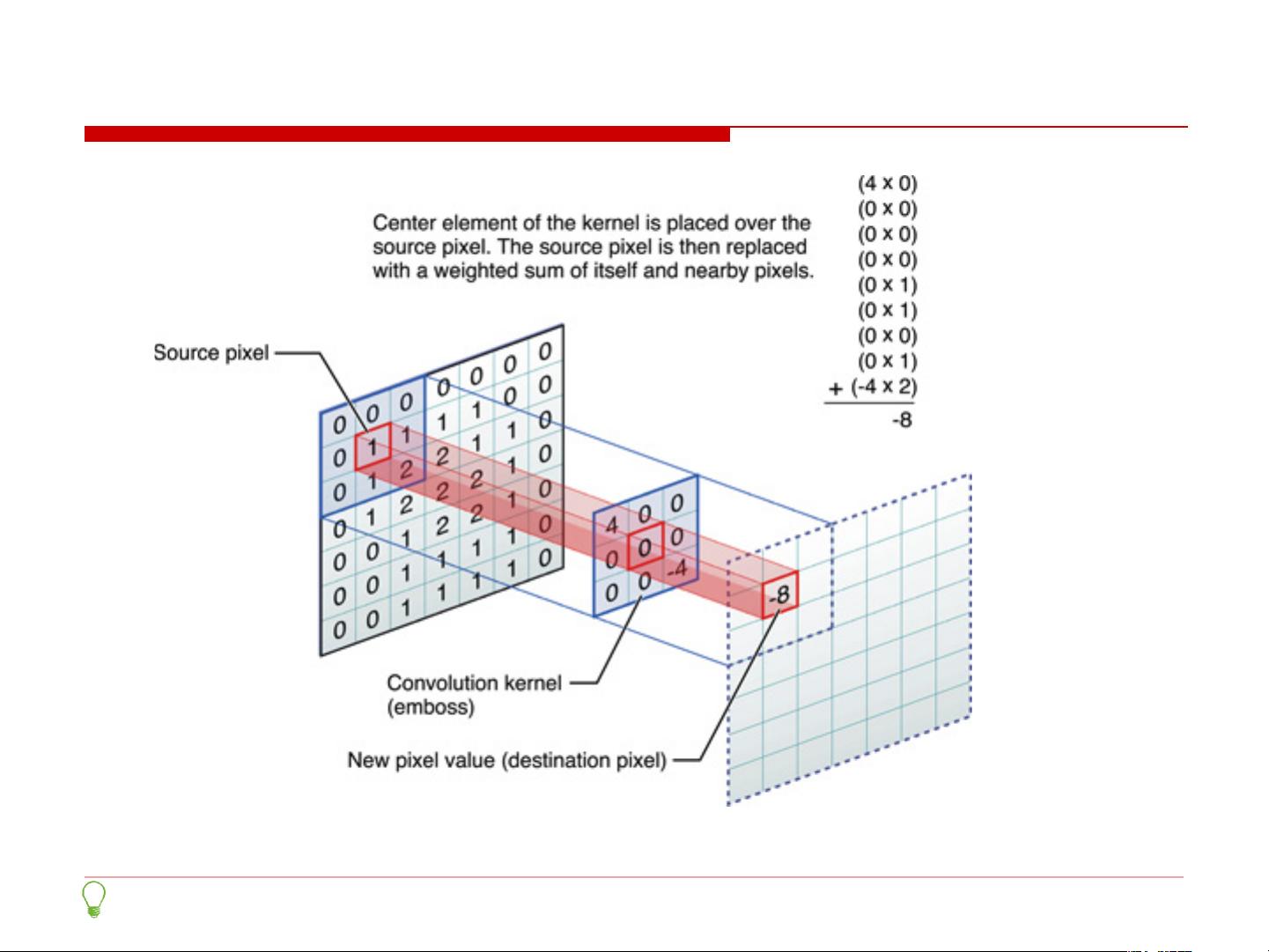

- 卷积计算层:通过卷积核(filter)对输入数据进行扫描,提取特征。卷积层利用局部关联性,每个神经元只与输入的一小部分区域相连。

- 激励层:如ReLU激活函数,用于引入非线性,激发网络的学习能力。

- 池化层:通常使用最大池化或平均池化,减少数据维度,提高计算效率并防止过拟合。

- 全连接层:将前几层的特征图扁平化,连接到一个全连接的神经网络,用于分类或回归任务。

- Batch Normalization层:可选,用于加速训练,减小内部协变量位移。

2. 数据处理

- 去均值:将输入数据的每个维度均值调整为0,以消除全局偏置。

- 归一化:缩放数据到特定范围,如[-1, 1]或[0, 1],使得网络更容易收敛。

- PCA/白化:主成分分析用于降维,白化则是在特征轴上进行幅度归一化,使数据分布更接近高斯分布,减少特征间的相关性。

3. 正则化与Dropout

Dropout是一种正则化技术,它在训练过程中随机“关闭”一部分神经元,以防止模型过度依赖某些特征,增加模型的泛化能力。理解Dropout的关键在于它在训练期间引入不确定性,促使网络学习更鲁棒的特征表示。

4. 典型CNN架构

- LeNet:早期的经典CNN,用于手写数字识别。

- AlexNet:2012年ImageNet竞赛的胜者,首次证明了深度CNN在图像识别上的优越性。

- VGGNet:以深度著称,使用较小的3x3卷积核构建深网络。

- GoogLeNet (Inception Network):引入Inception模块,同时使用不同大小的卷积核来捕捉不同尺度的特征。

- ResNet:通过残差块解决深度网络的梯度消失问题,实现更深的网络架构。

- DenseNet:连接每一层到后面所有层,提高特征重用,减少参数数量。

5. 训练与调优

- 训练过程包括前向传播、损失计算、反向传播和权重更新。

- 调优策略包括超参数调整、学习率调度、早停法、数据增强等。

无论您是深度学习的新手还是有经验的从业者,理解这些基本的CNN组件、正则化技术以及典型结构对于构建和优化自己的模型都至关重要。通过不断学习和实践,您可以在解决实际问题时更好地运用这些知识。

2021-06-10 上传

2022-07-13 上传

2022-11-15 上传

2022-07-15 上传

点击了解资源详情

tianguiyuyu

- 粉丝: 235

- 资源: 7

最新资源

- Java毕业设计项目:校园二手交易网站开发指南

- Blaseball Plus插件开发与构建教程

- Deno Express:模仿Node.js Express的Deno Web服务器解决方案

- coc-snippets: 强化coc.nvim代码片段体验

- Java面向对象编程语言特性解析与学生信息管理系统开发

- 掌握Java实现硬盘链接技术:LinkDisks深度解析

- 基于Springboot和Vue的Java网盘系统开发

- jMonkeyEngine3 SDK:Netbeans集成的3D应用开发利器

- Python家庭作业指南与实践技巧

- Java企业级Web项目实践指南

- Eureka注册中心与Go客户端使用指南

- TsinghuaNet客户端:跨平台校园网联网解决方案

- 掌握lazycsv:C++中高效解析CSV文件的单头库

- FSDAF遥感影像时空融合python实现教程

- Envato Markets分析工具扩展:监控销售与评论

- Kotlin实现NumPy绑定:提升数组数据处理性能