word2vec:词嵌入技术与NLP应用详解

需积分: 9 27 浏览量

更新于2024-07-09

收藏 9.23MB PDF 举报

"第6课:词嵌入(word2vec)与相关应用"是一份深入讲解自然语言处理(NLP)中词嵌入技术的教程,由七月在线的寒小阳在2016年12月11日提供。该课程介绍了NLP处理方法的发展,从传统的基于规则方法(如HMM、CRF、SVM、LDA和CNN等)转向现代基于统计机器学习的方法,其中词嵌入是关键环节。

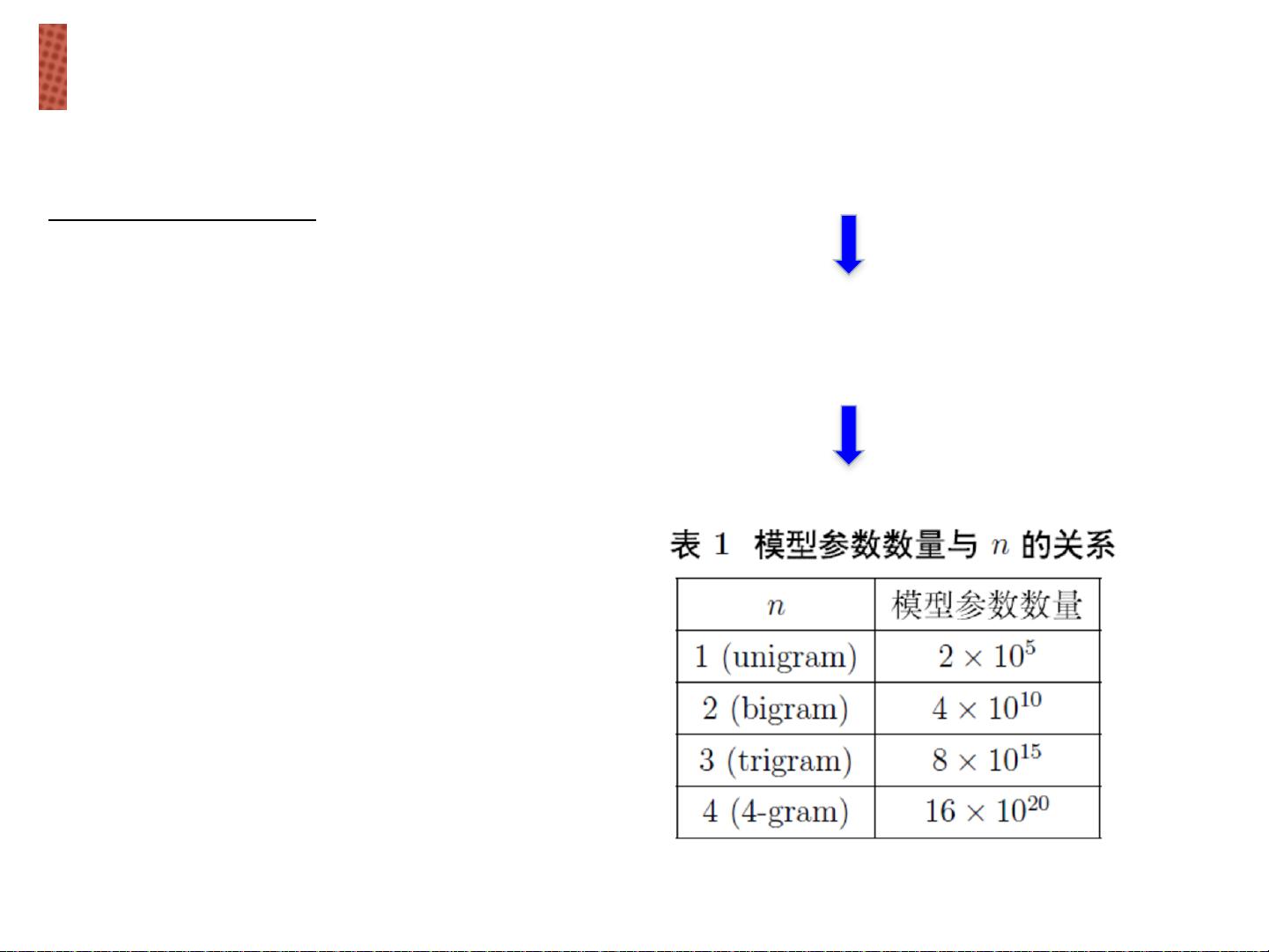

词嵌入是一种将文本中的词语转换为数值向量的技术,它旨在捕捉词汇的语义和语法关系。其核心思想是让计算机理解词与词之间的相似性和上下文关联,从而解决传统离散表示(如One-hot和Bag-of-Words)存在的问题,如缺乏对细节差别的精确表达、需要大量人工构建规则、主观性强、难以处理新词以及难以准确计算词间相似度。

在word2vec算法中,主要有两种模型形式:连续词袋模型(CBOW)和Skip-Gram模型。CBOW通过上下文预测中心词,而Skip-Gram则相反,通过中心词预测上下文。这些模型能够学习到词向量的分布式表示,即词向量在高维空间中形成的向量空间结构,使得相似的词在空间上更接近,比如VKing-VQueen+VWomen=VMan这样的加法关系。

课程还提到,词嵌入的一个重要应用是在深度学习中作为输入和表示空间,比如在情感分析、文本分类、机器翻译等任务中,词向量可以作为神经网络的输入,传递语义信息,提升模型的性能。此外,词嵌入还能帮助处理同义词和上位词的关系,提高模型对语境的理解能力。

本课程深入探讨了词嵌入技术在NLP领域的应用价值,对比了离散表示与词嵌入的优缺点,并通过实际例子展示了词向量在解决NLP任务时的优势,是理解和掌握现代自然语言处理技术的重要参考资料。

2019-09-15 上传

2019-09-27 上传

2024-11-17 上传

2024-11-17 上传

2024-11-17 上传

2024-11-17 上传

2024-11-17 上传

2024-11-17 上传

灿烂李

- 粉丝: 391

- 资源: 115

最新资源

- SSM Java项目:StudentInfo 数据管理与可视化分析

- pyedgar:Python库简化EDGAR数据交互与文档下载

- Node.js环境下wfdb文件解码与实时数据处理

- phpcms v2.2企业级网站管理系统发布

- 美团饿了么优惠券推广工具-uniapp源码

- 基于红外传感器的会议室实时占用率测量系统

- DenseNet-201预训练模型:图像分类的深度学习工具箱

- Java实现和弦移调工具:Transposer-java

- phpMyFAQ 2.5.1 Beta多国语言版:技术项目源码共享平台

- Python自动化源码实现便捷自动下单功能

- Android天气预报应用:查看多城市详细天气信息

- PHPTML类:简化HTML页面创建的PHP开源工具

- Biovec在蛋白质分析中的应用:预测、结构和可视化

- EfficientNet-b0深度学习工具箱模型在MATLAB中的应用

- 2024年河北省技能大赛数字化设计开发样题解析

- 笔记本USB加湿器:便携式设计解决方案