视觉-LiDAR-IMU实时里程计:融合算法与资源优化

版权申诉

105 浏览量

更新于2024-06-27

收藏 423KB DOCX 举报

本文主要探讨的是基于视觉、LiDAR与IMU的实时无人车里程计的研究,这是一种关键的技术,对于自动驾驶汽车的精确导航和环境理解至关重要。里程计模块负责车辆在三维空间中的运动估计,通过整合来自不同传感器的数据,如LiDAR的点云信息、摄像头的视觉特征以及IMU的加速度和陀螺仪读数,实现高精度的定位。

首先,作者回顾了现有的一些解决方案。浙江大学的研究团队[1]采用MSCKF框架的LIC-Fusion方法,通过融合LiDAR的几何特征和稀疏视觉特征,实现了传感器间的时空参数在线标定,从而提高定位精度。MIT的LVI-SAM系统[2]则强调了在视觉或激光传感器失效时的鲁棒性,确保了在低纹理或缺乏特征的环境下仍能保持稳定性能。

Kaarta公司的工作[3]提出了一种递进式的运动估计策略,首先利用IMU预估,然后通过视觉惯性里程计进行初步计算,最后通过激光点云的融合进行精细校正,这种方法有效地利用了后续信息来减少IMU误差。香港大学的R2LIVE框架[4]将滤波器和因子图优化模型结合,通过迭代卡尔曼滤波和因子图优化,兼顾了实时性和精度,同时优化了CPU和GPU资源分配。

文章的核心贡献在于提出了一种新的基于因子图优化的多传感器融合里程计。该系统通过以下创新来改进性能:

1. 改进的LiDAR前端采用了ICPCUDA算法的改造版本,提升了处理帧率,增强了在复杂环境下的精度,尤其是在退化场景下。

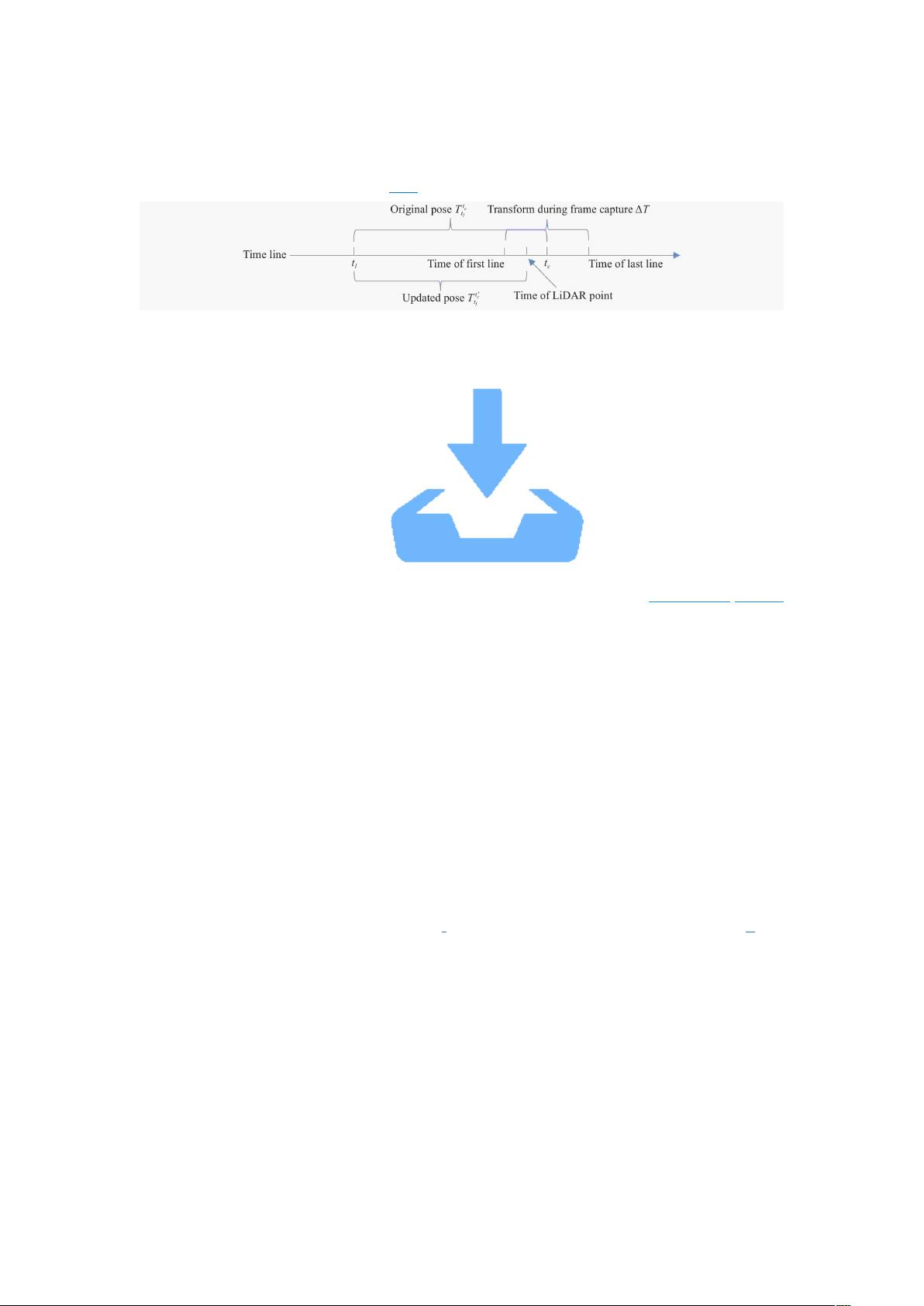

2. 视觉特征处理部分特别关注消除Rolling Shutter效应,这是快门效应在某些相机中可能导致的图像失真问题,通过这一改进,提高了视觉测量的准确性。

3. 该系统支持多种运行模式,包括全量视觉LiDAR惯性里程计(VLIO)、仅LiDAR惯性里程计(LIO)以及仅视觉惯性里程计(VIO),并允许用户选择不同的初始化方式,如LiDAR或视觉初始化,从而增加了系统的灵活性和适应性。

这项研究旨在提供一种高效且精确的实时无人车里程计解决方案,能够满足自动驾驶汽车在实际应用场景中的高需求,尤其在对计算资源有限的情况下,具有显著的实际价值。

2024-10-16 上传

2023-06-30 上传

2023-02-23 上传

2022-06-15 上传

2023-02-23 上传

2023-02-28 上传

罗伯特之技术屋

- 粉丝: 4516

- 资源: 1万+

最新资源

- MacPlayer64bit22d-苹果电脑播放器

- 支持图文点击全屏左右切换的jquery瀑布流效果

- phaser-plugin-advanced-timing:显示FPS,帧间隔和性能信息。 移相器2CE

- JS-CSS-Clock:显示实时的模拟时钟。 专为CSS和JavaScript的实践而设计

- WebAccess实战技巧一:按钮条的制作方法.rar

- connmap:connmap是X11桌面小部件,可在世界地图上显示当前网络对等设备的位置(仅使用i3wm进行了测试)。用C和libcairo制成

- 热敏传感器模块(4线制).rar

- 火车头同义词替换库伪原创词库共计16w词

- -演示移动格子

- 带模拟 退火 的 RJMCMC //随机过程_MATLAB_代码_下载

- myPortfolio:React灵敏的投资组合

- 4-互联网(含16).rar

- commons-io2.6.jar

- Construindo-o-seu-primeiro-jogo--de--naves-DIO

- 西门子 Smart Line 精彩系列面板宣传册.zip

- neurolib:易于为计算神经科学家进行全脑建模:brain::laptop::woman_scientist_dark_skin_tone: