下山法探索:梯度下降原理与Python实战指南

需积分: 10 94 浏览量

更新于2024-09-11

收藏 1.25MB DOCX 举报

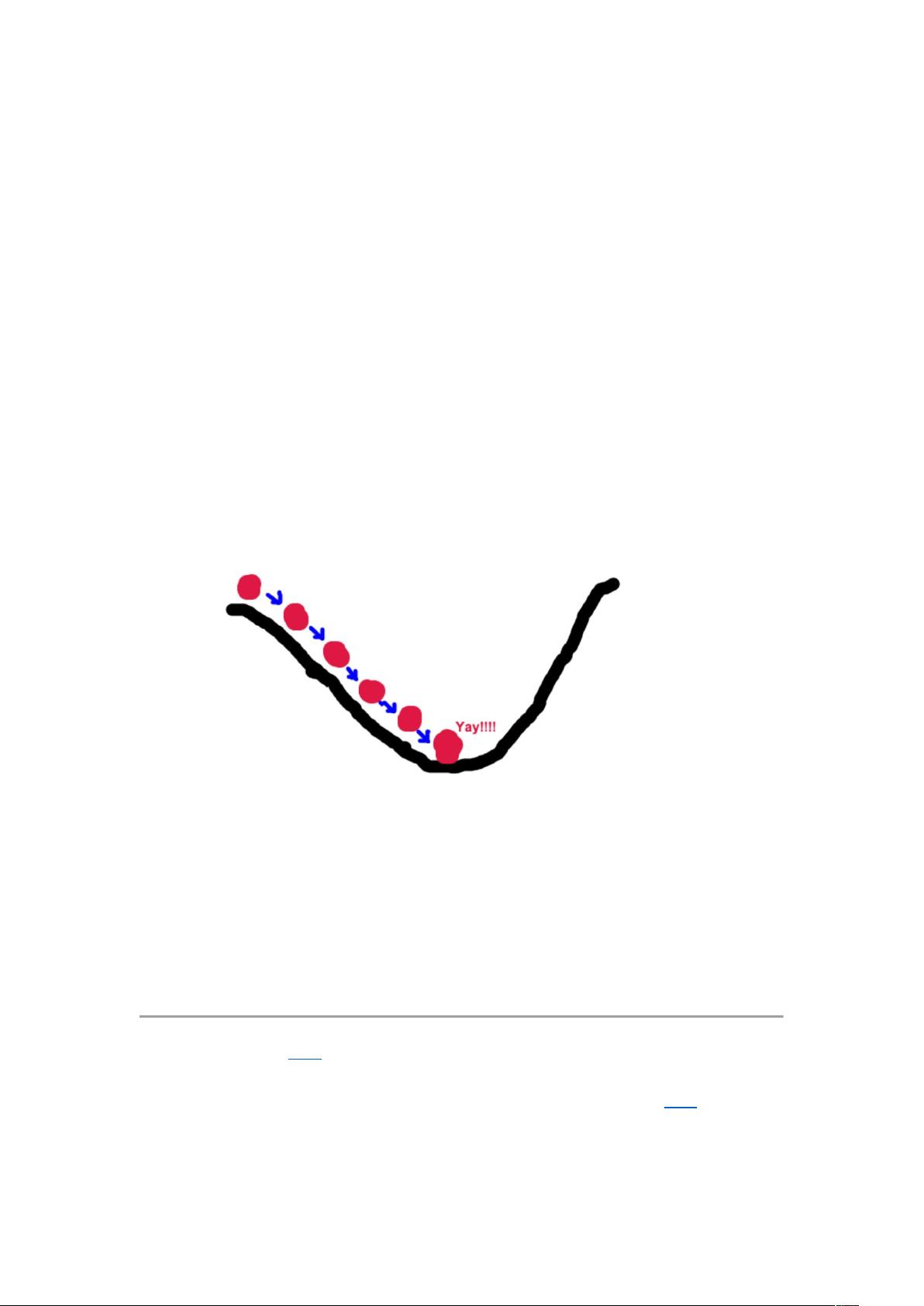

梯度下降法原理与Python实现是一篇深入讲解该优化算法的文章,它将复杂的数学概念通过生动的比喻进行阐述。文章的核心围绕梯度下降的场景假设展开,将寻找函数最小值的过程与下山过程相联系。在这个过程中,作者假设我们面对的是一个未知的、高度可微分的函数(如同山峰),目标是找到其最低点,即函数的最小值。

梯度下降的基本思想建立在梯度的概念上。梯度是函数在某一点的局部斜率,它指示了函数值上升最快的方向。在下山场景中,这相当于找到当前位置最陡峭的坡度,也就是当前位置的梯度方向,然后沿着这个方向移动,使得函数值下降。这是一种迭代的方法,每次通过计算梯度更新参数,逐步接近最小值。

文章进一步讨论了梯度下降算法的数学解释,涉及到微分的概念。微分是研究函数变化率的重要工具,它可以量化函数在某一点的变化趋势。通过求解函数的一阶导数,得到的就是梯度,它给出了函数在当前点的最优化方向。

在Python实现部分,文章将理论知识转化为实践操作,可能会包括如何定义和计算函数的梯度,选择合适的步长(学习率),以及如何处理局部最优和收敛条件。这部分可能涉及numpy或scipy库的使用,以及可能出现的梯度下降算法的不同变种,如批量梯度下降、随机梯度下降和动量梯度下降等。

此外,文章还可能提及其他考虑因素,如学习率的选择策略(如线性衰减、指数衰减等)、梯度下降的停止条件(例如达到预设的迭代次数、函数值变化小于某个阈值),以及如何在实际应用中避免陷入局部最优。

文章最后可能会给出一个具体的梯度下降算法的代码示例,展示如何在Python环境中实现并应用这一优化算法。读者可以通过这个实例理解并掌握如何在实际问题中运用梯度下降法来优化模型参数。

这篇文章旨在帮助读者深入理解梯度下降算法的工作原理,提供了一个由浅入深的学习路径,从直观的场景解释到数学公式推导,再到Python代码实现,使读者能够有效地将其应用于机器学习、深度学习等领域的模型训练中。

1108 浏览量

219 浏览量

555 浏览量

805 浏览量

2023-07-30 上传

2024-03-01 上传

122 浏览量

2022-06-28 上传

2023-02-20 上传

DownToOne

- 粉丝: 158

- 资源: 9

最新资源

- 大学生创业实训体会

- arcolinuxd-iso-dev

- ical-generator:ical-generator是一小段代码,可生成ical日历文件

- 清华同方电脑bois ip41m v1.0

- sparta-clb:MapleStory Europe的无客户端机器人

- Download Procreate For PC [Window 10]-crx插件

- 打造团队领导力DOC

- tarch-based-volatility-model:基于 T-GARCH 的非对称金融过程波动率模型。 这个 repo 包含我正在为我的硕士论文开发的研究代码

- MindShare_PCI Express Technology 3.0.zip

- 电信设备-基于傅立叶梅林变换和最大互信息理论的图像配准方法.zip

- Multimedia_Library:ENSAte GI2中的Java项目

- 任务2-K均值

- Granola:美味造型的基础

- TCP中上报与监听线程动态库.zip

- redis-desktop-manager-0.9.3.817.zip

- java简易小游戏.zip