Hadoop源码深度解析:关键组件与依赖揭秘

需积分: 41 85 浏览量

更新于2024-07-26

收藏 5.99MB PDF 举报

Hadoop源代码分析深入探讨了Google的核心计算技术在Apache Hadoop项目中的实现和影响。这个系列文章将关注Hadoop的主要组件,包括分布式文件系统HDFS(由GFS发展而来),以及其分布式计算模型MapReduce(源于Google的论文)。Hadoop的设计目标是提供一个易于使用的框架,支持大规模数据处理,从而模仿Google的内部技术Chubby(对应于ZooKeeper)、BigTable(对应于HBase)。

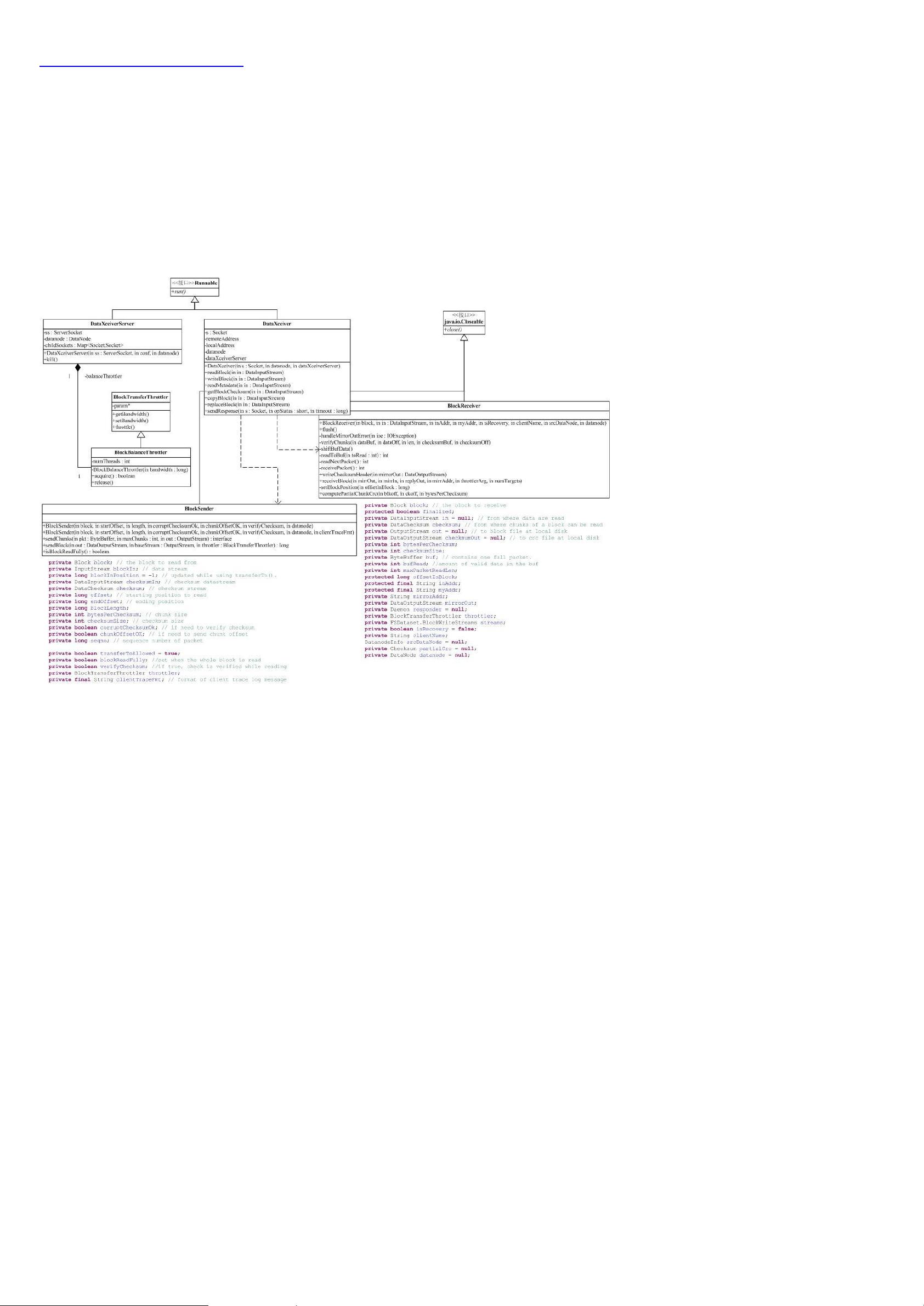

Hadoop的项目结构非常注重模块化,其中HDFS作为核心组件,为其他服务提供基础。HDFS的设计使得系统能够处理大量的分布式数据,通过API接口抽象本地和在线存储,如Amazon S3,实现了高度的可扩展性和容错性。然而,这种灵活性也导致了包间复杂的依赖关系,形成了类似蜘蛛网般的架构,如conf包依赖于fs包,后者又包含文件系统功能的抽象。

Hadoop的关键部分,如蓝色部分所示,主要集中在MapReduce库和相关的工具模块(如DistCp和archive),以及mapr包,这些是Hadoop生态系统的核心,提供了命令行工具和分布式计算能力。MapReduce的核心在于其两个关键函数:Map和Reduce,它们分别负责数据的分割和聚合,使得开发者可以编写简单的函数来处理大规模数据集。

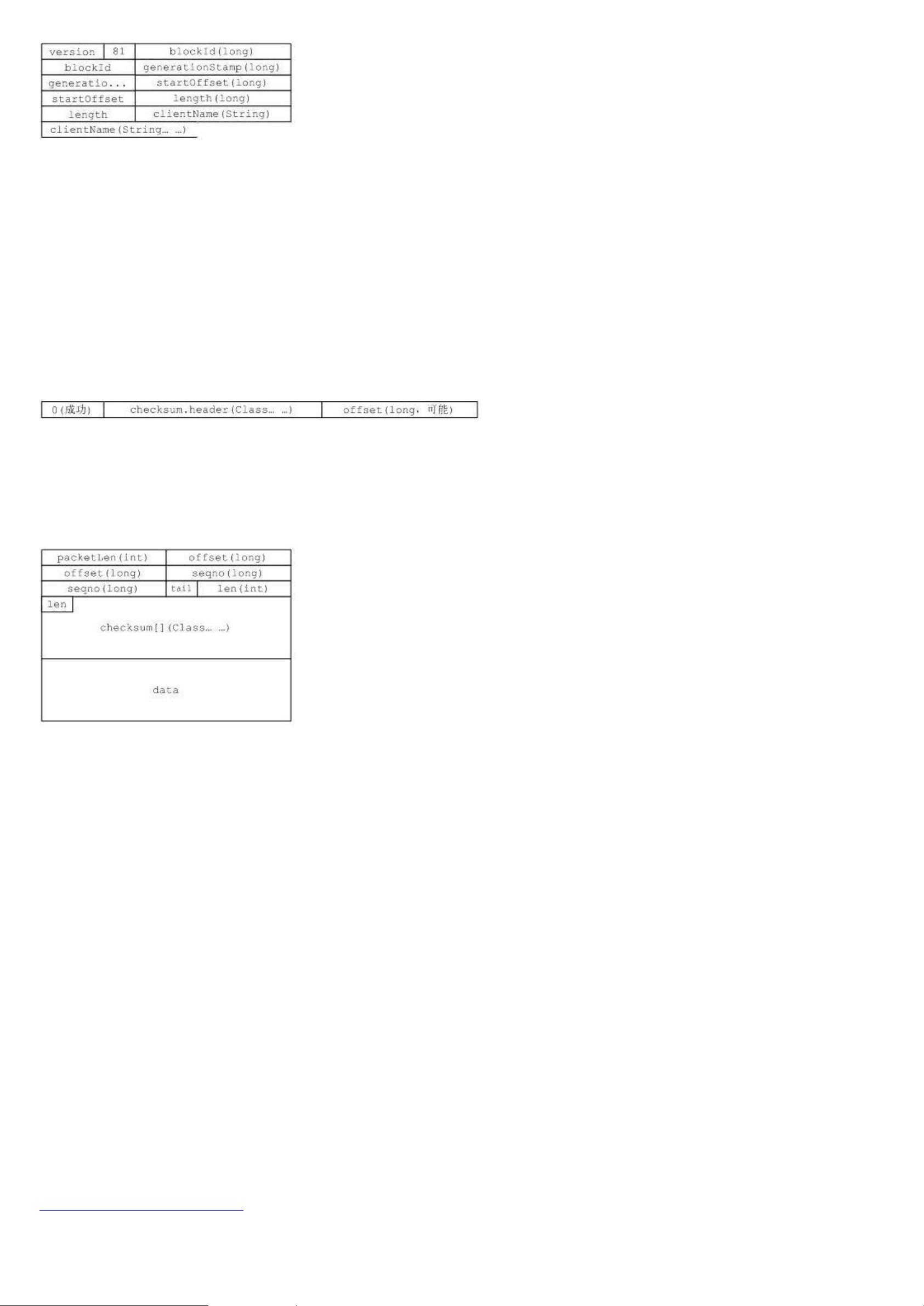

在深入研究Hadoop源代码时,开发者需要理解这些组件的工作原理,包括数据块的存储、副本策略、任务调度和数据一致性控制等。此外,还需要关注Hadoop的配置管理,因为配置文件对性能和安全性有着重要影响。通过分析源代码,开发者可以优化性能,解决潜在问题,并扩展Hadoop以适应不断变化的数据处理需求。

总结来说,Hadoop源代码分析不仅是理解分布式计算技术的基础,而且对于开发者而言,是提升技能、进行故障排查和改进系统效率的重要途径。通过逐步解析各个组件和包的交互,可以更好地掌握这个强大框架的内在机制。

773 浏览量

2016-09-09 上传

6676 浏览量

2011-05-21 上传

107 浏览量

2012-06-19 上传

2011-09-01 上传

2021-03-04 上传

2012-09-09 上传

doxdox110

- 粉丝: 0

- 资源: 2

最新资源

- CoreOS部署神器:configdrive_creator脚本详解

- 探索CCR-Studio.github.io: JavaScript的前沿实践平台

- RapidMatter:Web企业架构设计即服务应用平台

- 电影数据整合:ETL过程与数据库加载实现

- R语言文本分析工作坊资源库详细介绍

- QML小程序实现风车旋转动画教程

- Magento小部件字段验证扩展功能实现

- Flutter入门项目:my_stock应用程序开发指南

- React项目引导:快速构建、测试与部署

- 利用物联网智能技术提升设备安全

- 软件工程师校招笔试题-编程面试大学完整学习计划

- Node.js跨平台JavaScript运行时环境介绍

- 使用护照js和Google Outh的身份验证器教程

- PHP基础教程:掌握PHP编程语言

- Wheel:Vim/Neovim高效缓冲区管理与导航插件

- 在英特尔NUC5i5RYK上安装并优化Kodi运行环境