MapReduce深度解析:Hadoop大数据处理关键模式

需积分: 26 118 浏览量

更新于2024-09-14

收藏 781KB DOCX 举报

Hadoop框架详细分析

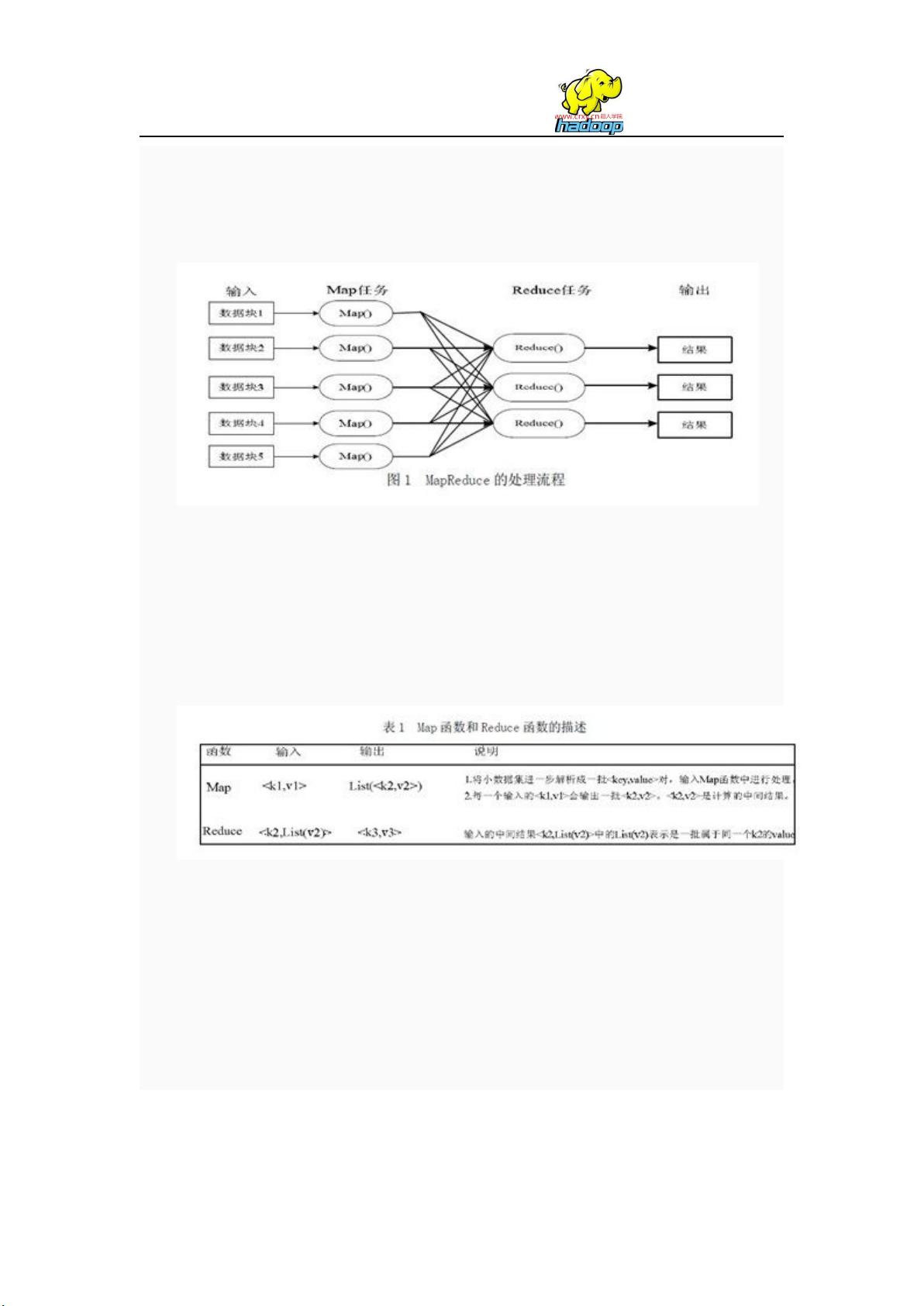

Hadoop是一个开源的大数据处理框架,其核心在于MapReduce计算模型,这是云计算领域中用于大规模数据处理的一种分布式运算技术。MapReduce的设计理念是将复杂的问题分解为简单的映射(map)和聚合(reduce)操作,使得开发者能够方便地编写可扩展的并行程序。

MapReduce的工作流程主要分为两个阶段:Map阶段和Reduce阶段。在Map阶段,数据被分割成小块,通过Map函数在各个节点上并行处理,将原始键值对转化为中间键值对。这个过程利用内存缓冲区进行数据缓存和预排序,以提高处理性能。预排序有助于在Reduce阶段时减少数据的比较次数,提高排序效率。

Reduce阶段则是对Map阶段产生的中间结果进行汇总和归并。在这个阶段,数据会被复制到Reduce节点,经过排序(通常是归并排序,如MergeSort)后再进行合并,最终得到最终的输出。Hadoop的这种设计充分考虑了数据的局部性原则,即数据在处理过程中尽可能地保持在节点附近,从而减少了数据传输,显著提升了处理效率。

Hadoop集群通常由普通PC组成,采用无共享架构,这意味着每个节点都有自己的本地存储,这样既能提高并行性,又能提供容错能力。当部分节点发生故障时,由于数据的副本策略,其他节点可以接管这些任务,确保了系统的高可用性和稳定性。

图中的作业调优参数及原理图详细展示了MapTask和ReduceTask的运行机制,包括内存管理、排序算法的选择以及任务之间的协同。理解这些细节对于优化Hadoop的性能和提升大数据处理任务的效率至关重要。

Hadoop框架通过MapReduce模型简化了大数据处理的编程难度,有效地利用分布式计算资源,实现了数据的高效处理和容错处理。掌握这一框架,对于大数据开发者来说是必备的技能,无论是数据的清洗、转换还是分析,都能在Hadoop平台上高效地完成。

2019-07-23 上传

2024-06-22 上传

点击了解资源详情

2024-09-27 上传

2024-03-22 上传

2021-08-09 上传

2021-10-12 上传

2019-07-17 上传

2014-04-02 上传

M031304

- 粉丝: 0

- 资源: 5

最新资源

- AA4MM开源软件:多建模与模拟耦合工具介绍

- Swagger实时生成器的探索与应用

- Swagger UI:Trunkit API 文档生成与交互指南

- 粉红色留言表单网页模板,简洁美观的HTML模板下载

- OWIN中间件集成BioID OAuth 2.0客户端指南

- 响应式黑色博客CSS模板及前端源码介绍

- Eclipse下使用AVR Dragon调试Arduino Uno ATmega328P项目

- UrlPerf-开源:简明性能测试器

- ConEmuPack 190623:Windows下的Linux Terminator式分屏工具

- 安卓系统工具:易语言开发的卸载预装软件工具更新

- Node.js 示例库:概念证明、测试与演示

- Wi-Fi红外发射器:NodeMCU版Alexa控制与实时反馈

- 易语言实现高效大文件字符串替换方法

- MATLAB光学仿真分析:波的干涉现象深入研究

- stdError中间件:简化服务器错误处理的工具

- Ruby环境下的Dynamiq客户端使用指南